Turing Semiconductor/AI Day潜入レポ

日本でテスラを追い抜いて完全自動運転を目指すTuring社の現在地を示す Turing Semiconductor/AI Dayが開催されたので潜入レポをお届けします。

Turing Semiconductor/AI dayの当日動画をアップロードしました! Youtubeでの全編はこちら→https://t.co/SzBqRciNUe pic.twitter.com/223iYsHZRs

— 山本一成🌤️チューリングのCEO (@issei_y) March 15, 2024

イメージビデオからスタートしました。

山本 一成さん登壇です。いきなり、AIとカメラのみでハンドルかがないEVを作るとぶち上げました。手ブレすみません。

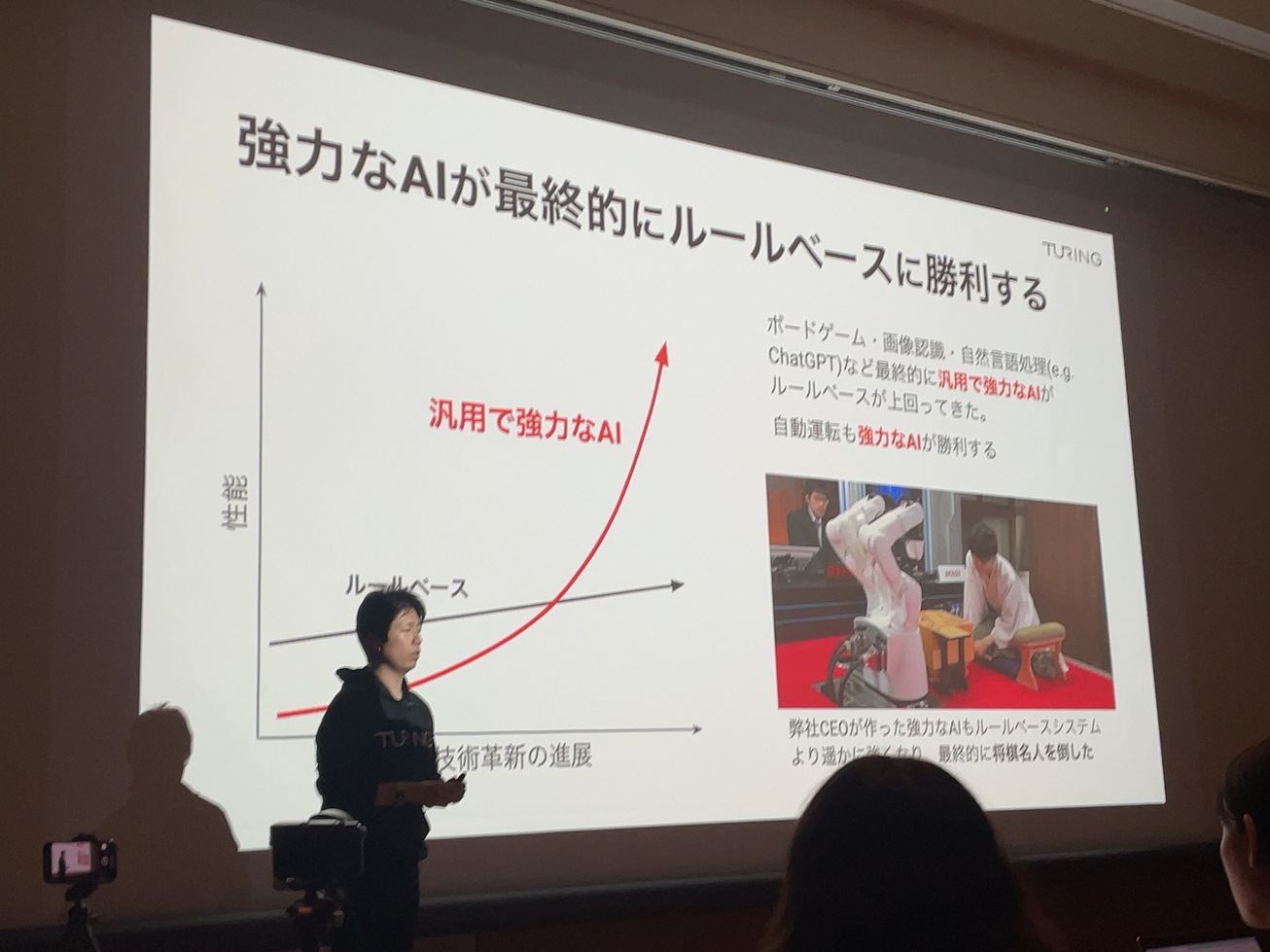

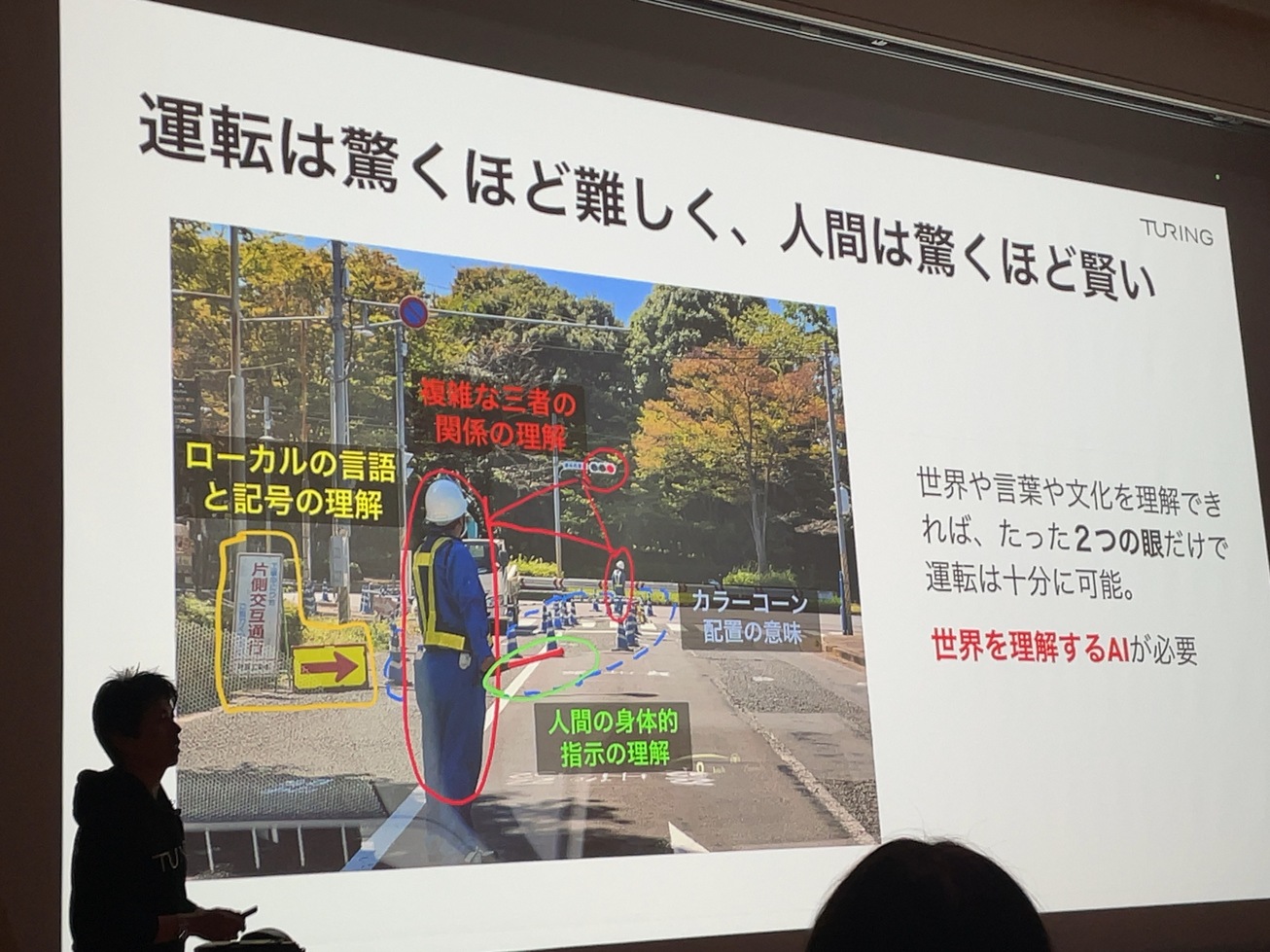

ルールベースではうまくいかない。

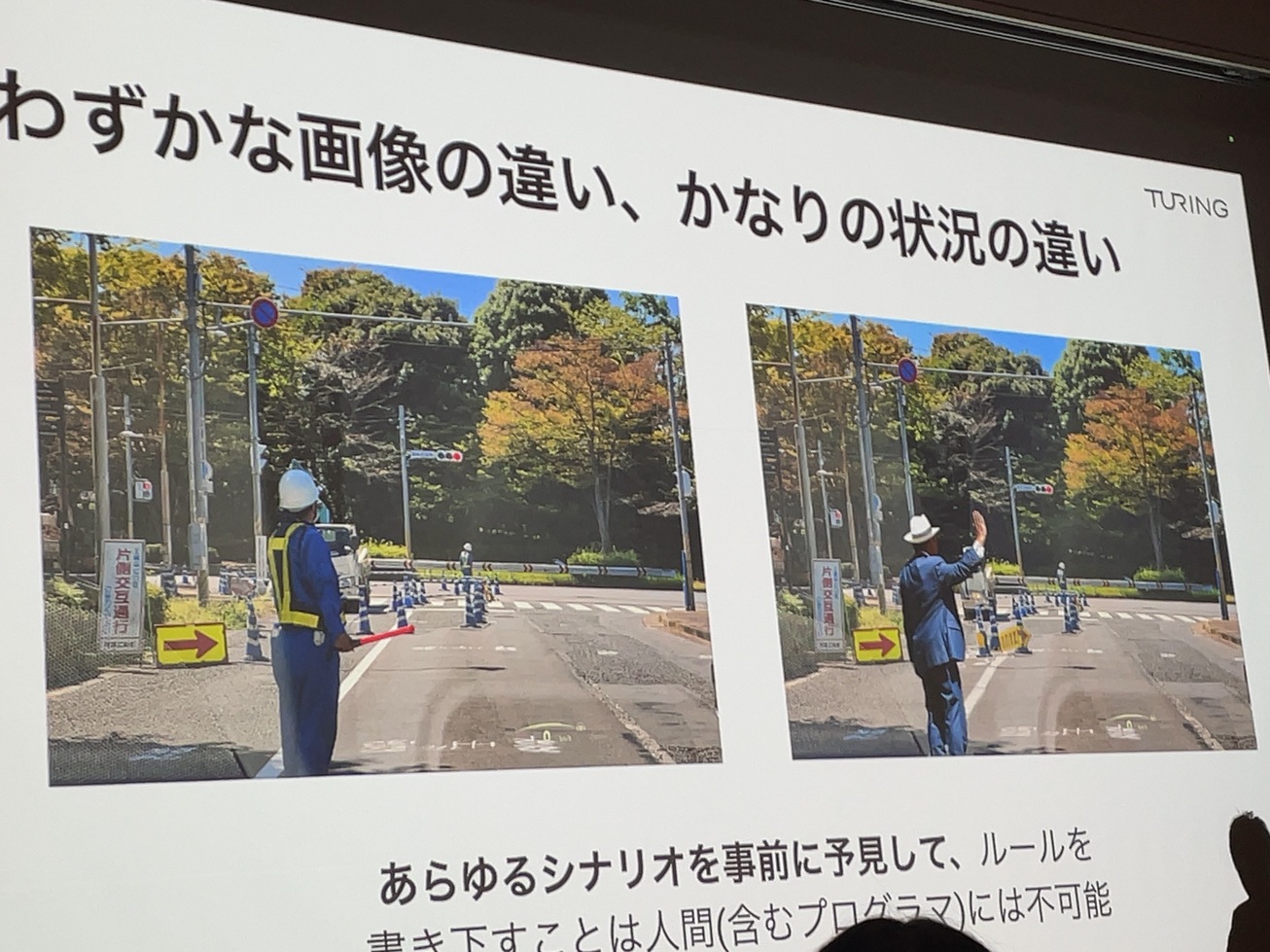

似たようなシチュエーションでも大分違う操作が必要。

車が世界を理解する必要がある。これをルールベースでやるのは大変。世界を理解するAIが必要。

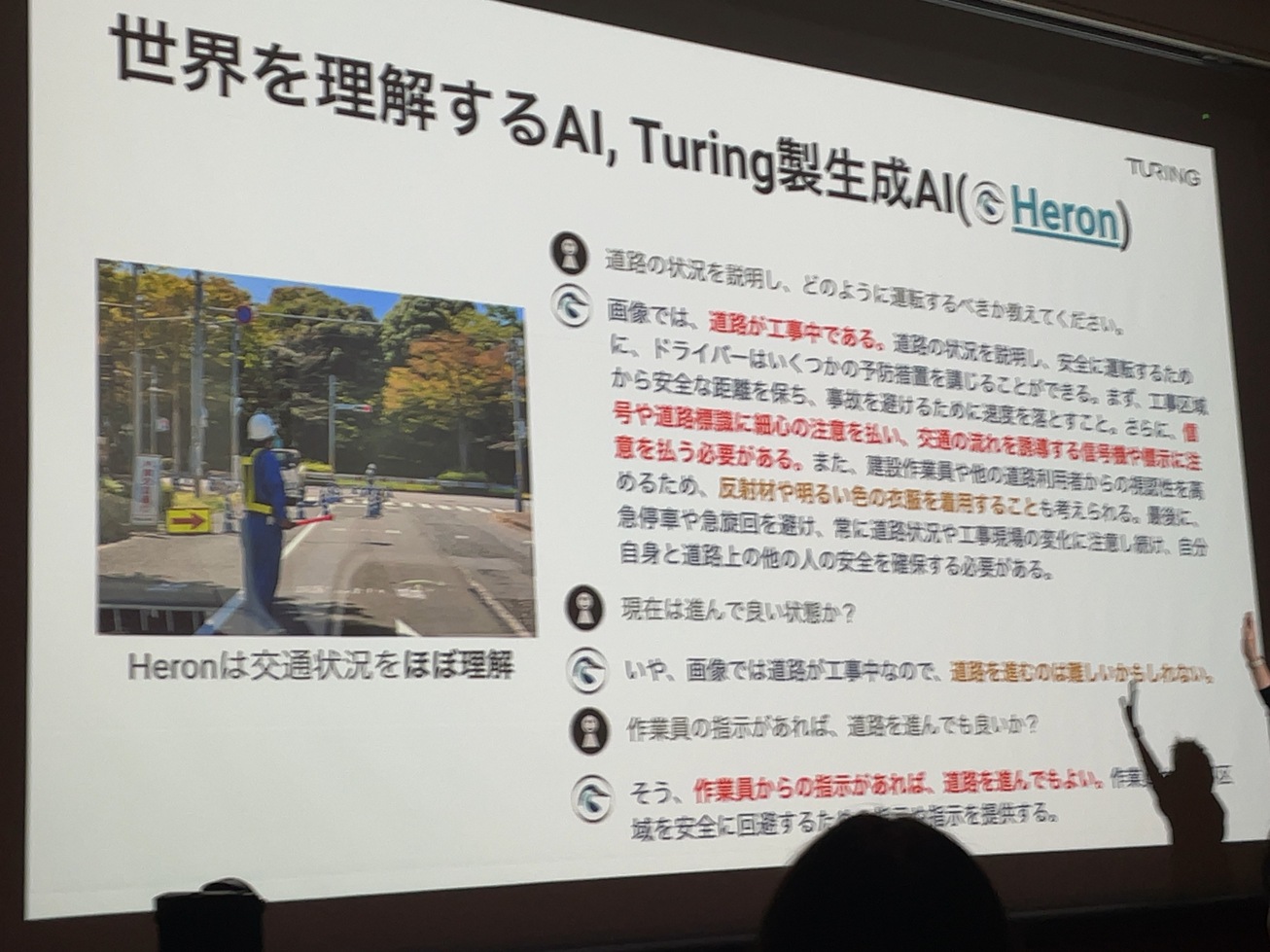

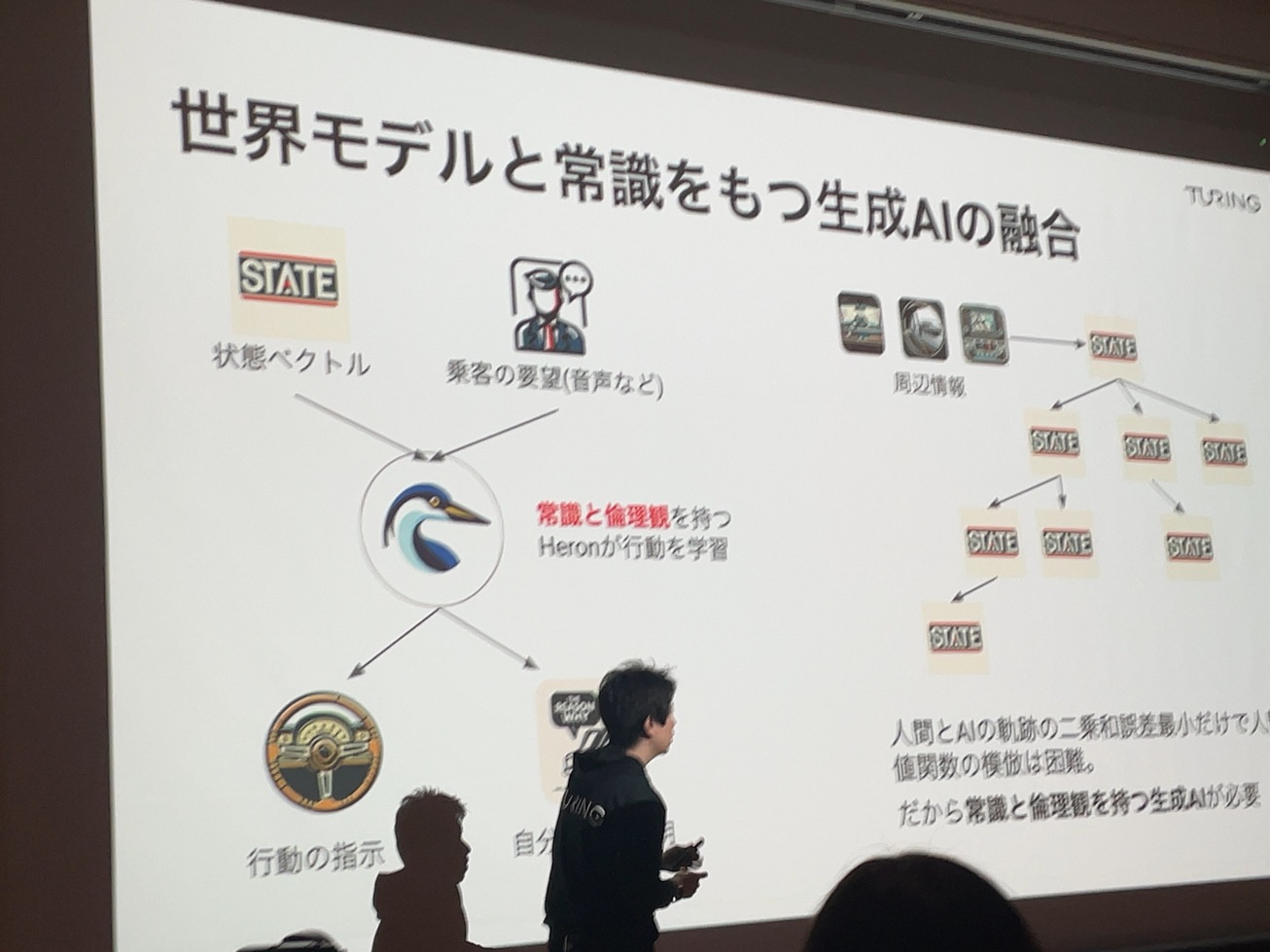

マルチモーダルのHeronをリリースした。Heronは世界を大分理解している。

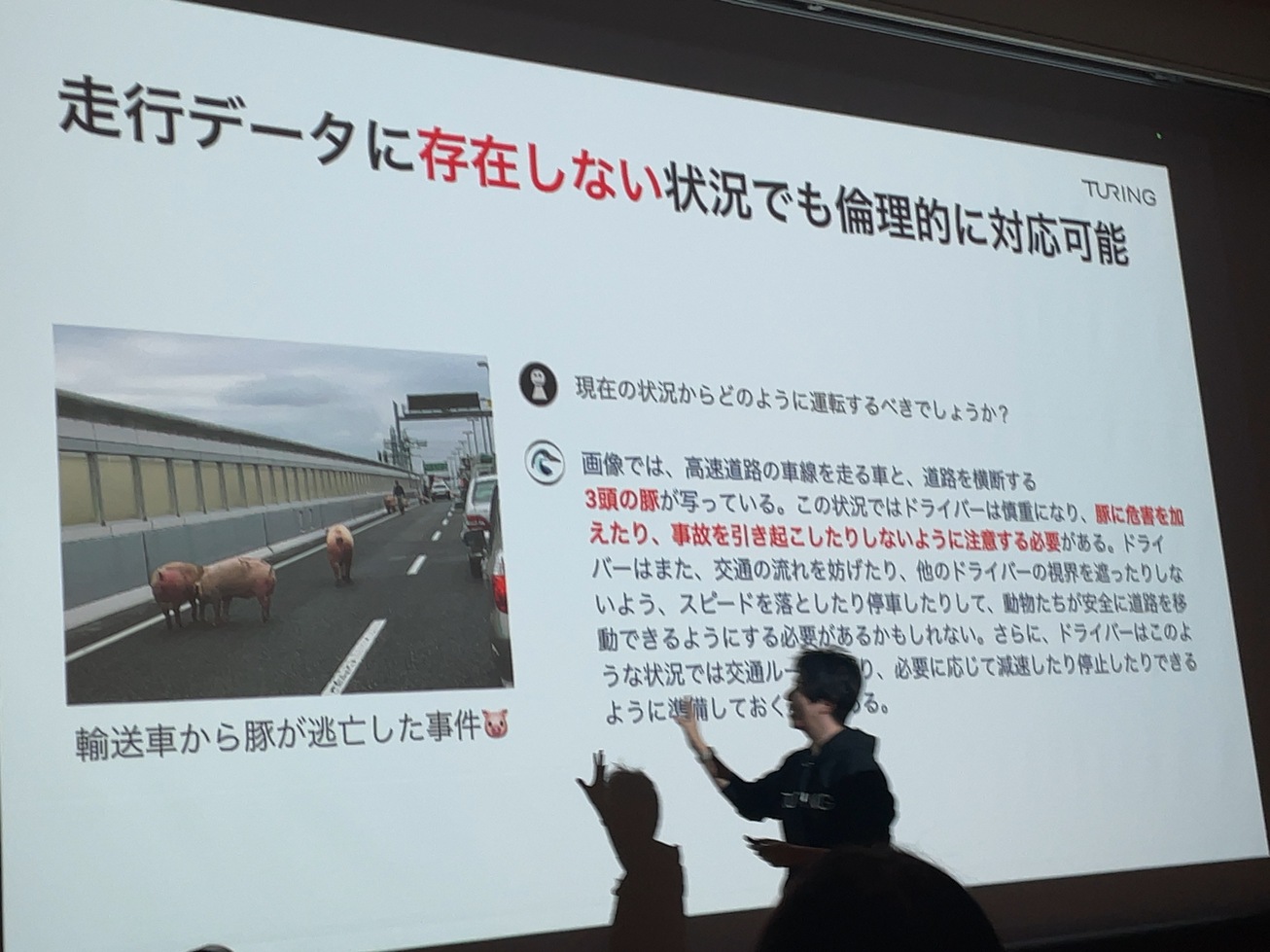

ルールベースではあり得ない状況に対応するのは難しい。Heronは予測できている。

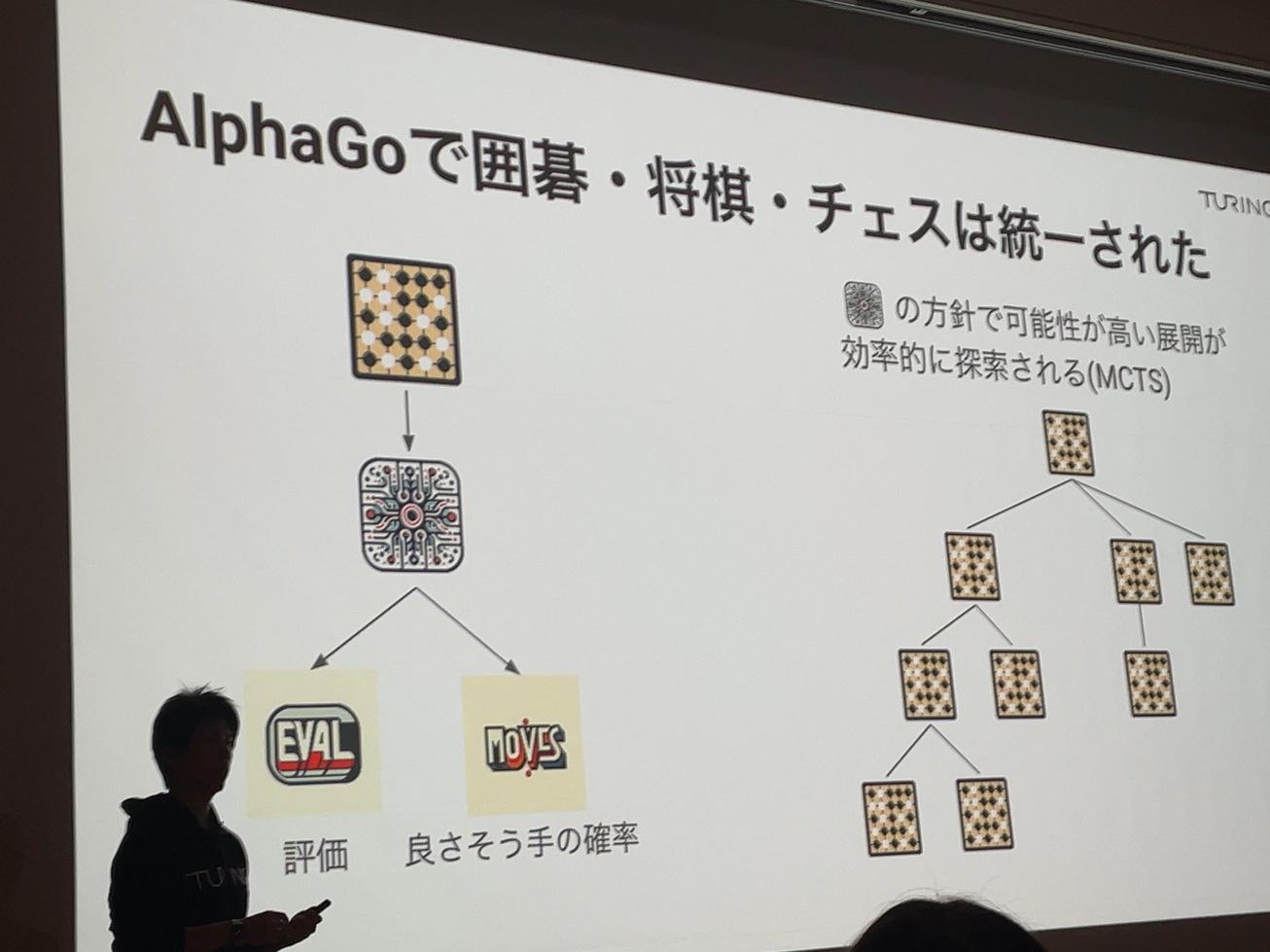

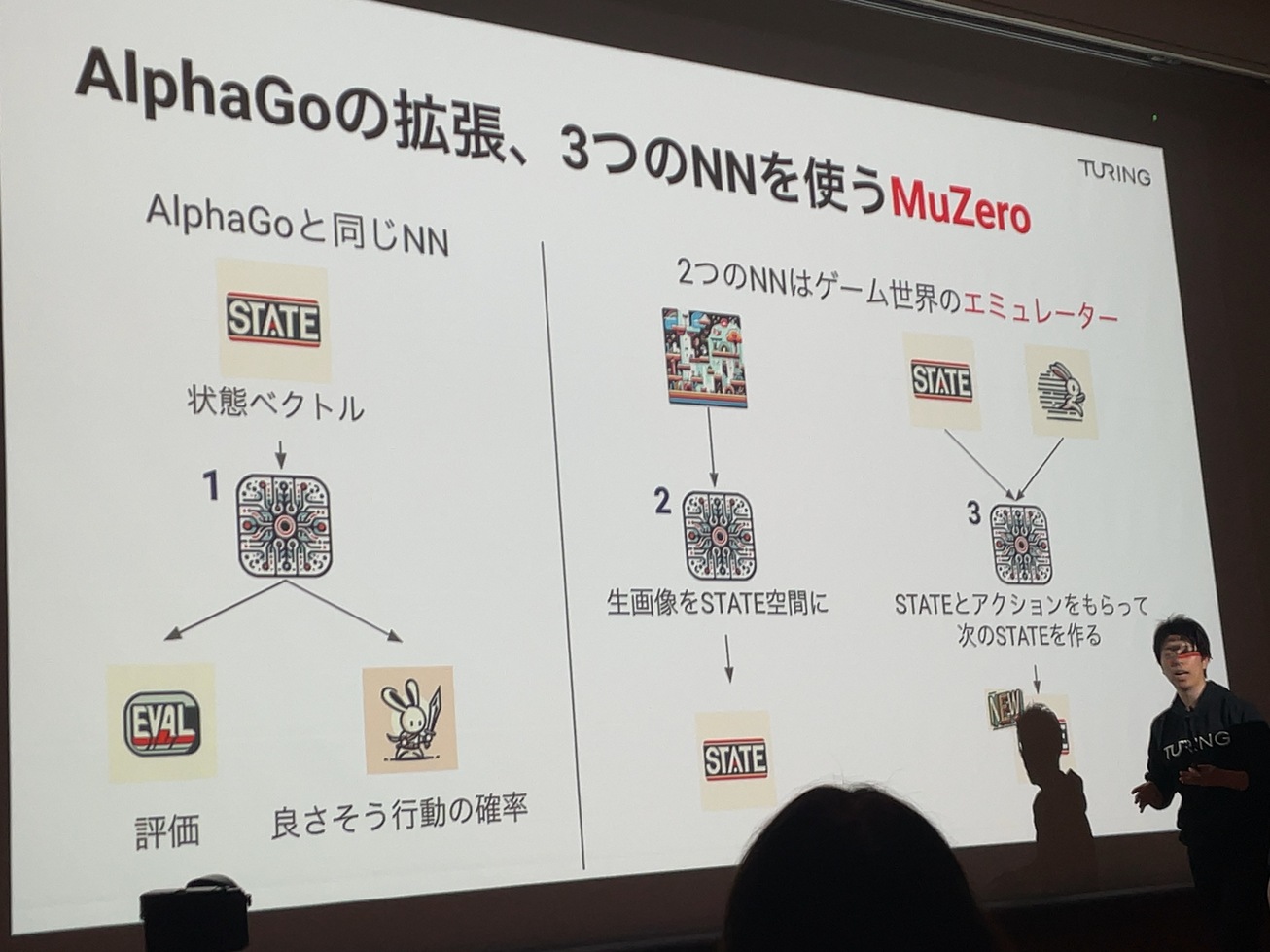

AIの歴史を少し。AlphaGoが何をしているか。画像から状態ベクトルというものを読み取る。

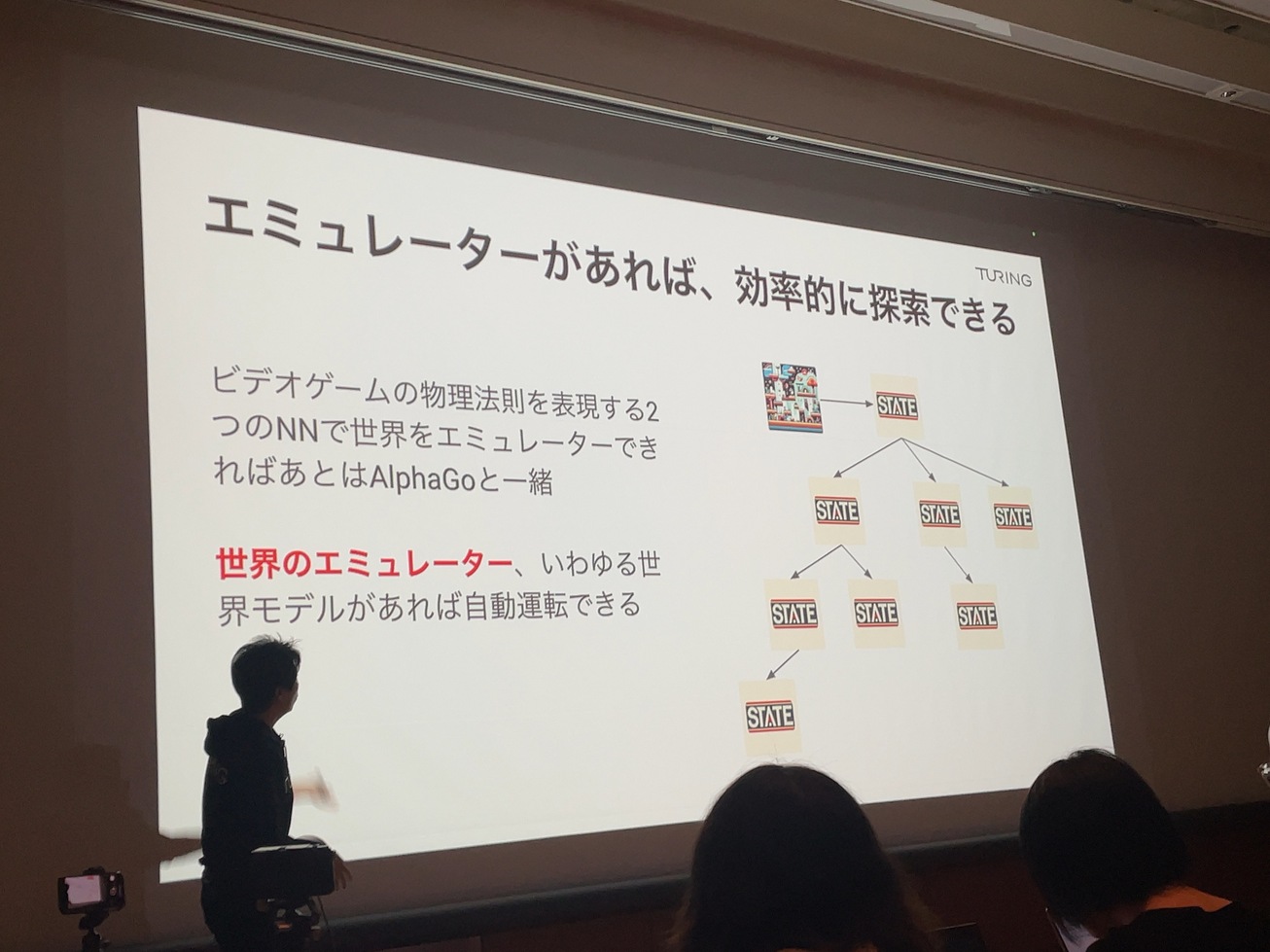

状態ベクトルをニューラルネット化する。ゲームの場合、エミュレーターとなる。

世界のエミュレーターを世界モデルという。世界モデルがあれば自動運転ができる。

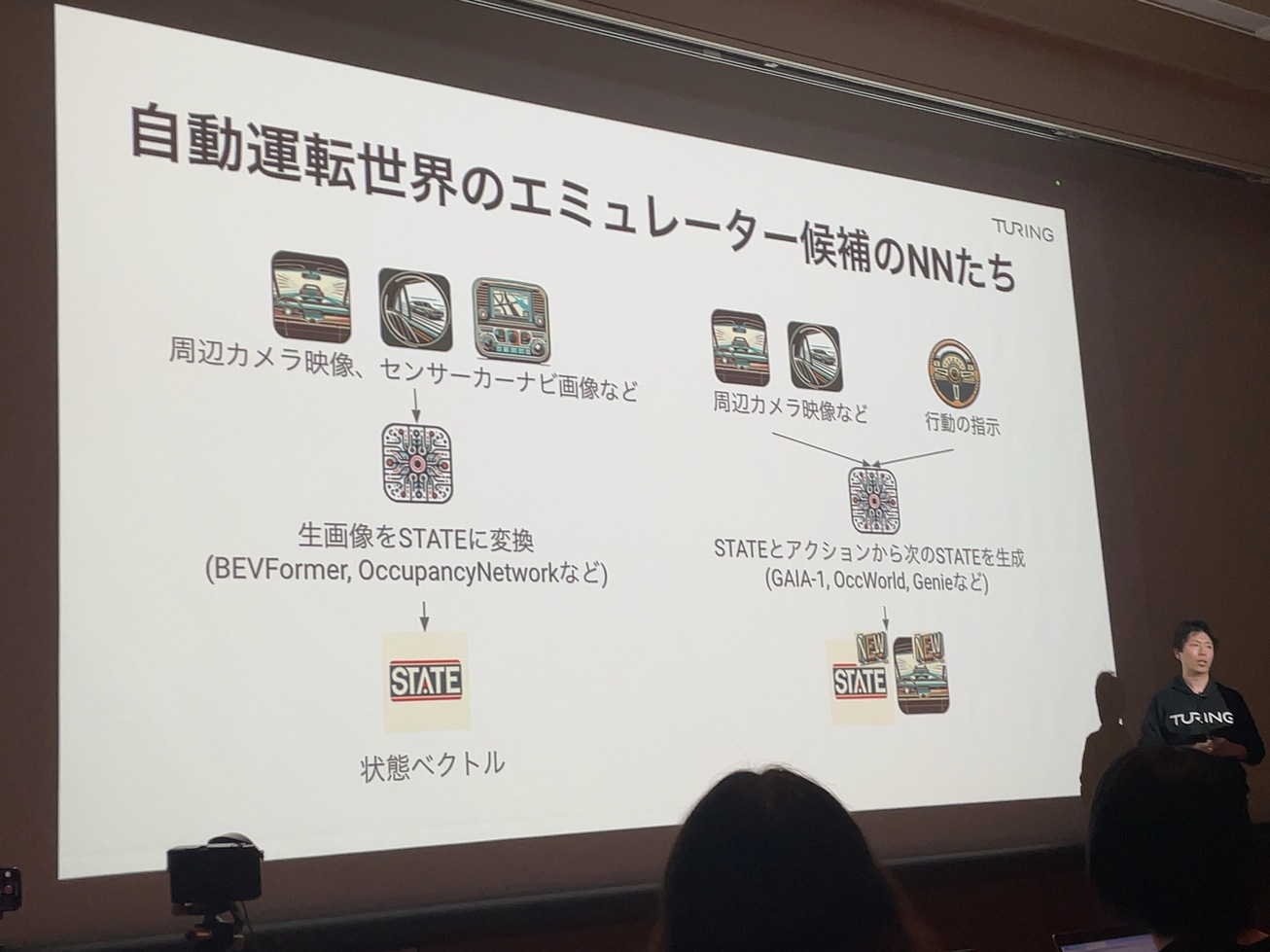

自動運転世界のエミュレーターはカメラやカーナビ画像から予測する。

世界モデルを理解するAIで自動運転が可能となる。

来ている方でAIとかやっている人は力を貸して欲しい

生成AIで目指す完全自動運転: 山口 祐さん

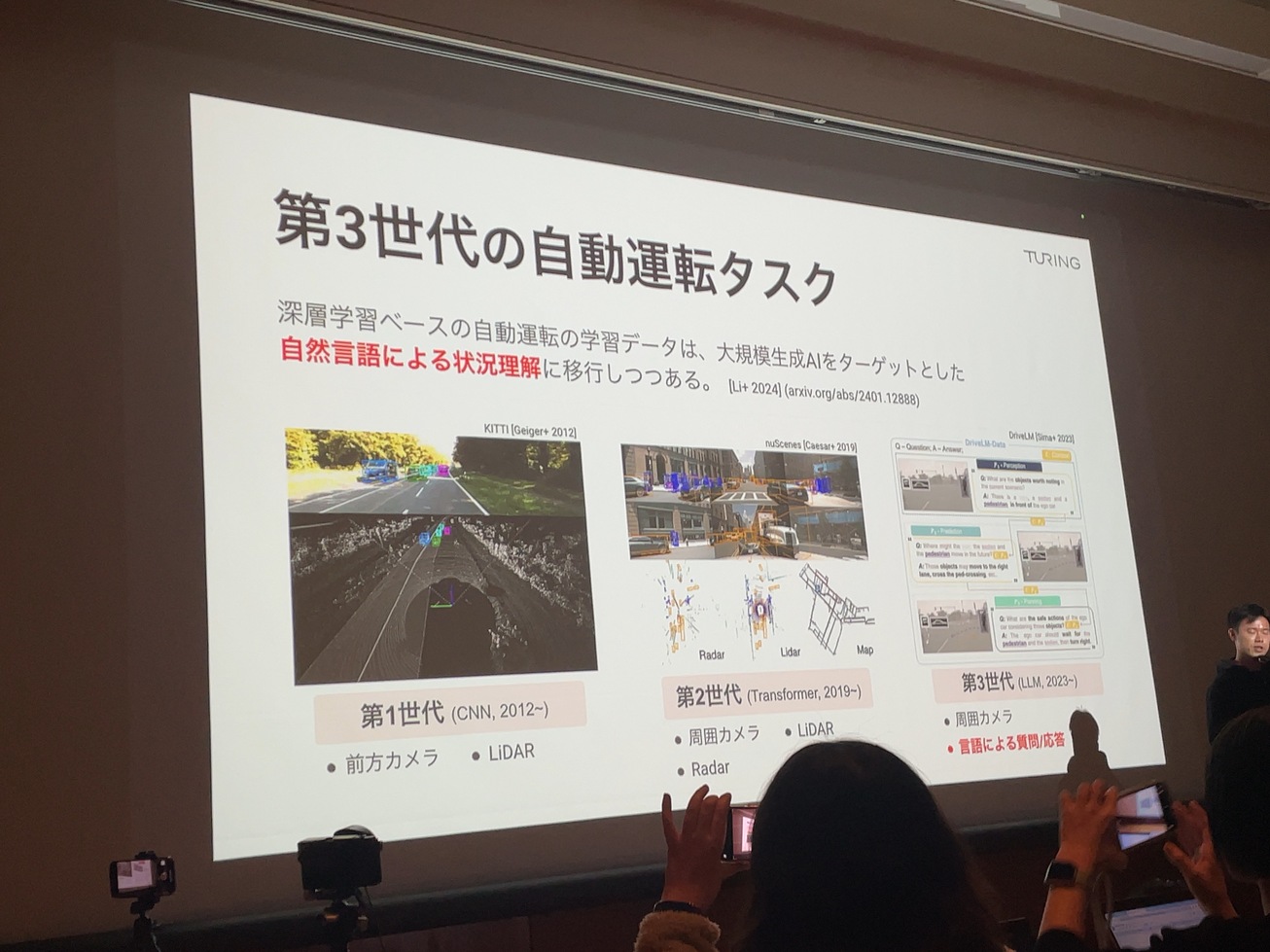

第3世代の自動運転タスク

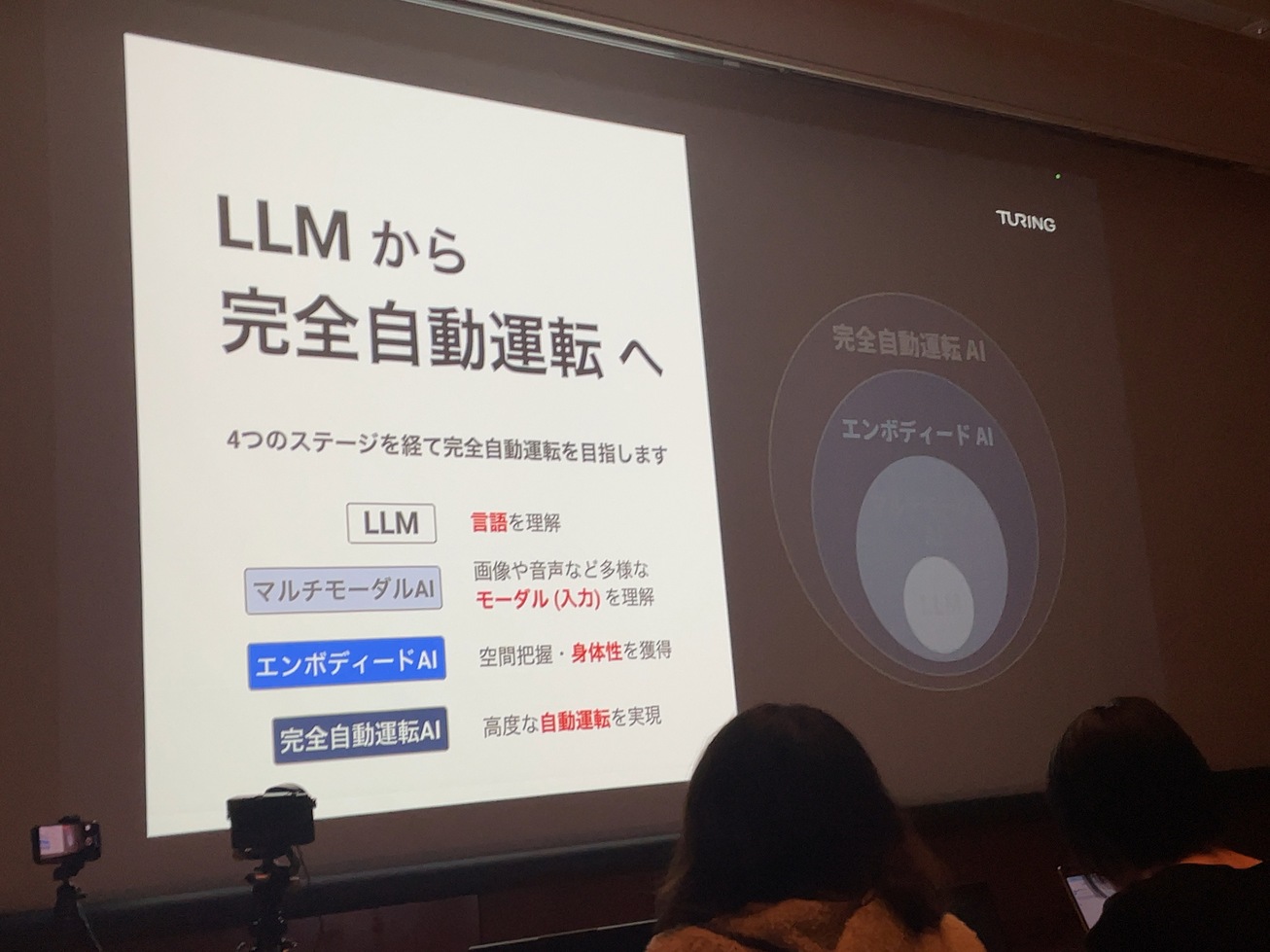

LLMから完全自動運転へ

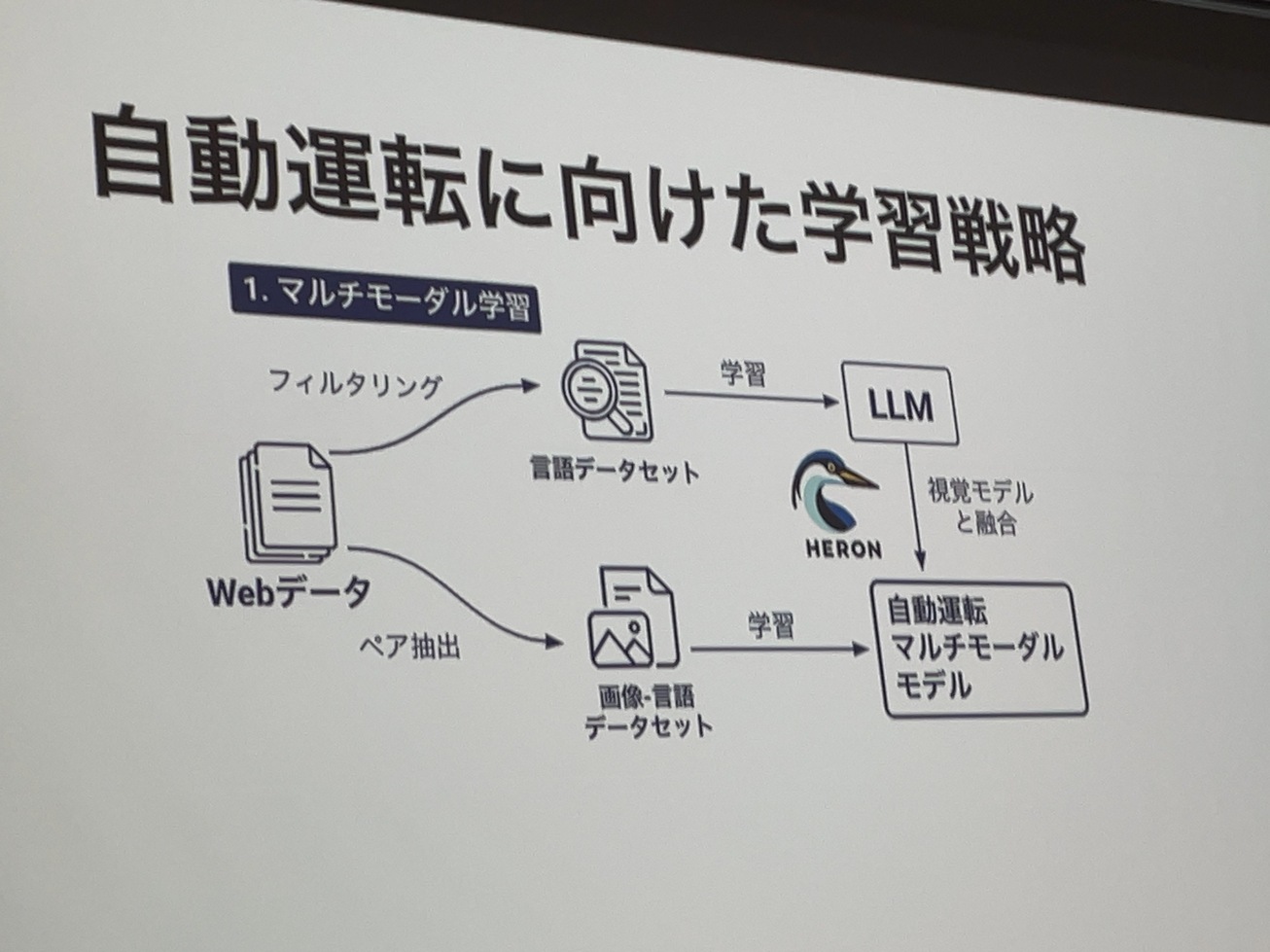

自動運転に向けた学習戦略

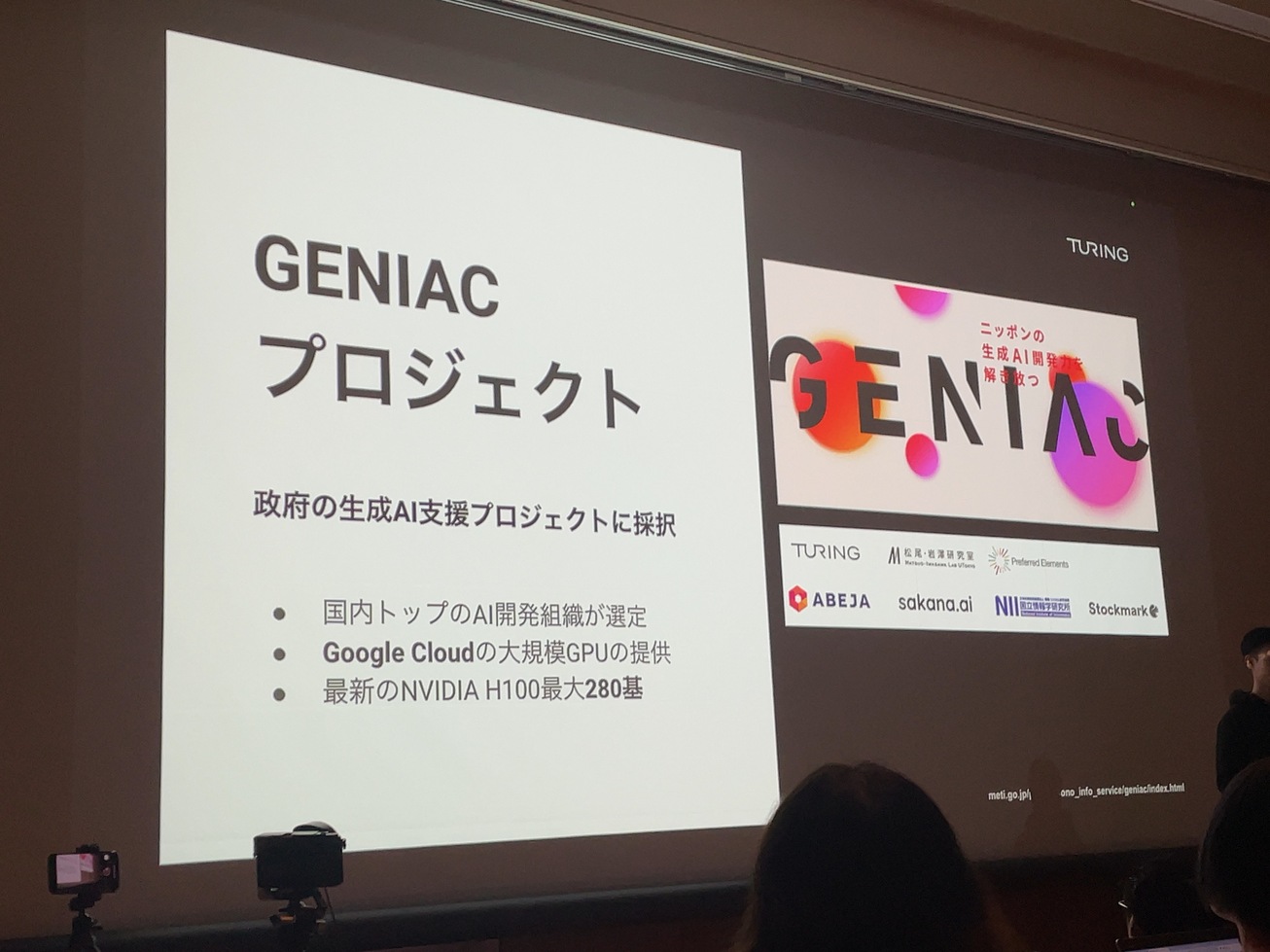

政府のGENIACプロジェクトでGoogle CloudのH100×280を調達。

別に独自Gaggle ClusterでH100×96を調達

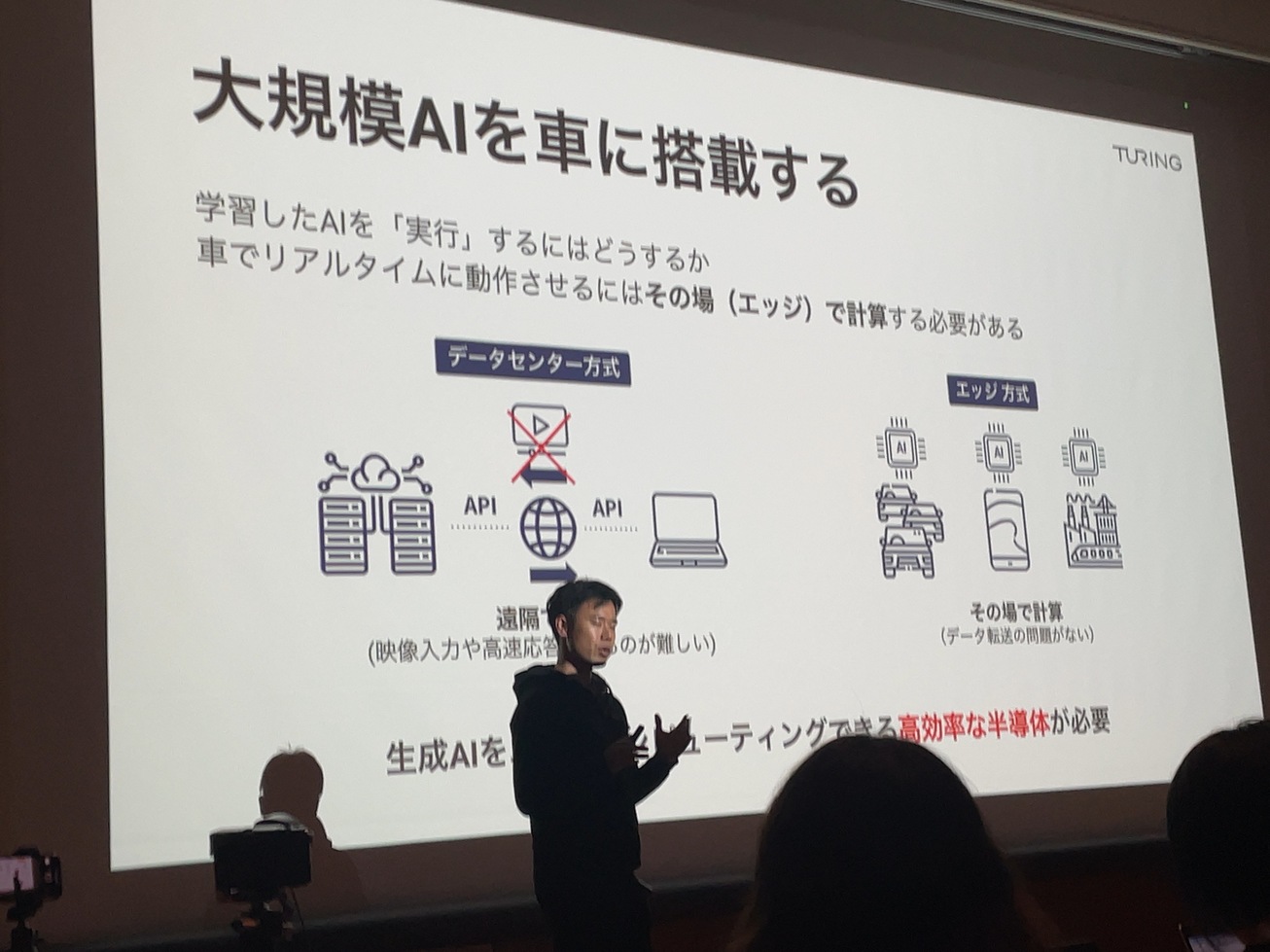

大規模AIを車に搭載する

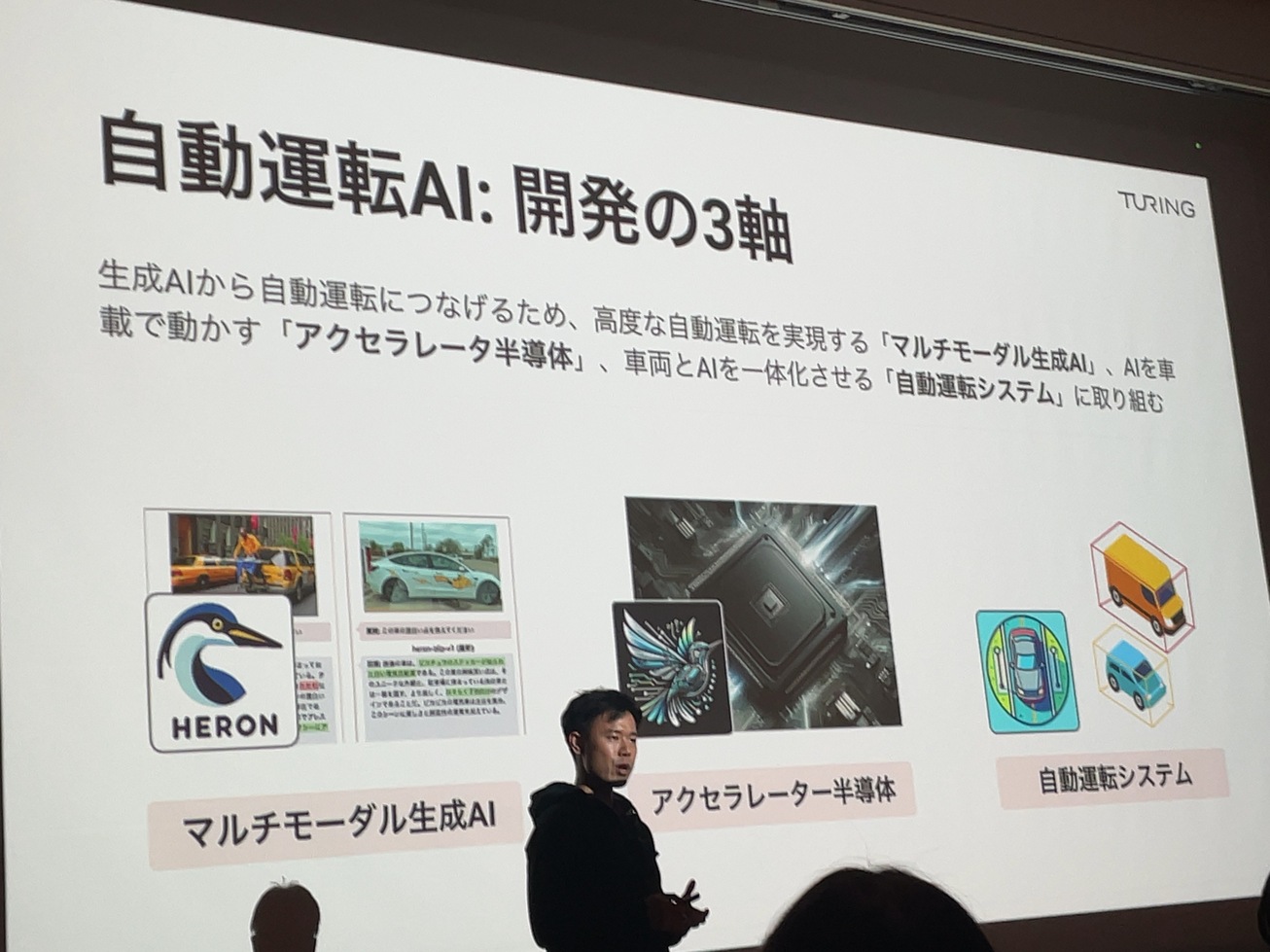

自動運転AI: 開発の3軸

完全自動運転の「知能」を実現するマルチモーダル生成AIの開発: 井ノ上 雄一さん

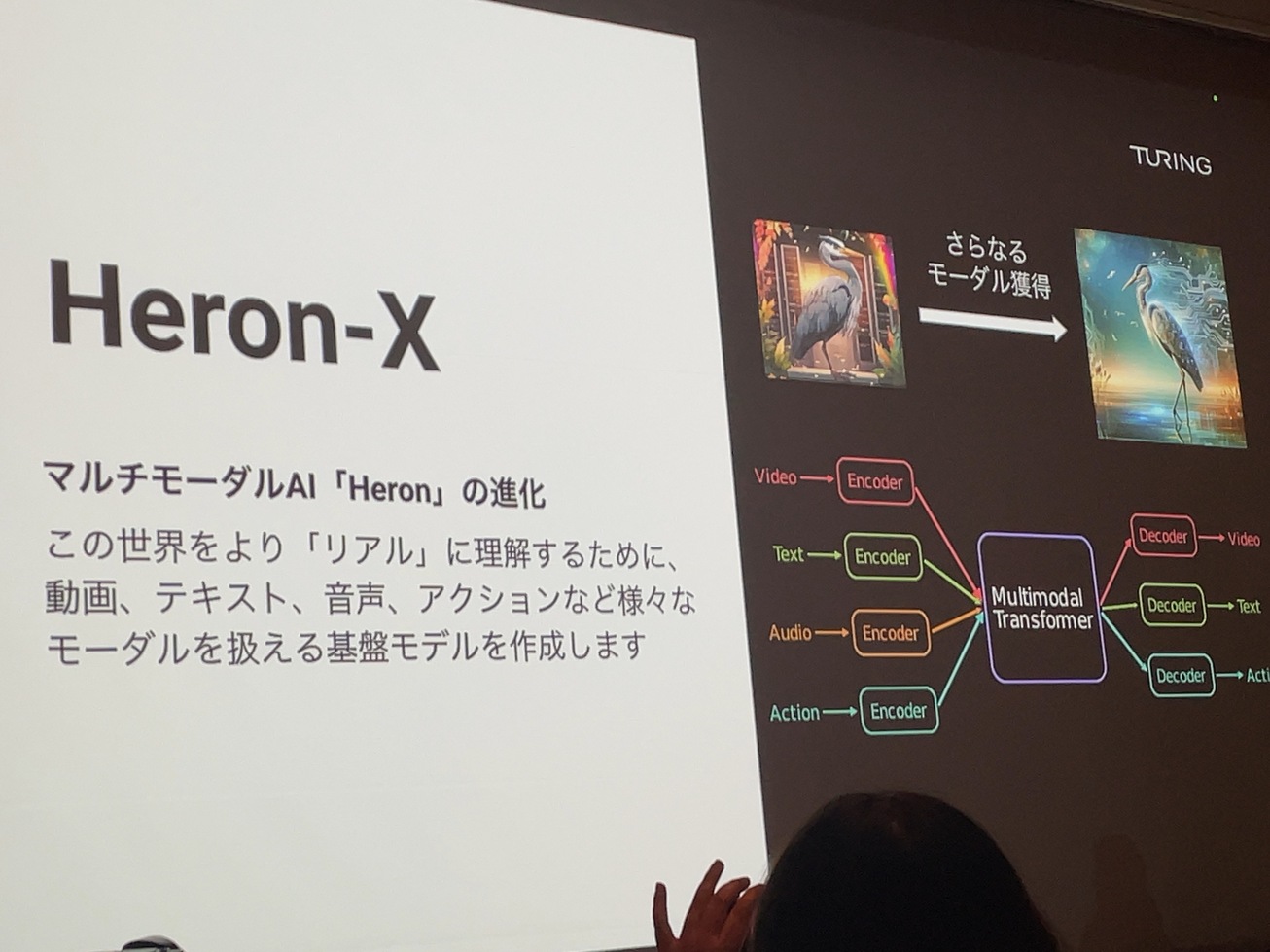

Heron-X。画像だけでなく、動画、テキスト、音声、アクションなどのモーダルを扱えるようにする。

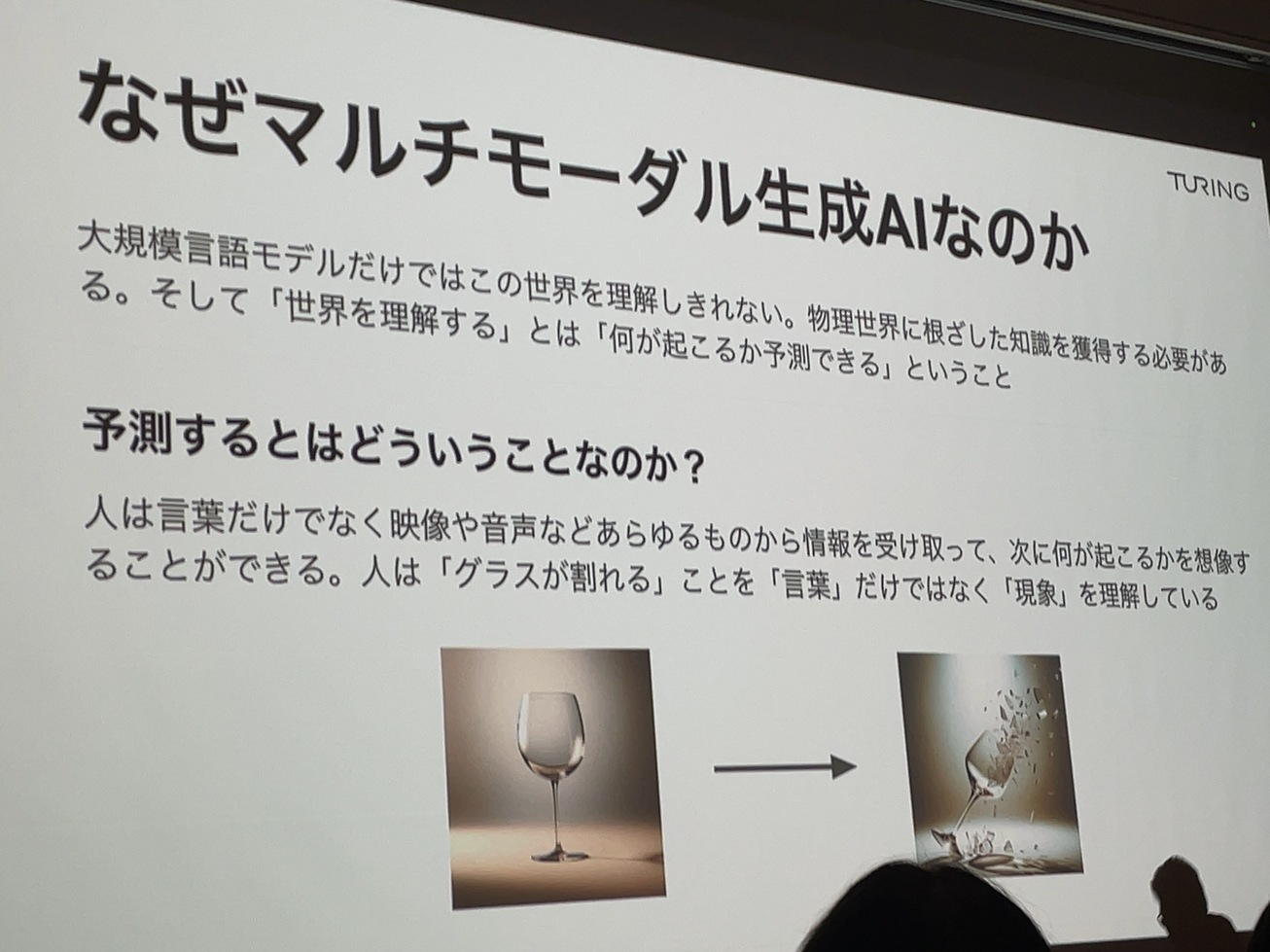

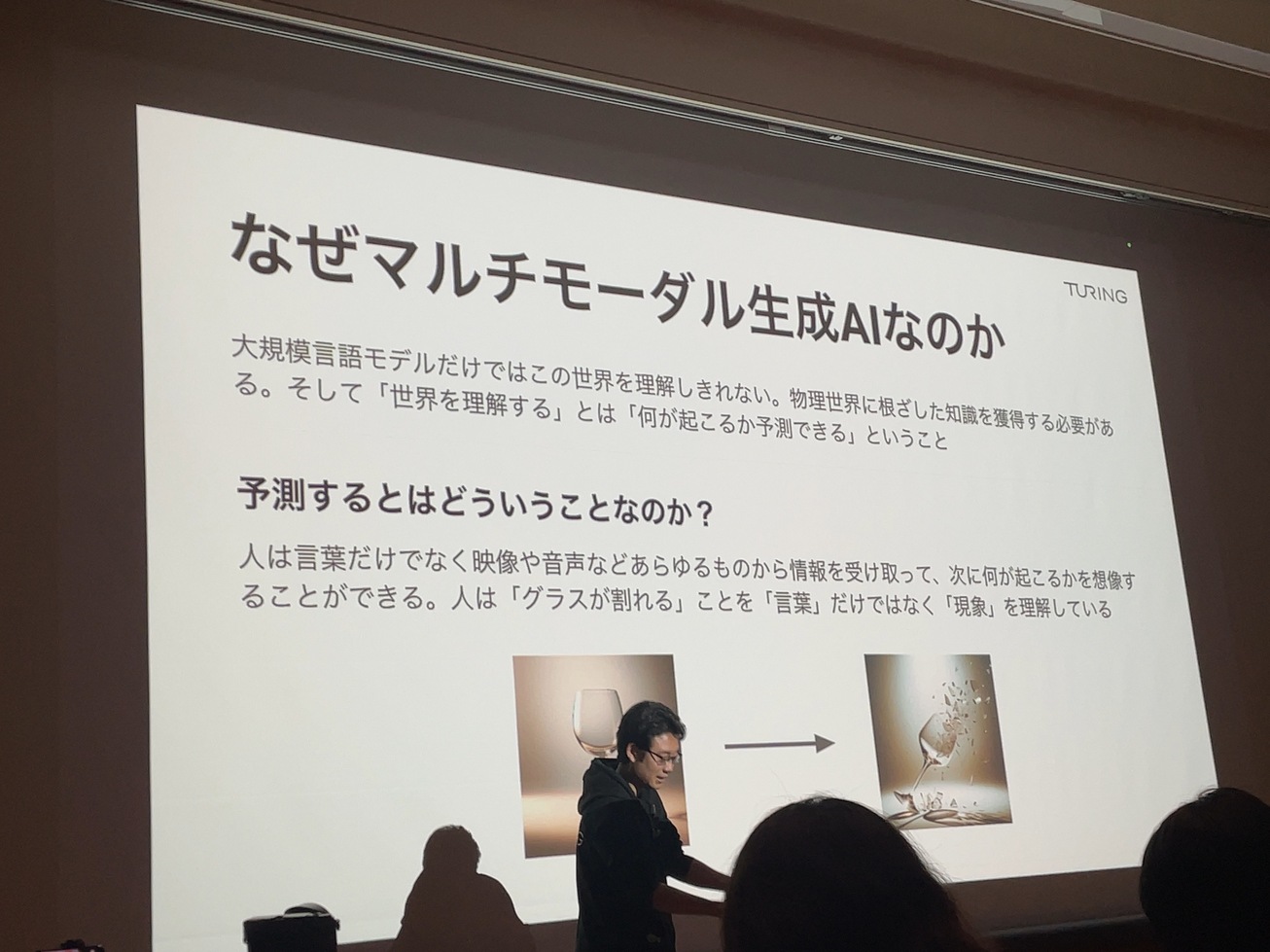

なぜマルチモーダル生成AIなのか

予測するとはどういうことかグラスの例で説明。

生成AIのコア技術Transformerの可能性

Transformerでできること。

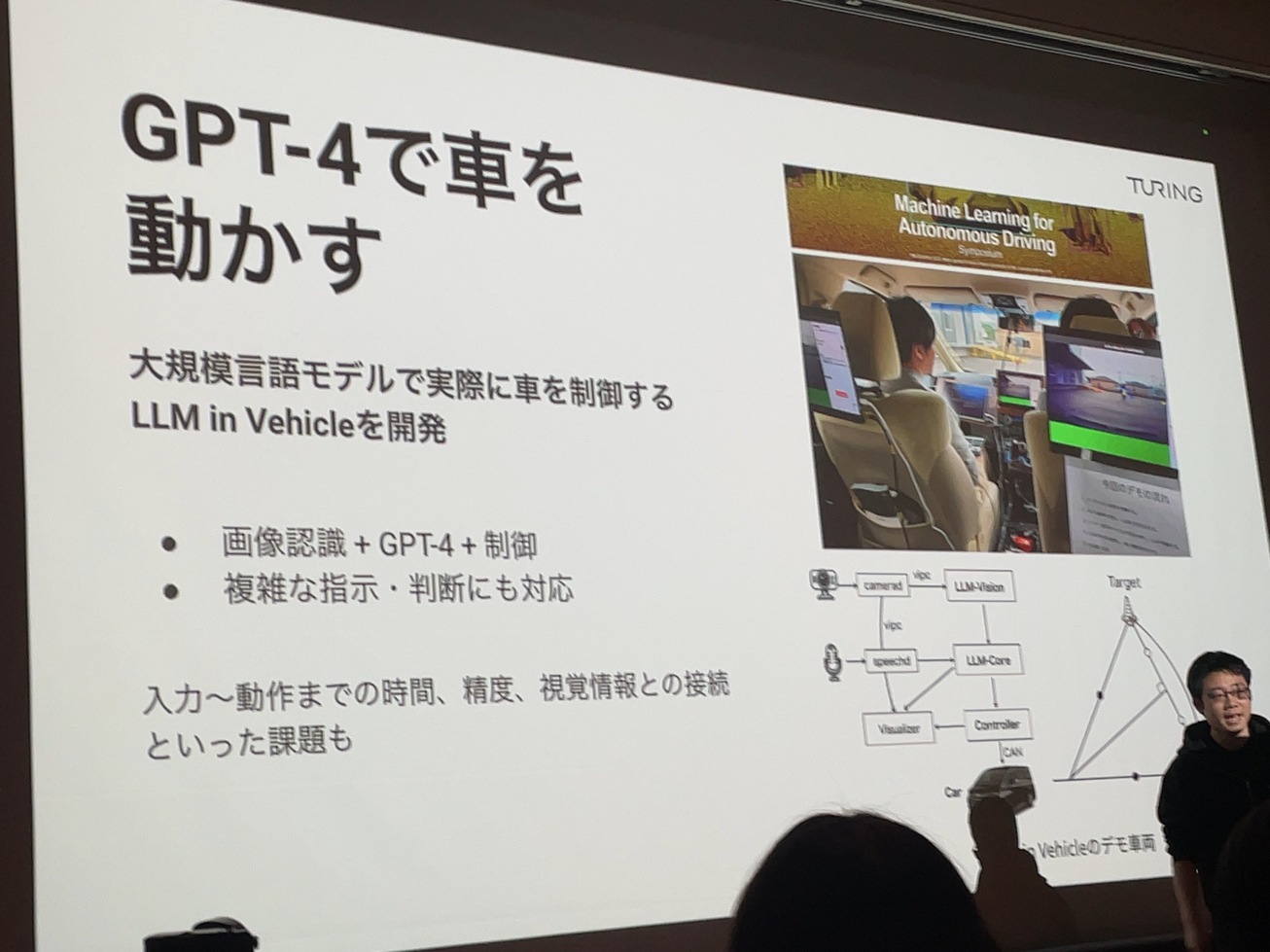

GPT-4で車を動かすことができた。素晴らしいことだが応答時間、精度など課題がある。

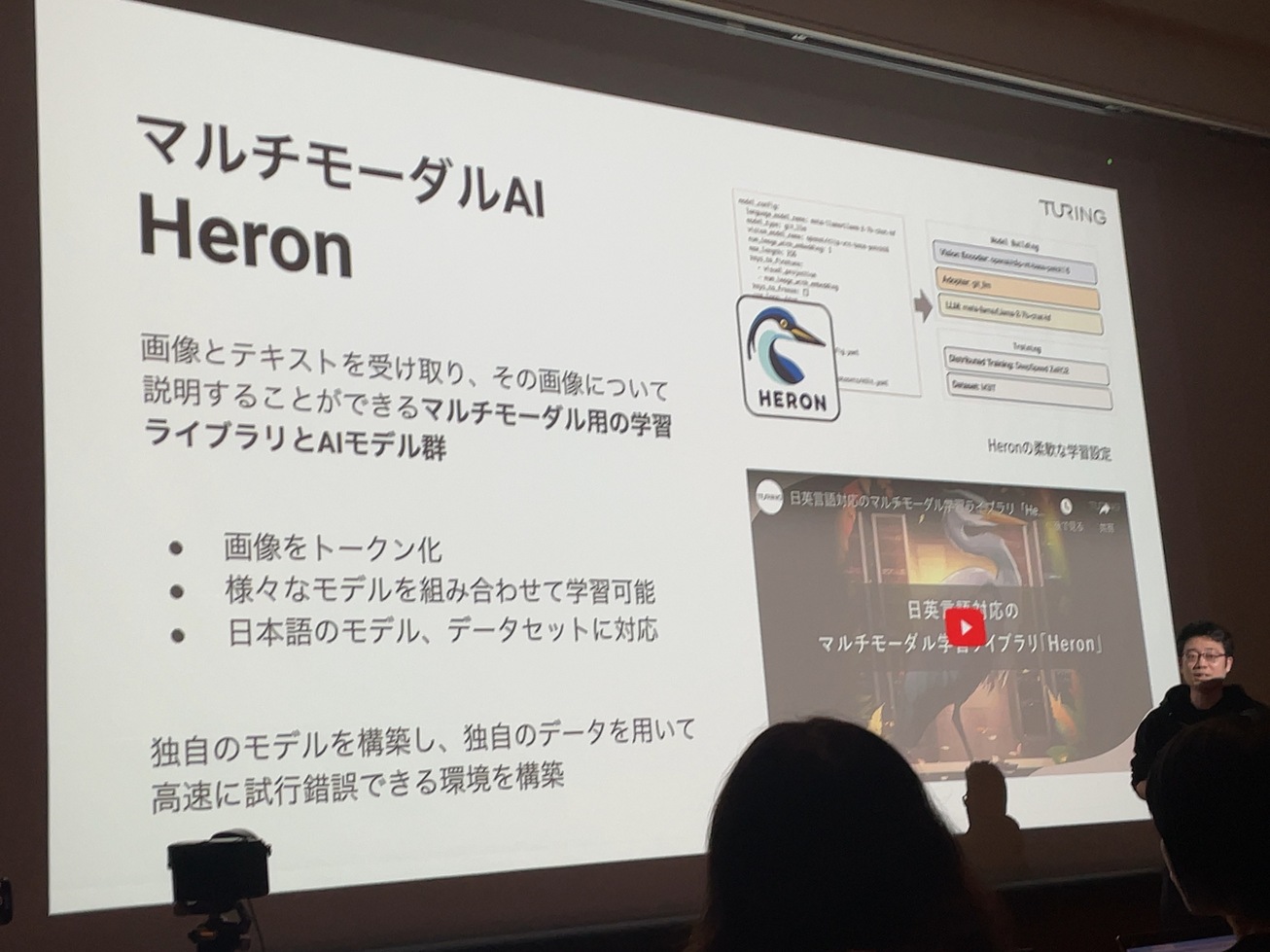

マルチモーダルAI Heron

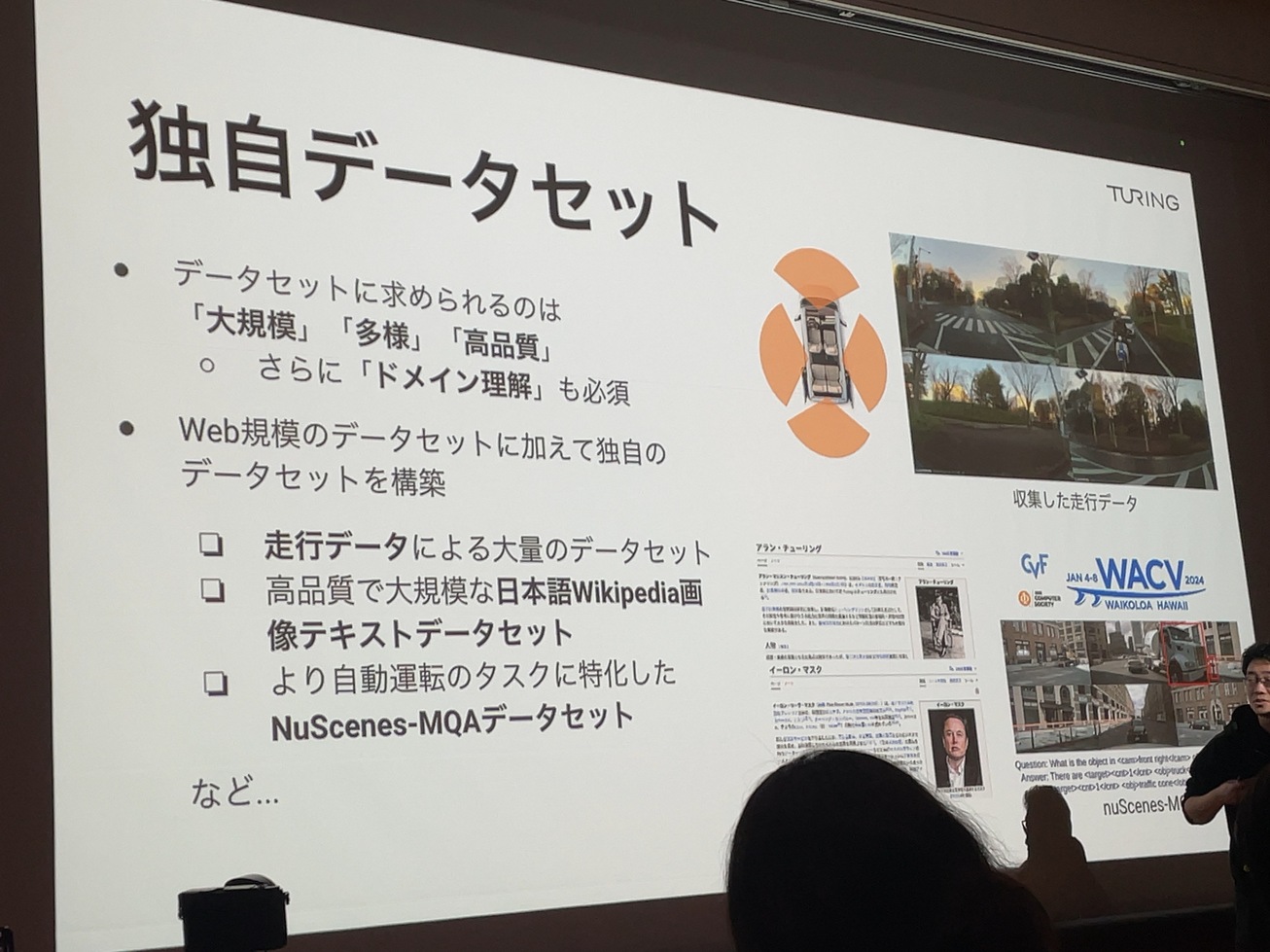

独自データセット

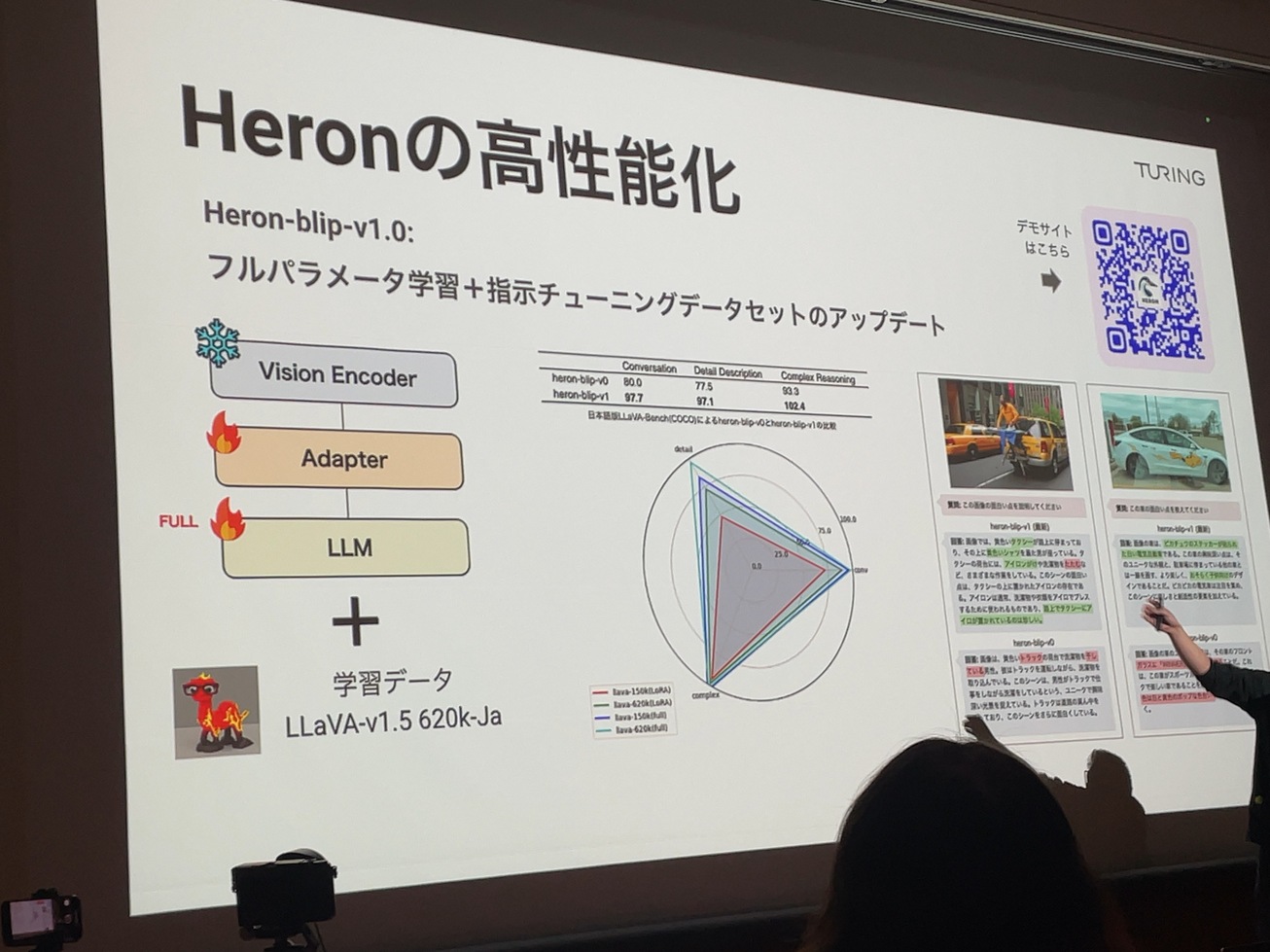

Heronの高性能化

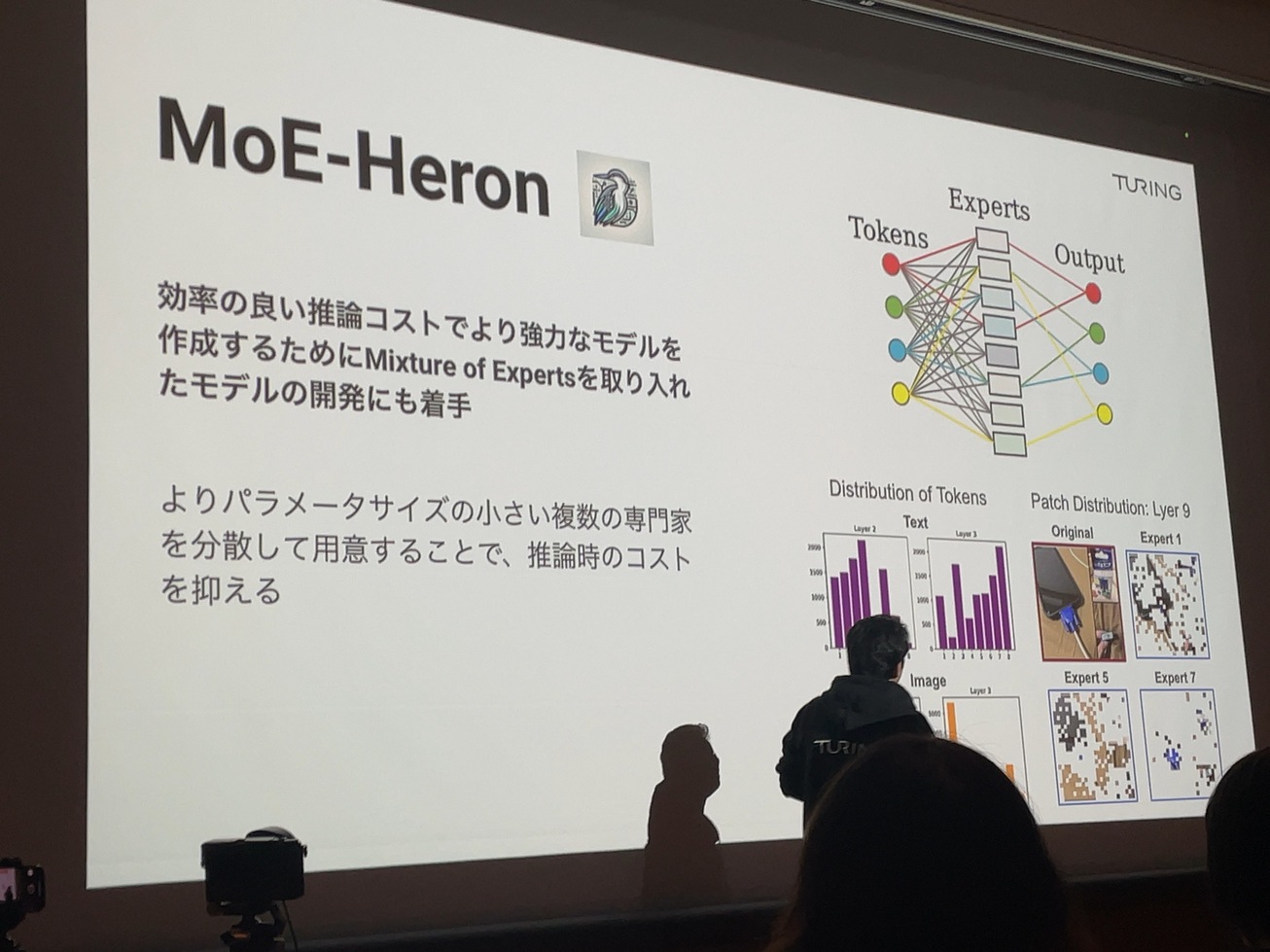

MoE-Heron

Mixture of Experts:パラメータサイズの小さい複数の専門家を配置することで推論コストを抑える。

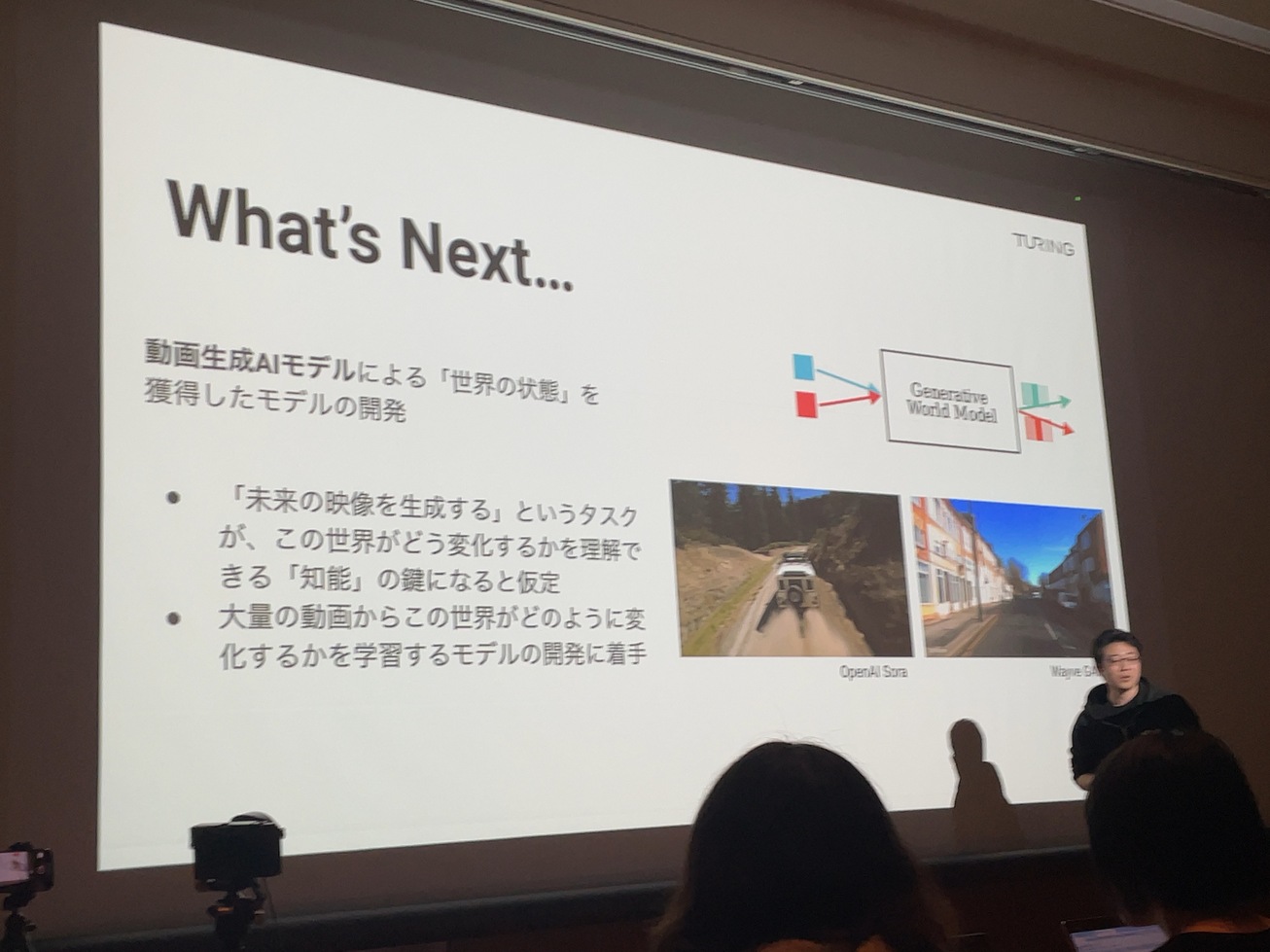

What’s Next…

動画生成AIモデルもやります。

生成AIをエッジで実現するアクセラレーター開発: 柏屋 元史さん

Hummingbird : 生成AI用アクセラレーター半導体

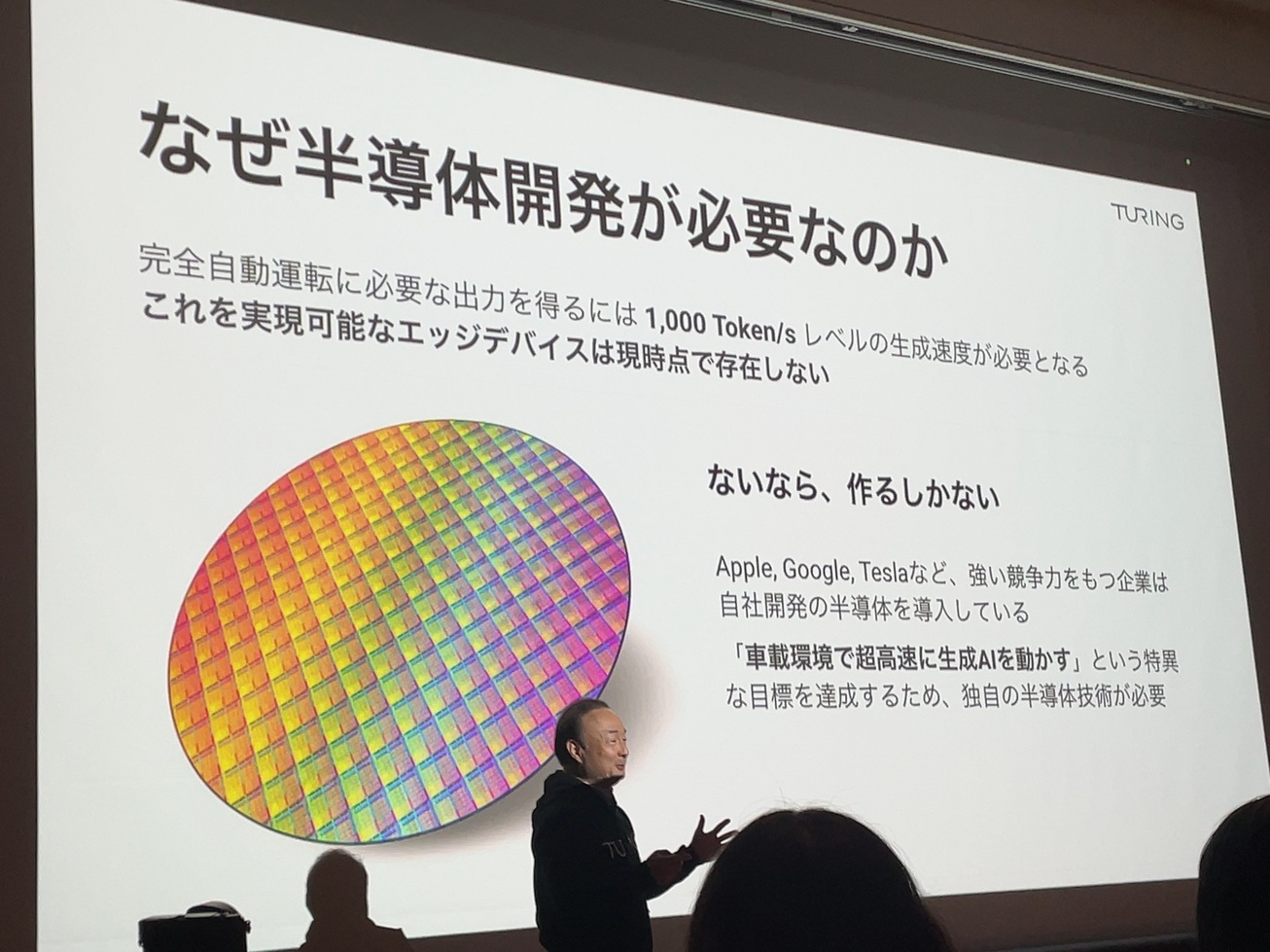

なぜ半導体が必要なのか。完全自動運転を実現可能なエッジデバイスは存在しないので、ないなら作る。

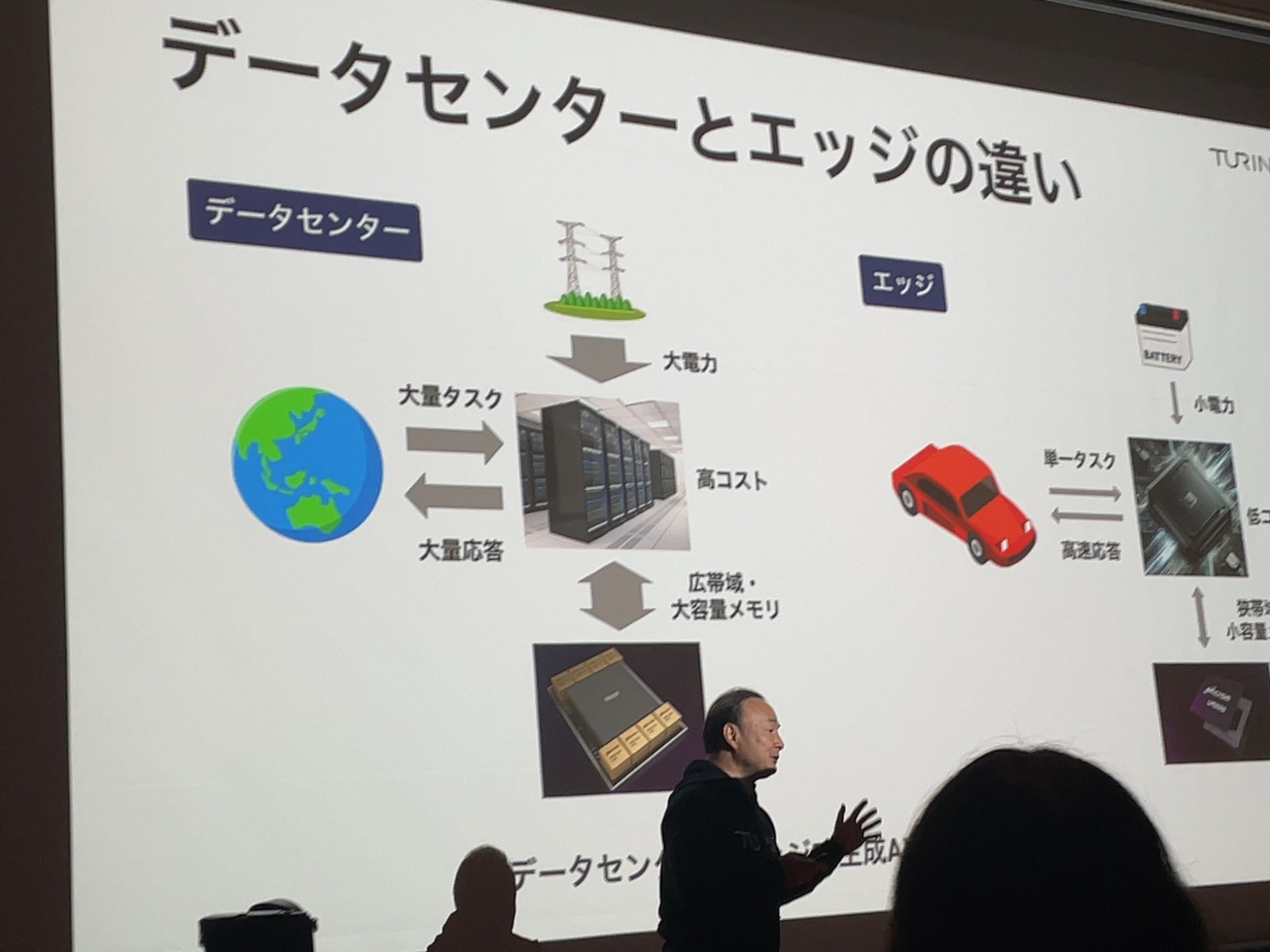

データセンターとエッジの違い。電源、格納場所に制限がある。

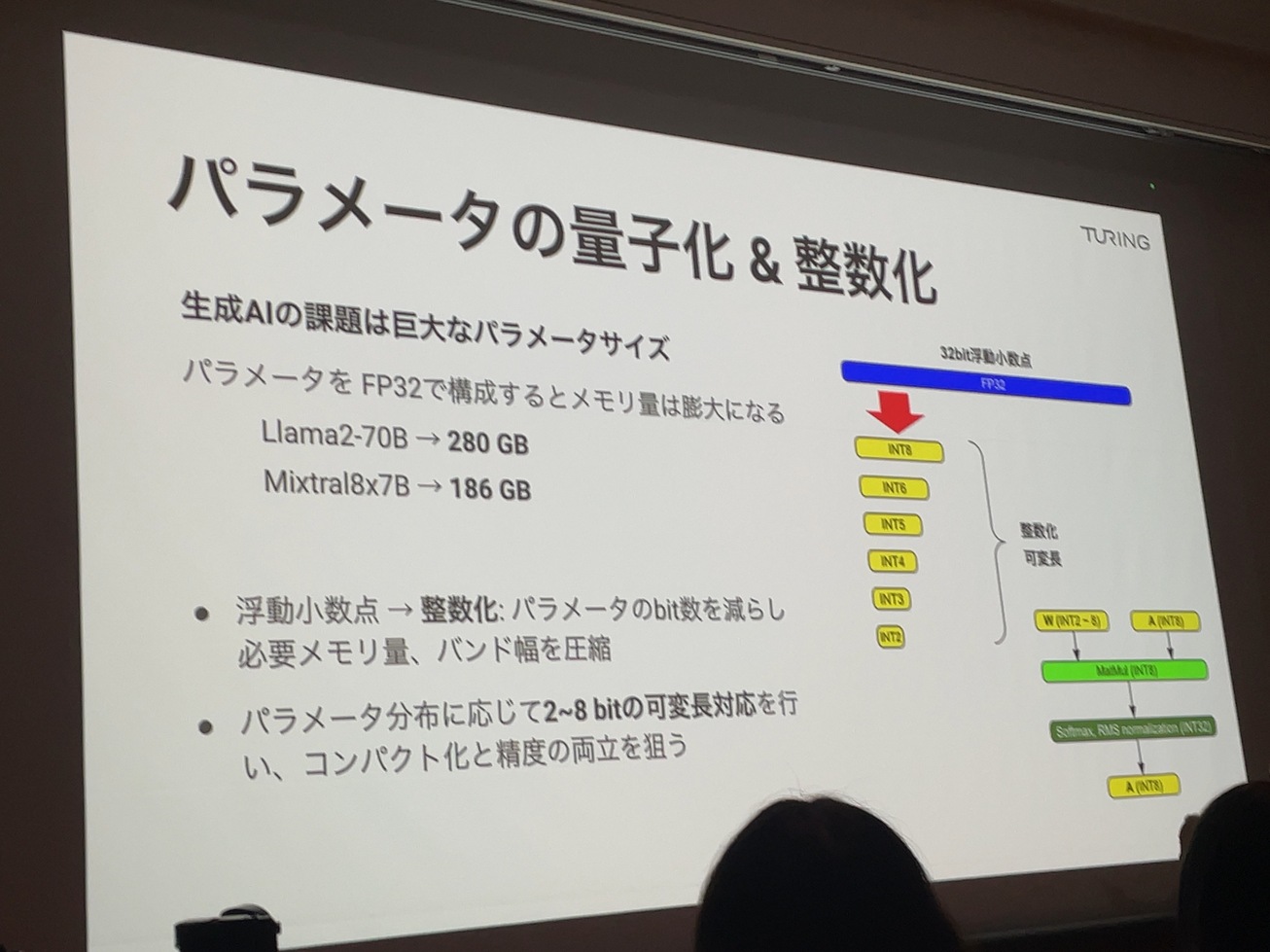

パラメータの量子化&整数化

浮動小数点ではなく整数

量子化は 2〜8 bitの可変長で対応

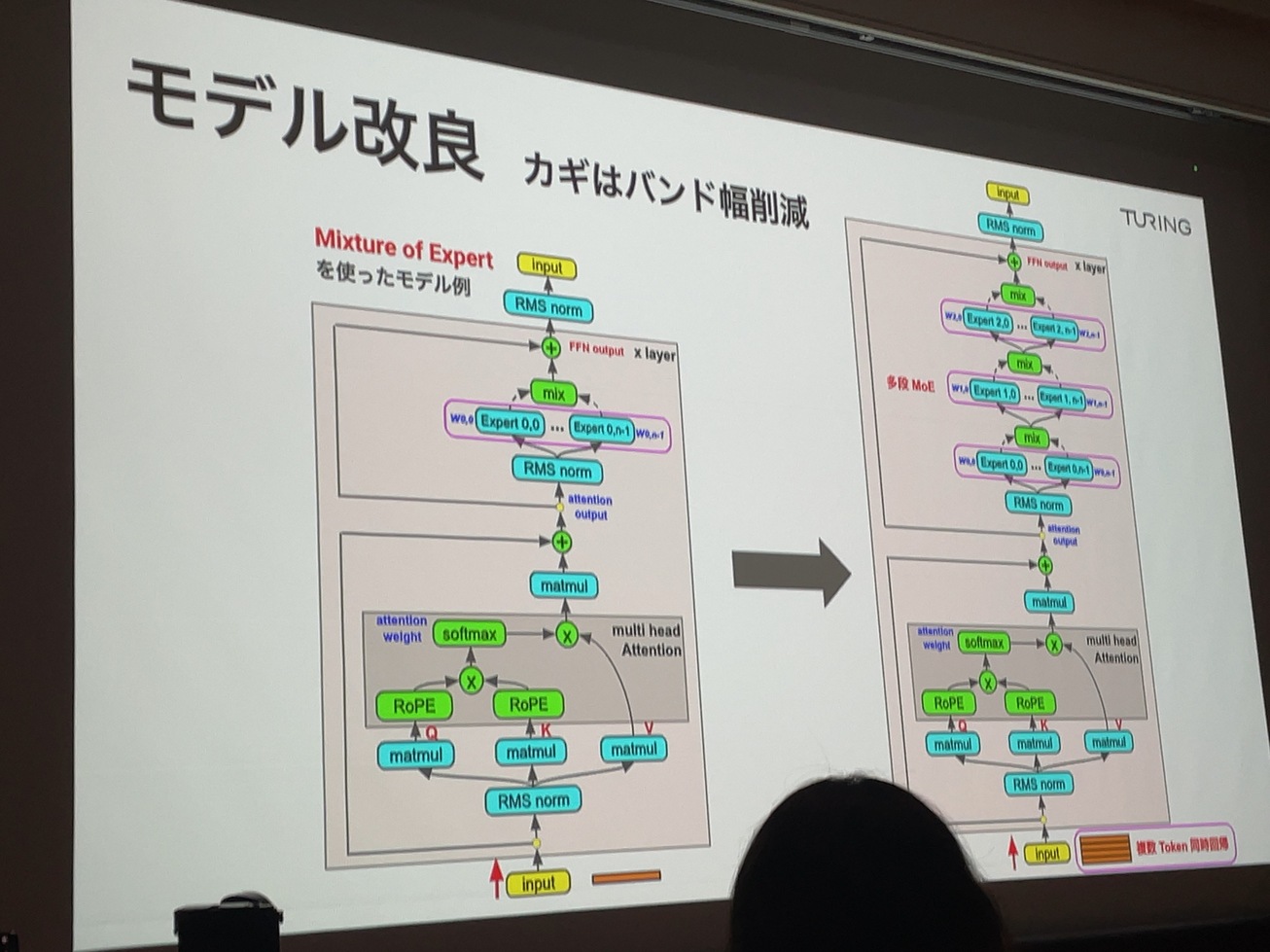

モデル改良

バンド幅を削減するためにMoEを使ってモデル化する。更に多段化する。

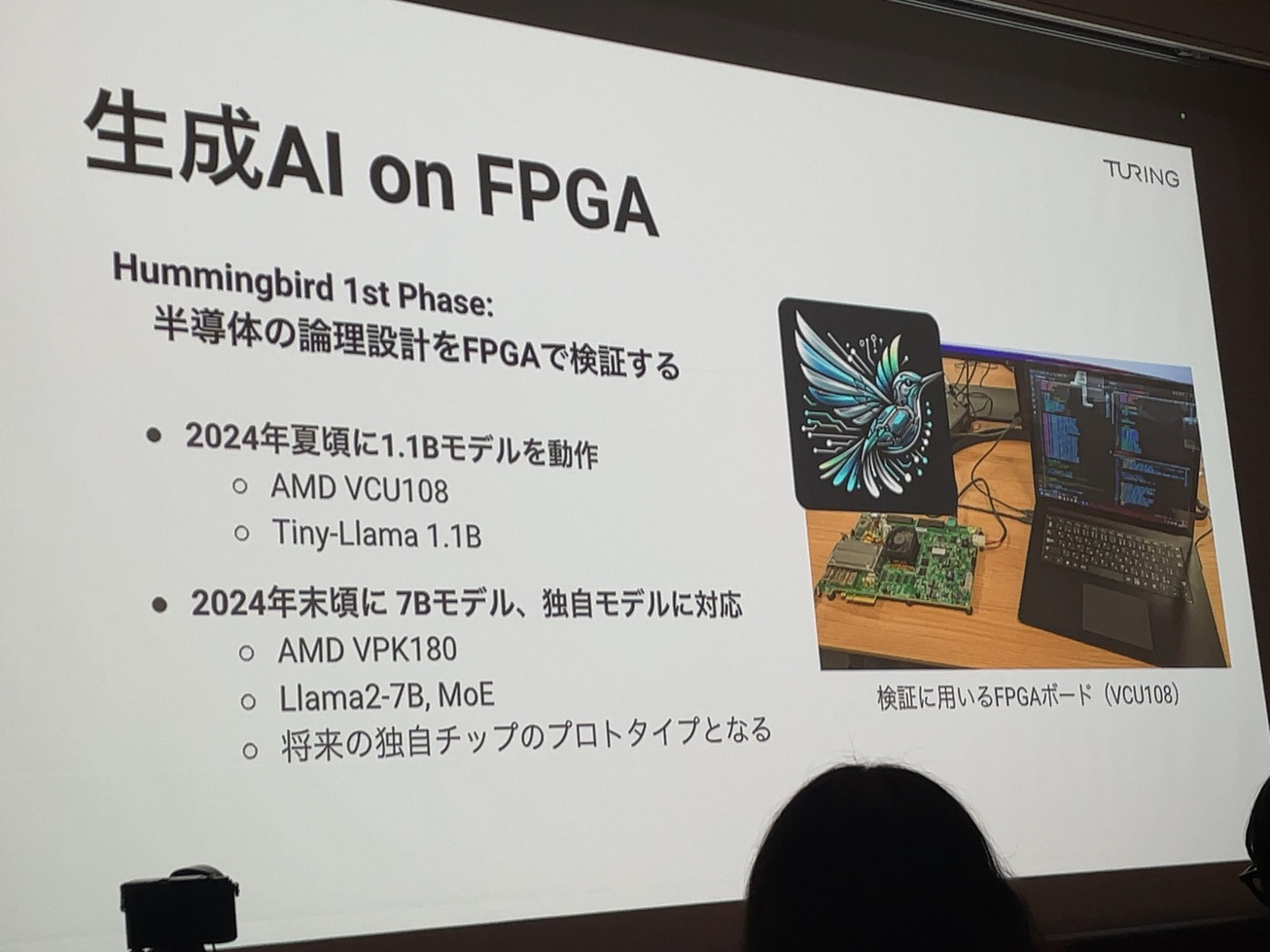

生成AI on FPGA

まずはFPGAで検証する。

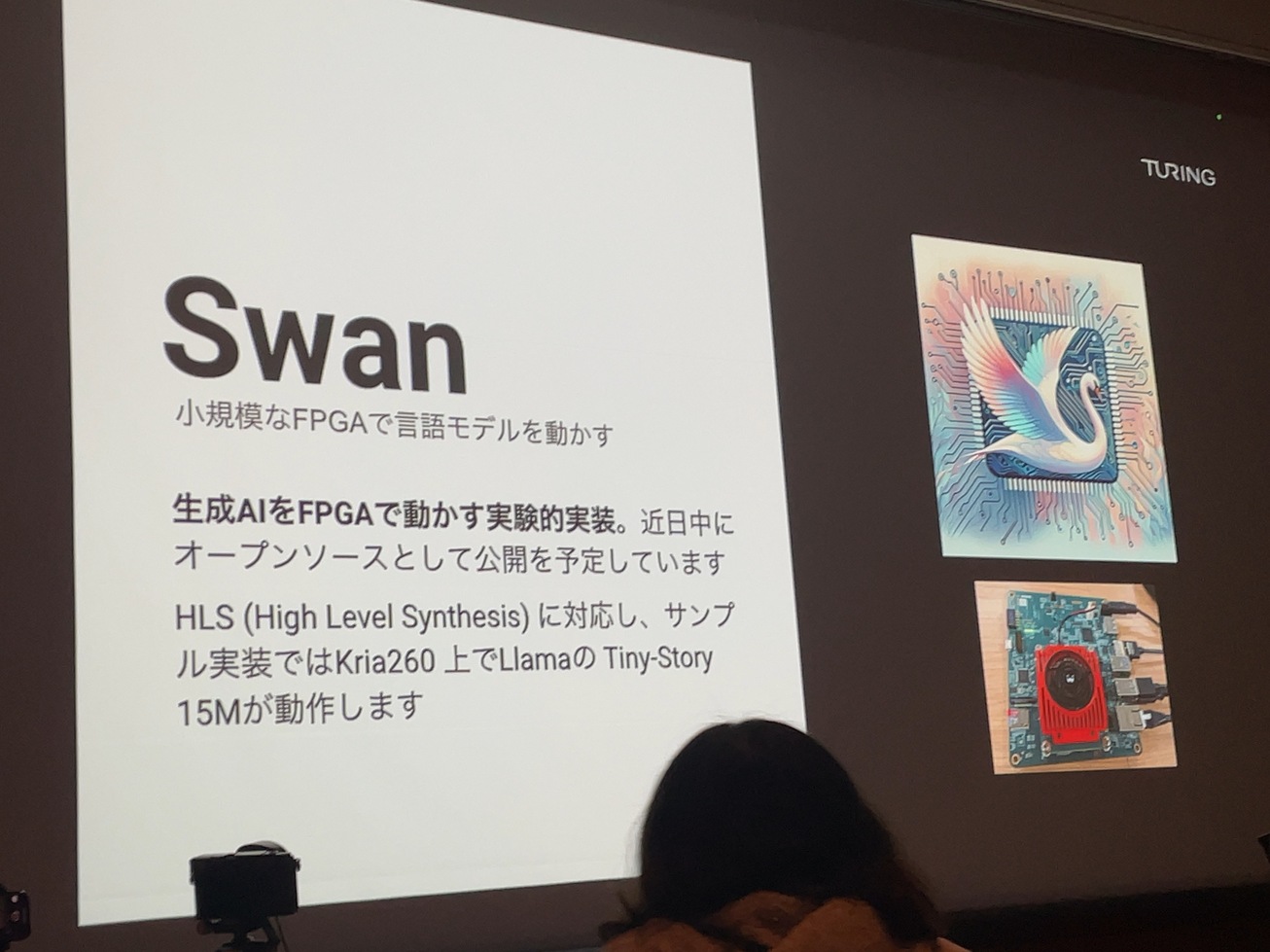

Swan: 生成AIをFPGAで動かす実験的実装。オープンソースとして公開する予定。

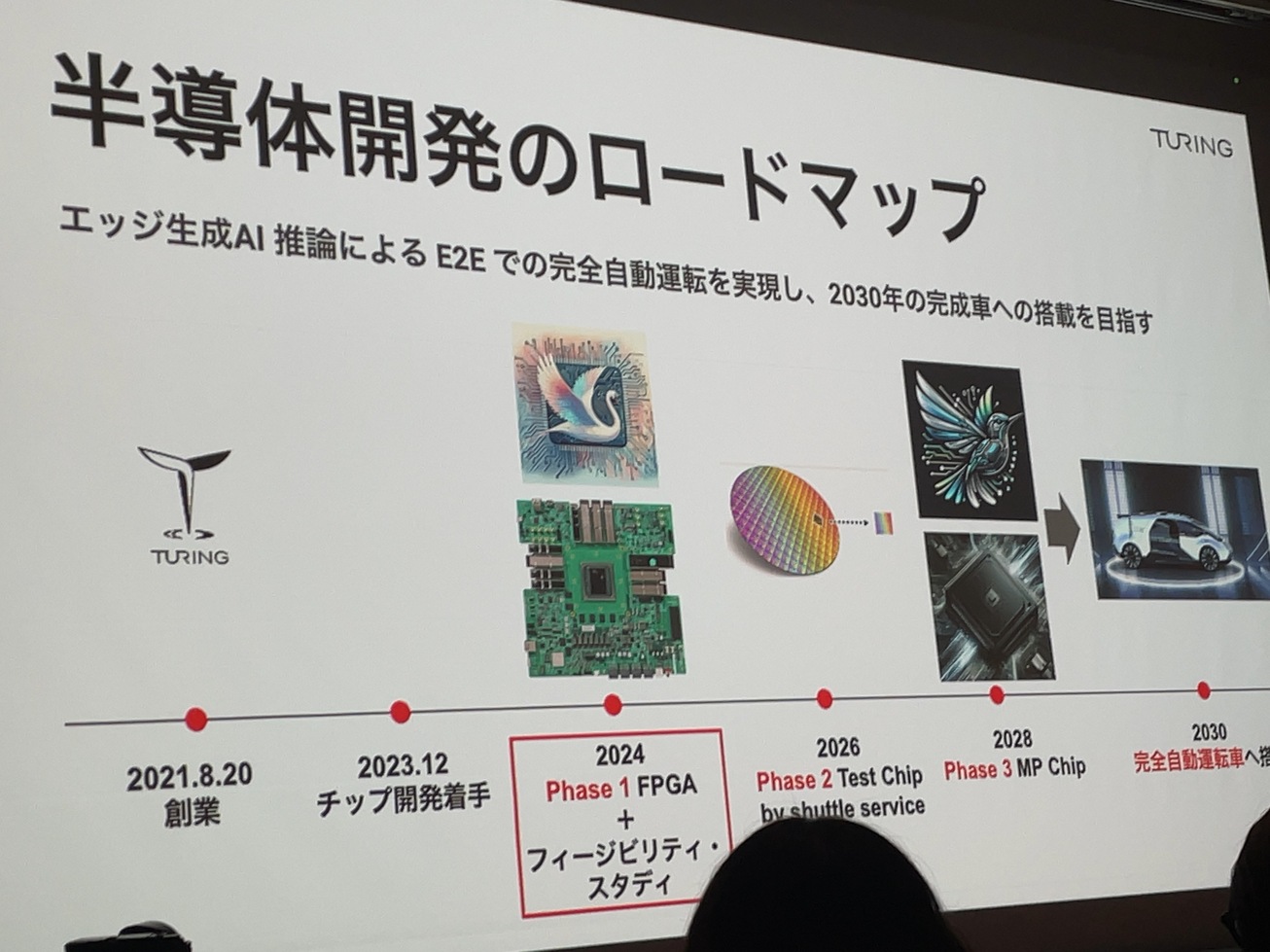

半導体開発のロードマップ

2024 Phase 1 FPGA

2026 Phase 2 Test Chip

2028 Phase 3 MP Chip

2030 完全自動運転車への搭載

End-to-Endな自動運転AIの実現 : 棚橋 耕太郎さん

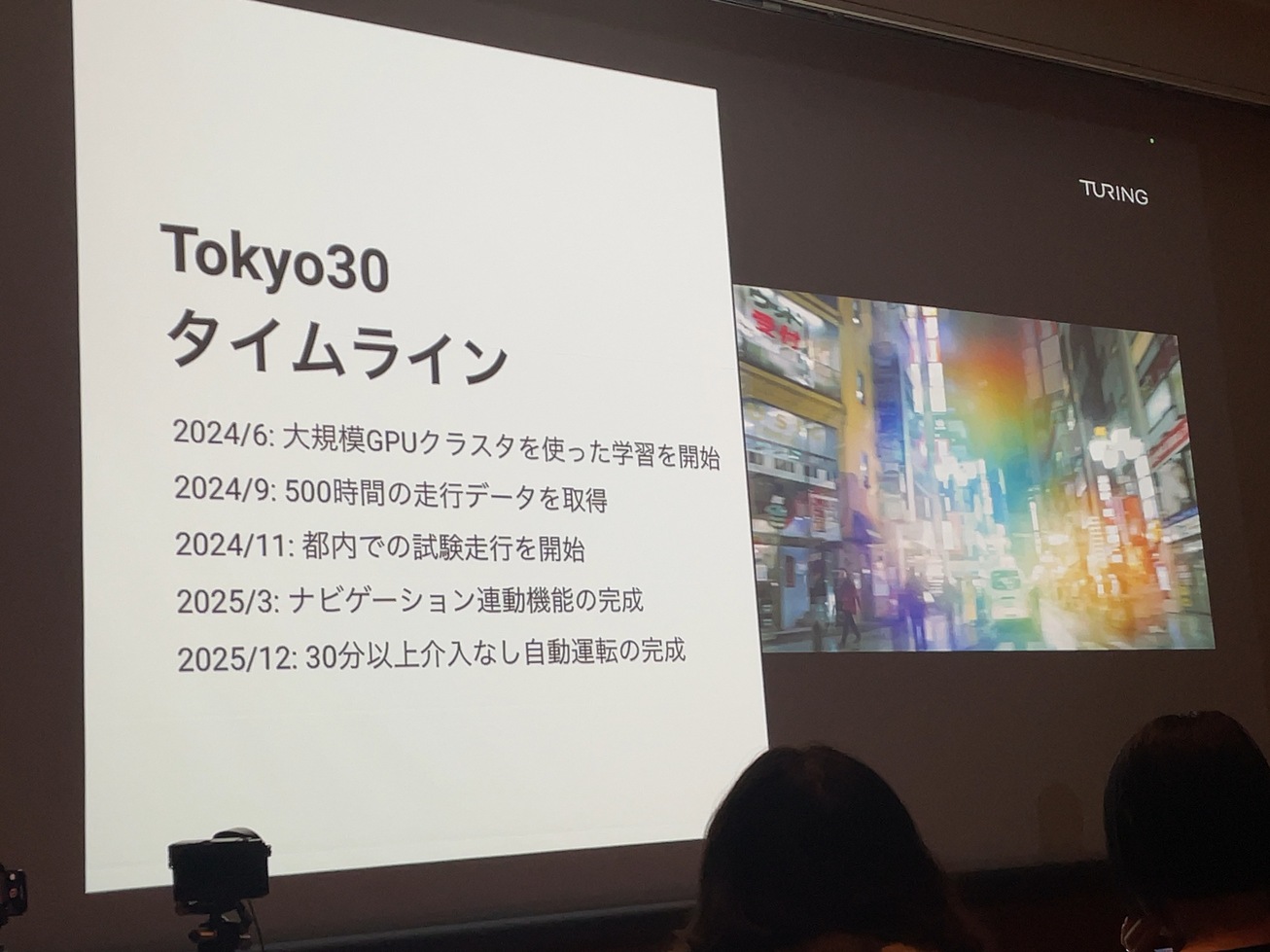

Tokyo30 2025年までに、カメラとAIだけで東京エリアを30分以上、介入なしで走行し続ける自動運転モデルを開発するスローガン。

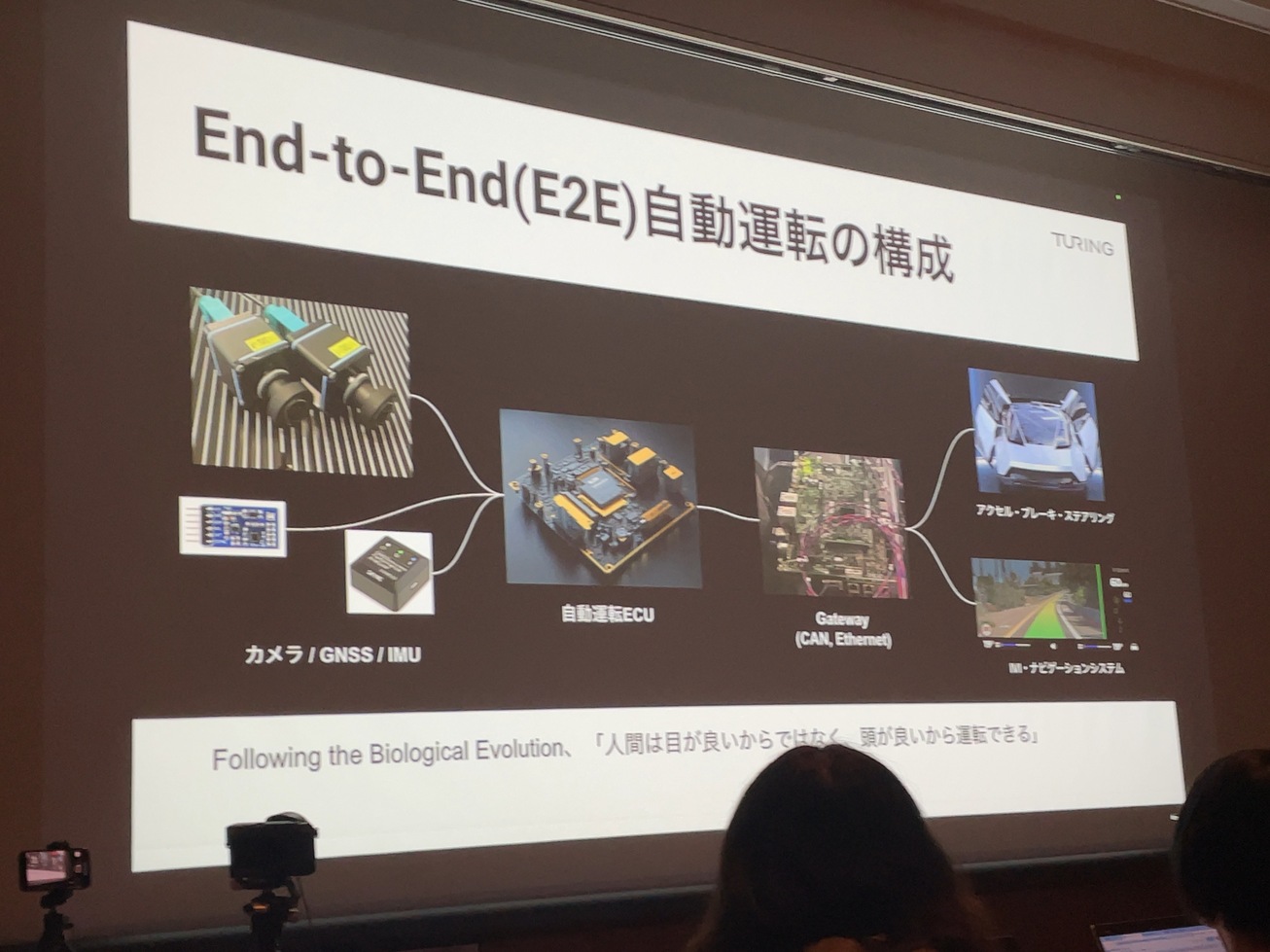

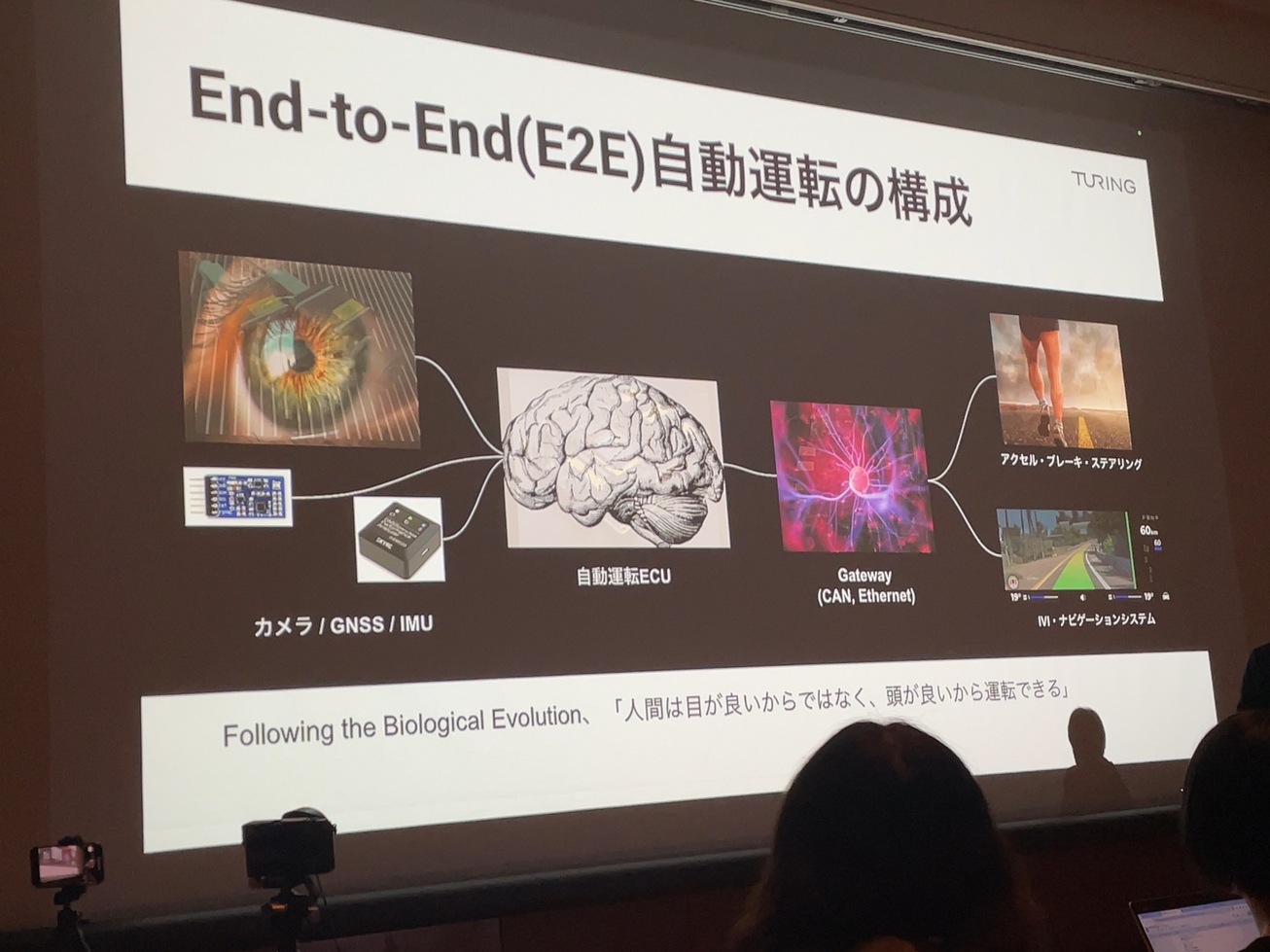

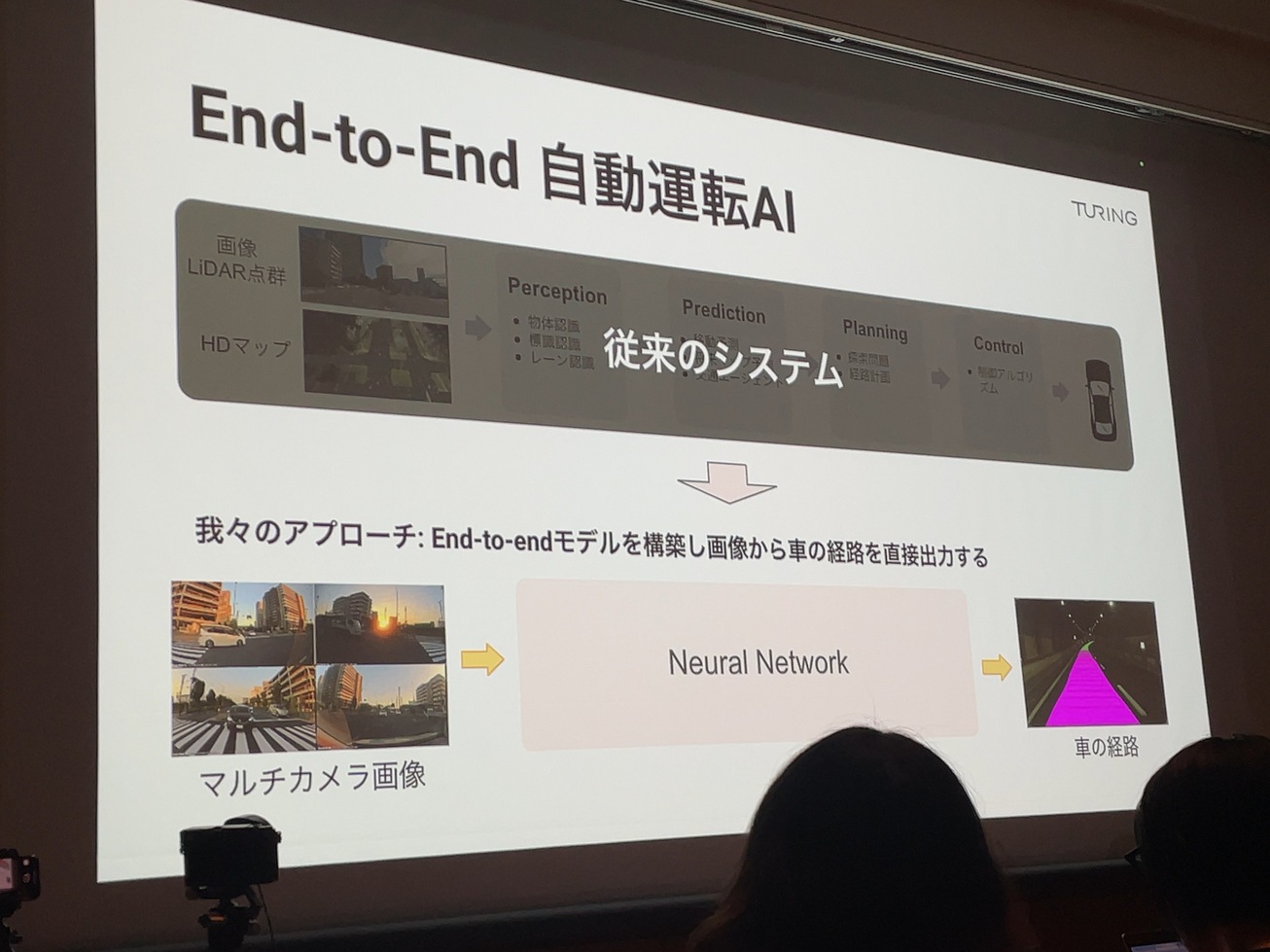

End-to-Endな自動運転の構成

End-to-Endな自動運転の構成を人に例えると

従来の自動運転システム

機能ごとに分かれたモジュールが独立して動いている。

LiDAR点群+HDマップ → Perception → Prediction → Planning → Control

End-to-Endな自動運転AI

画像から車の経路を直接出力する。

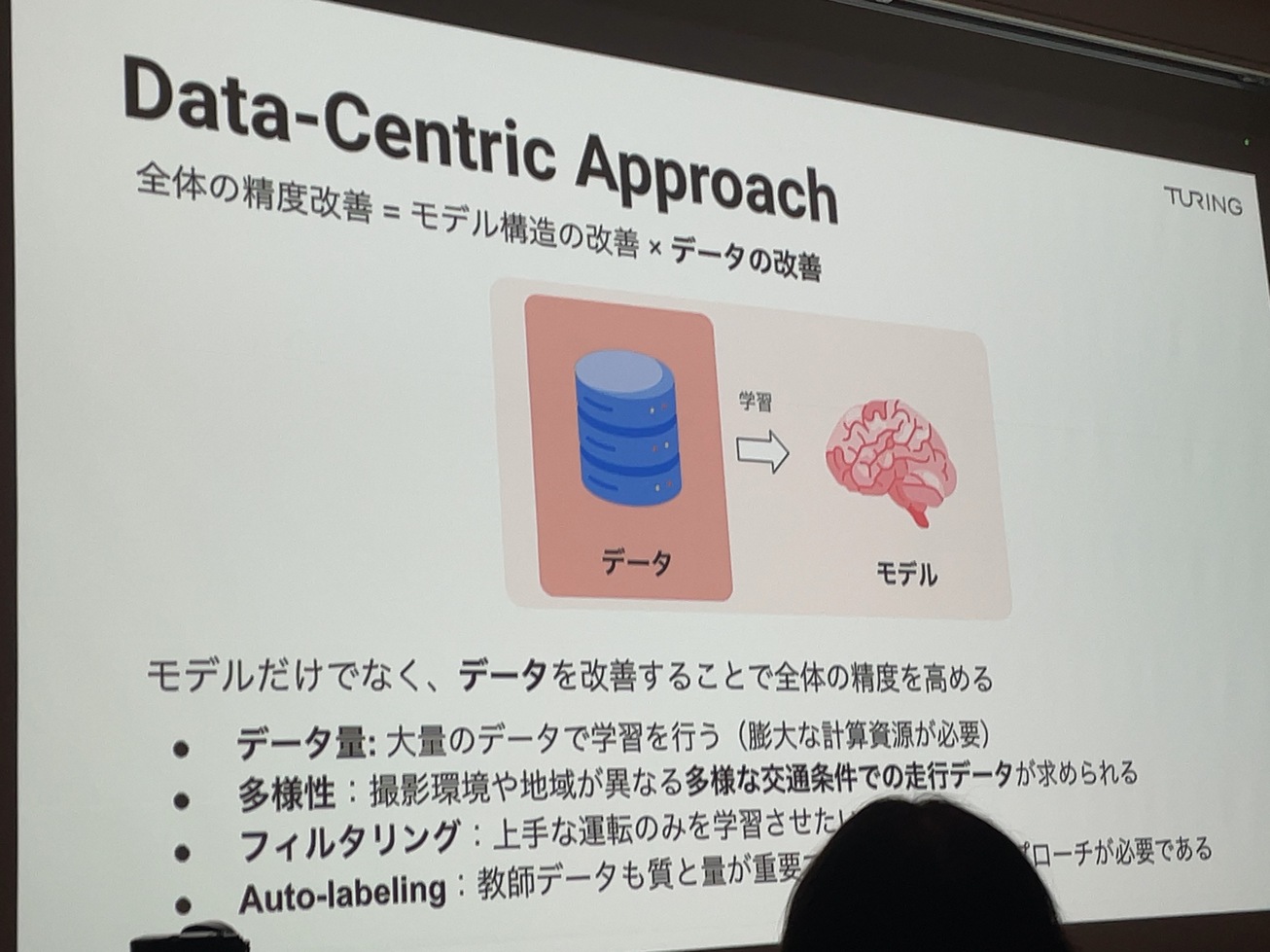

Data-Centric Approch

モデルだけでなくデータを改善することで全体の精度を高める。

良いデータを作ることで良いモデルを作る。

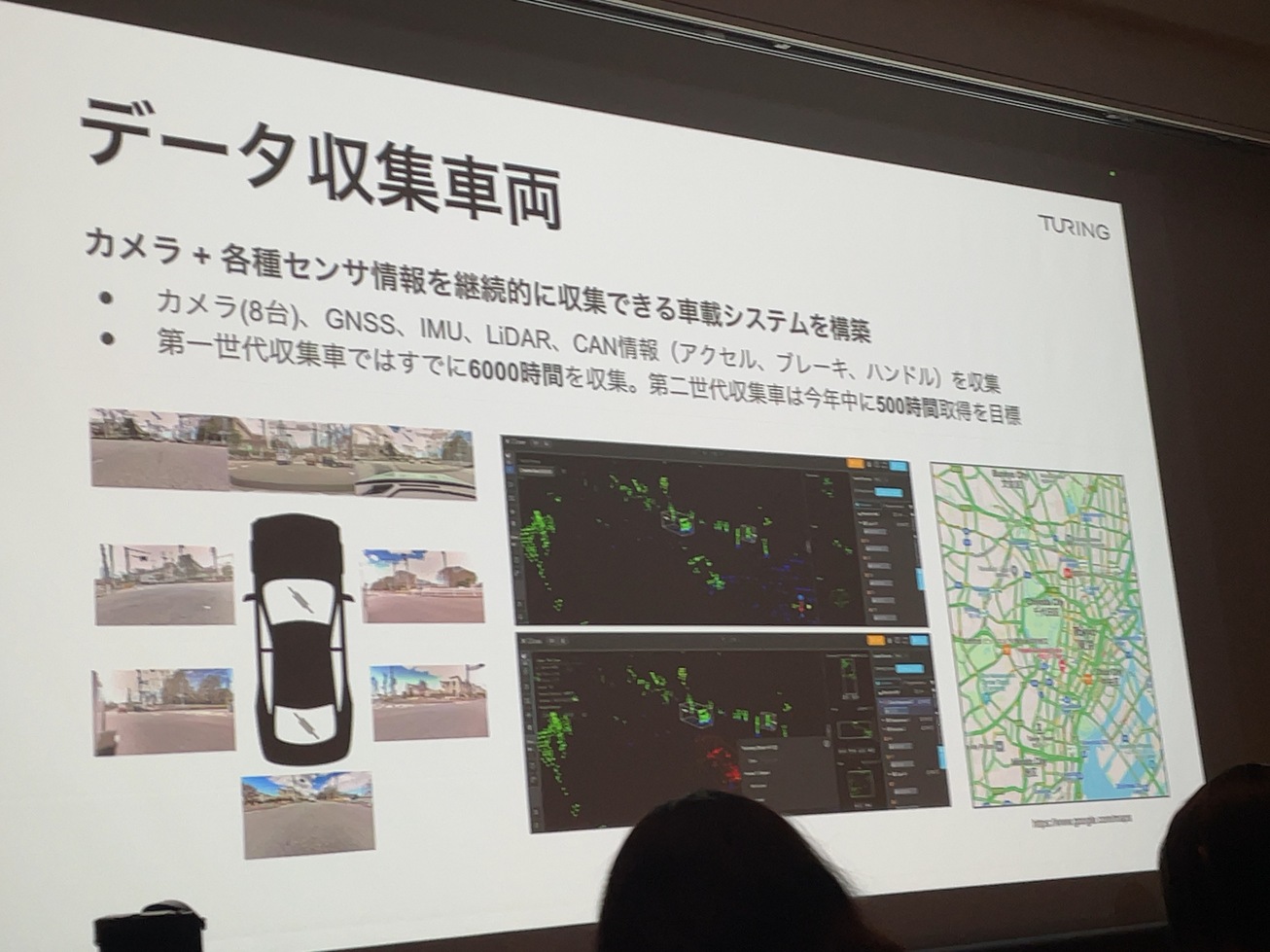

データ収集車両を使って、良いデータを集めている。

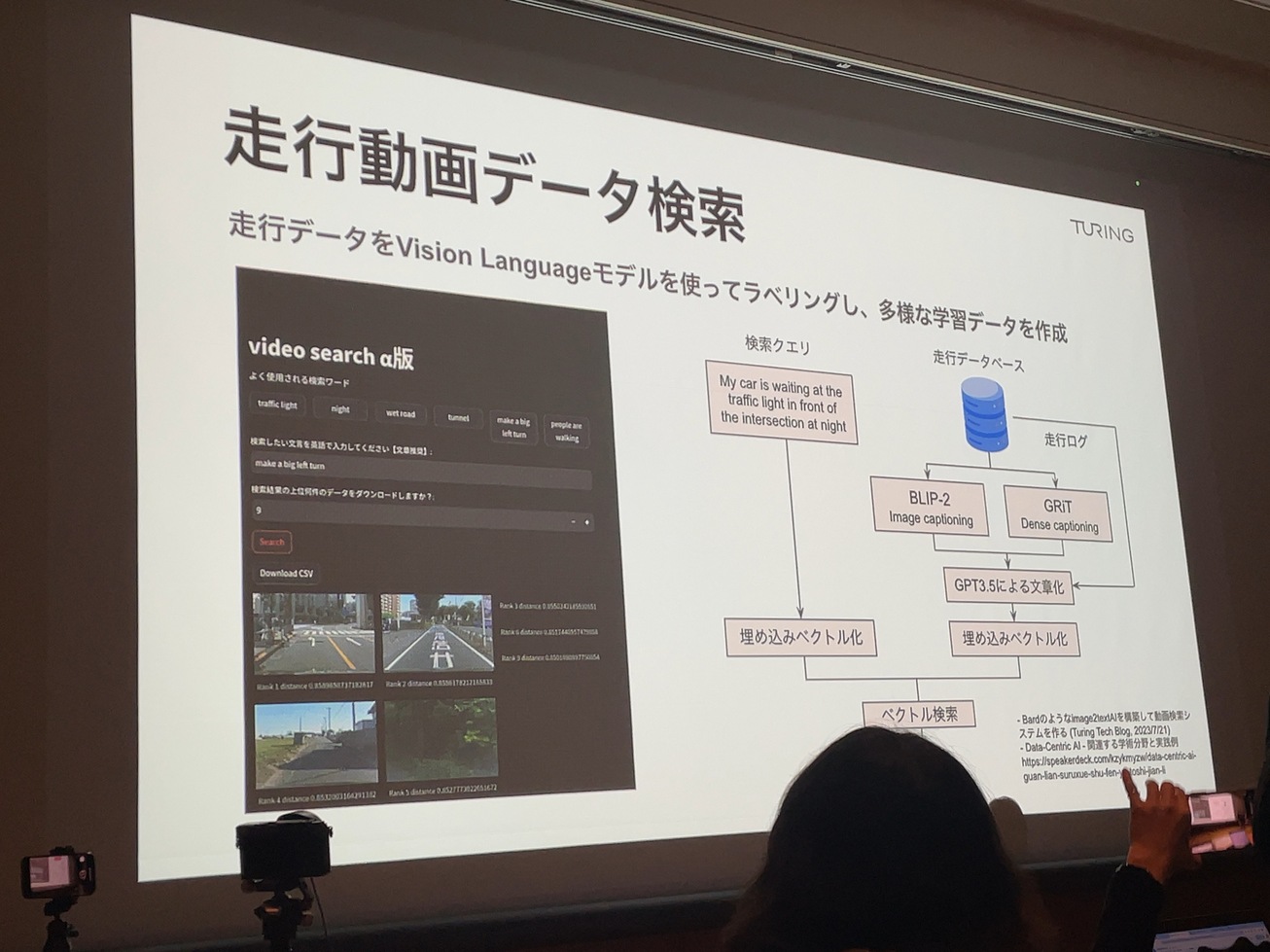

走行動画データ検索

走行データにラベリングした多様な学習データをベクトル検索する。

UIがあるが、実際はAPI

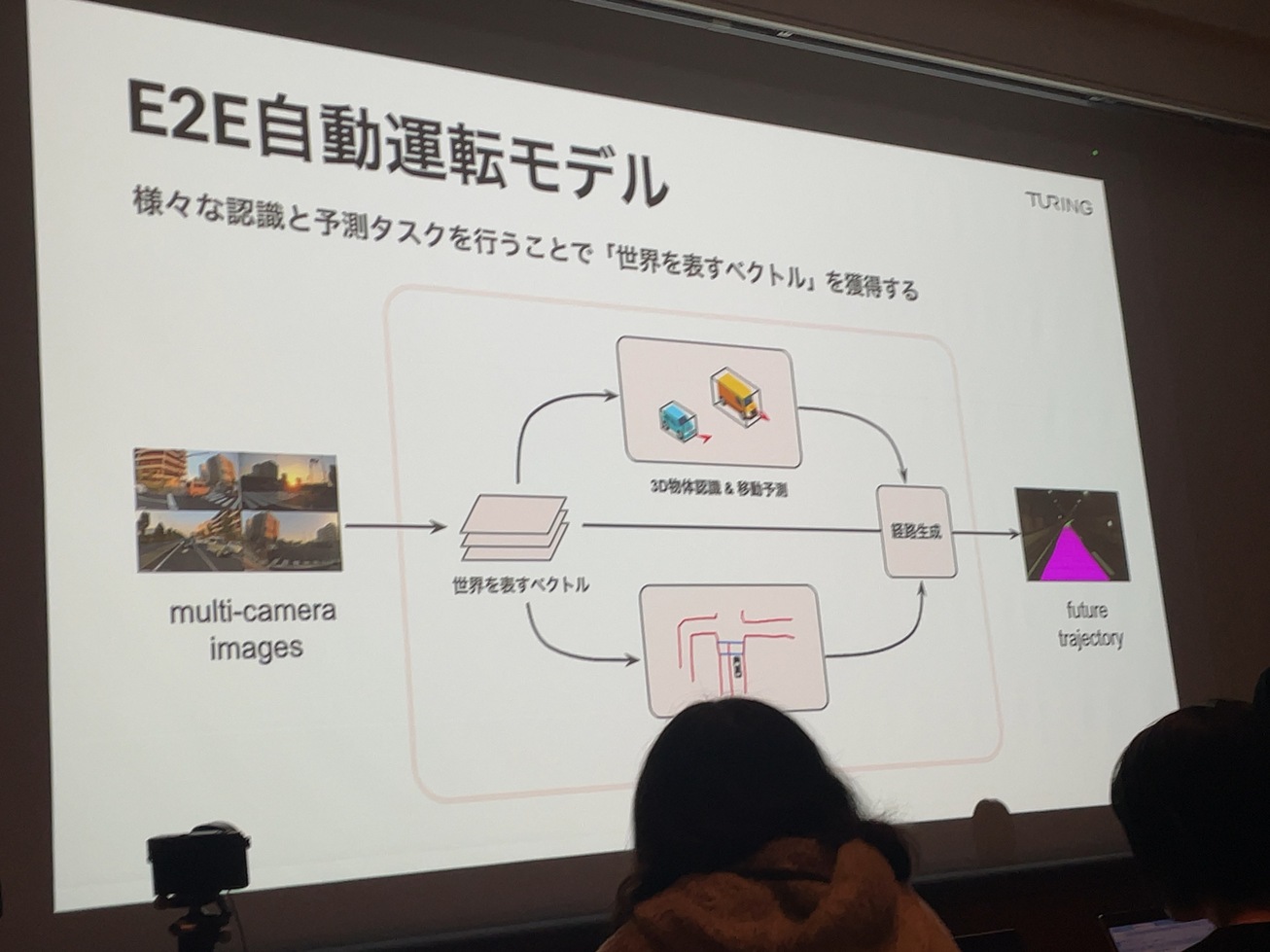

E2E自動運転モデル

世界を表すベクトルを獲得することで経路を生成する。

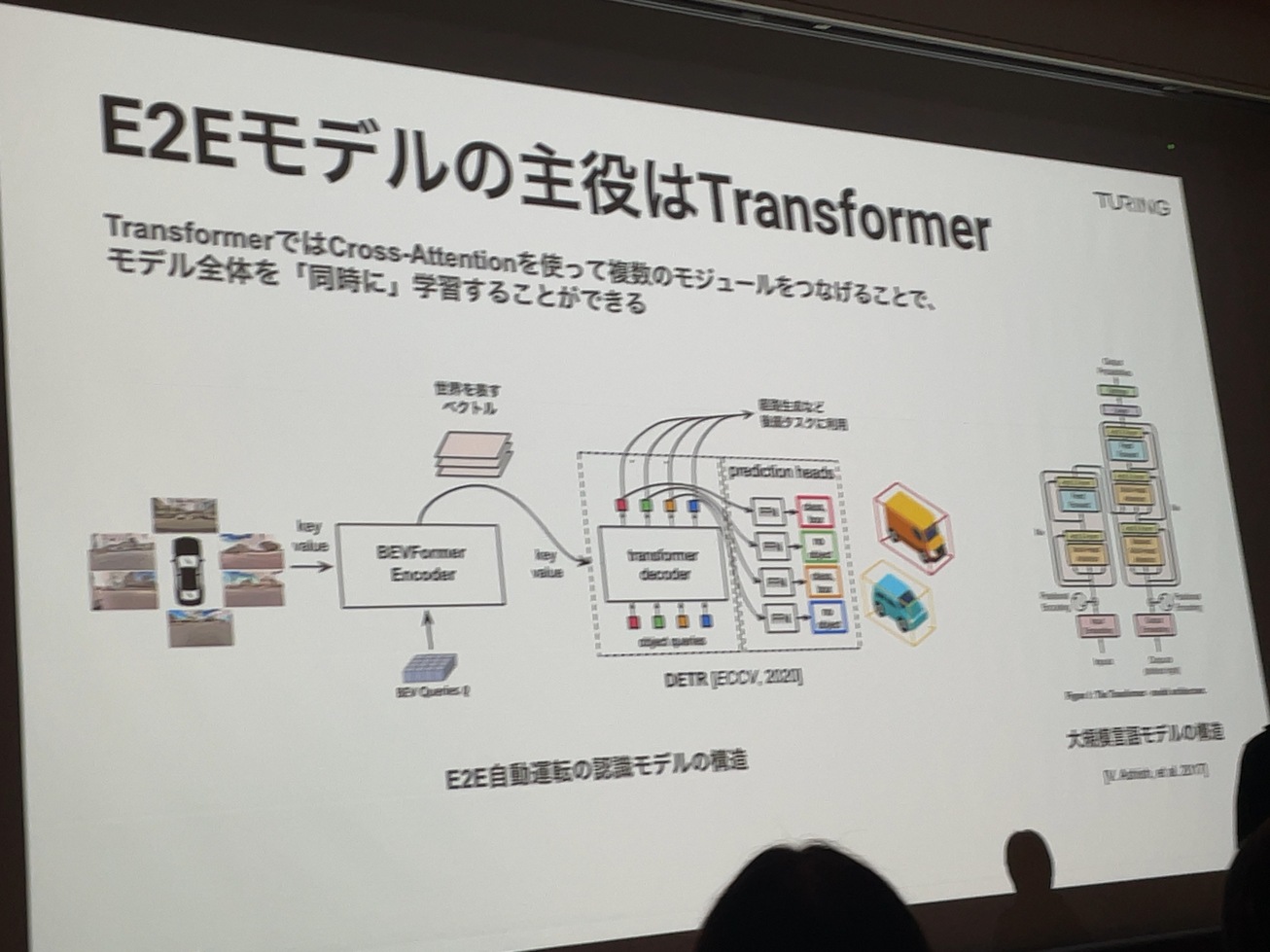

E2Eの主役はTransformer

モデル全体を同時に学習することができる。

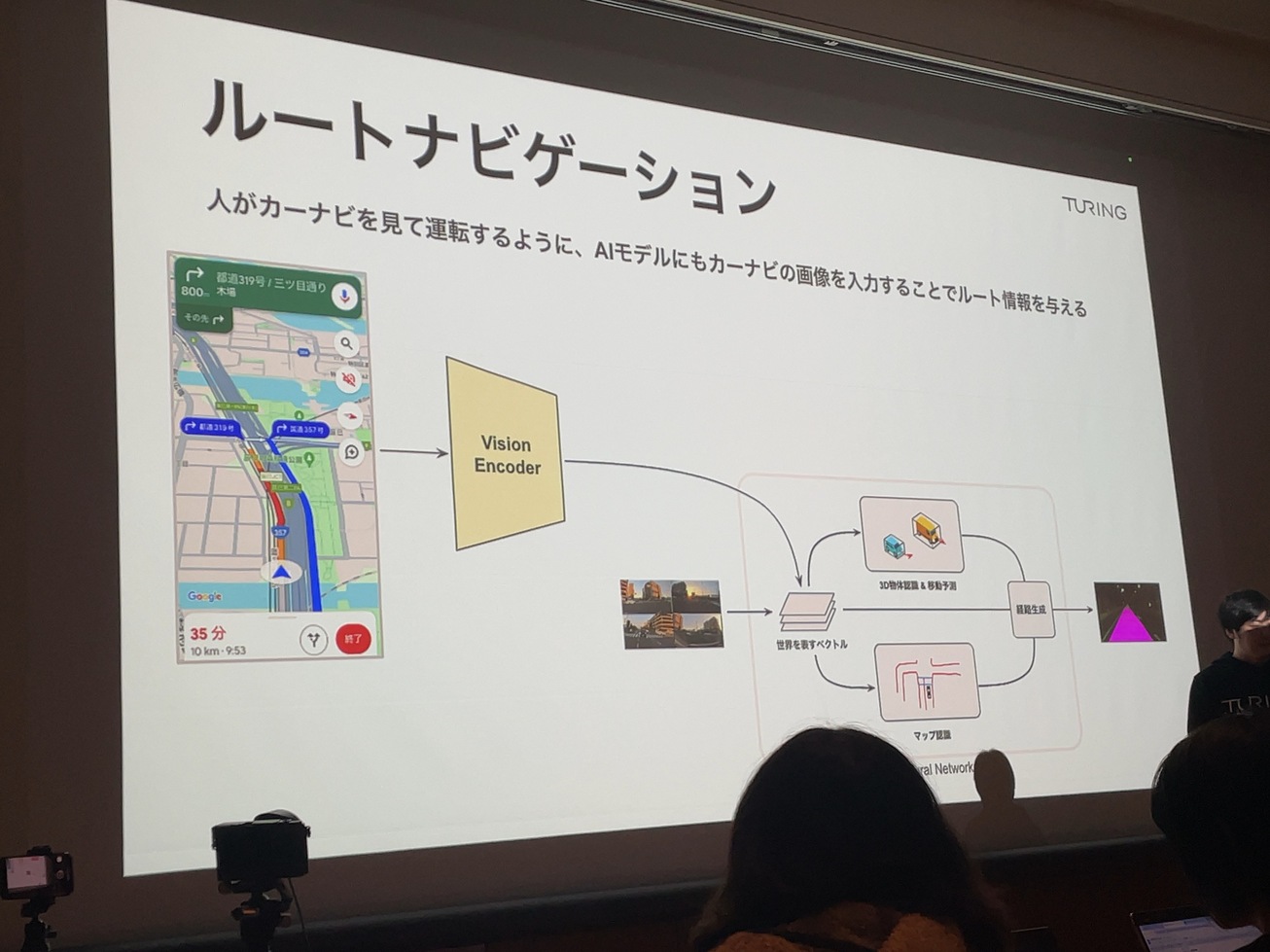

ルートナビゲーション

人がカーナビを見て運転するようにカーナビの画像を入力にモデリングする。

Tokyo30タイムライン

Tokyo30 2025年までのスケジュール

- Q&A

不正確です。大体こんな感じのやりとりと思って下さい。

Q: 動画生成AIのSoraとの比較して同じかどうか。

A: 基本的にTransformerを使うのは一緒。Soraは綺麗な映像を目標とするものなのでその点は異なる。

Q: Tokyo30でどこまで実現

A: End to Endで賢いことができる

Q: e2eで賢くと言うことだが、具体的に言語モデルをどう制御に結びつけるのか。

A: 具体的にはこれから。最終的にはCANの制御になる。

Q: Tokyo30ではハミングバードを使うか、それともサーバーか。

A: ハミングバードになる。

Q: 半導体の人員構成は?

A: 現在は人員は3人、やりたいこと以外は外のリソース使う。求人するが多くても10人とかで。

Q: 計算資源はテスラと比べてどうなんだ

A: 生成AIでは同じラインに立っている。見た目ほどのビハインドではないと思ってる

Q: カメラだけでということだがジャイロセンサーなどは不要か

A: 必要であれば取り入れるが、不要と考えている。カメラにこだわっている理由は、推論できる特徴量が多い。モジュールを減らしたい。

Q: 半導体にFPGAから次の段階のコストは?

A: 5-6年後にどうなっているかはわからないがTransformerベースは変わらないと思うのでそこを見越している。

Q: シミュレーターを使っているか

A: 検証で使うスタンス

Q: 自動運転車に対するUIは

A: タクシーに乗った時の会話のように会話ベースのUIになる

Q: 自動運転が実現されたときに寡占化になるか。

A: ハンドルがない車を買う人がどれだけいるかわからないが、その時に何社が作れているか。Turingはその1社になる。

感想:どのセッションもLLMに力を入れていることを分かりやすく話してくれていて、方向性に関しては日本のどのメーカーよりも説得力があります。

また、Heronは自動運転にとどまらず広い応用範囲があると感じており、注目しています。

AI,半導体に特化した発表ということもあるかもしれませんが、実車や部品も見せて欲しかった。

山本 一成さんと記念撮影。とても元気で気さくな人でした。手ブレすみません。

関連ページ

- Compound Startup構想

- シンギュラリティ・ソサエティ BootCamp#2 Demo Day 対談

- GraphAIハッカソンを開催しました!

- マルチエージェントの「自律的に行動する」とは何か?

- GraphAI Contribution Fes 2025 開催のお知らせ

- async / awaitについて、再確認(超初心者向け)

- 私の寿命、あと何年?

- HtmlRAG: HTML is Better Than Plain Text for Modeling Retrieved Knowledge in RAG Systemsの紹介

- Magentic-One: A Generalist Multi-Agent System for Solving Complex Tasksの紹介

- 書評:LangChainとLangGraphによるRAG・AIエージェント[実践]入門 (エンジニア選書)

- SS推薦の図書

- Singularity Societyに入るには?

- 話題のネコ型ロボット「ミーア」!パワーアップします!

- 「世界モデルを持たないLLM」にとって難しい質問のリスト

- Raycastの機能拡張をカスタマイズ(テンプレート解説)

- RaycastJapan Meetup 第0回 イベントレポート

- Raycastのイベント発表資料

- Macの生産性を10倍上げるRaycastのイベント開催!!

- 「蔦屋家電+」ミーアの展示期間を延長しました!

- 安野たかひろ × 中島聡 緊急対談 書き起こし

- 蔦屋家電+でミーアたちに合う

- 安野たかひろ × 中島聡 緊急対談

- 蔦屋家電+とTi B SHOPでおしゃべり型ロボット「ミーア」に会いに行こう🐾

- W&Bミートアップ#13in東京 Stability AIとTuringからモデルサービングの最新手法を学ぶMeetup

- Turing CTOが語る自動運転2.0 生成AIで実現する次世代自律運転

- サンノゼで開かれたVisionProハッカソンに参加しました!

- おしゃべり猫型ロボット「ミーア」を開発

- コストコを超えるイノベーション!高品質・サプライズ価格なECの立ち上げ

- 空間ジェスチャーアプリを作る

- Turing Semiconductor/AI Day潜入レポ

- アーバンデータチャレンジ2023にてW受賞しました

- visionOSアプリ、Teegardenの開発物語

- エンジニア未経験のPMがChatGPTを使って簡単なプログラミングだけでプロダクトを作った話

- 新しい挑戦を躊躇する心理:優先順位の真実

- 時を超える知の投資:良書と大学教育の意義

- 動画生成AI SORAの革新とサム・アルトマンのビジョン

- イノベーションを起こしやすい組織について

- サッカー選手になりたいが、サッカーボールを蹴ったことがない人の話

- 2024年、国産クラウドに期待

- 仕事と焼肉、意外な共通点とは?

- 業界に激震!!Llama2オープン化がいかにすごいかを解説。

- OpenAIによる今回のアップデートがなぜ私たち開発者たちの間で「神アップデート」と呼ばれているか解説!!

- 統計的自然言語処理によりおぼろげながら浮かんできた思考の仕組みと教育の未来

- アプリ開発の常識を覆す? GPT-4の凄さに魅了された体験談

- あなたの NFT がゴミになるかもよ?

- GPT3の本質を理解し、ChatGPTを使いこなす為に知っておきたい事!!

- 今世紀のベストペーパー

- 「Web3がもたらす未来を考える」中島聡×塚田学対談

- これが未来の生活スタイル。遊牧民のように旅をしながら暮らす理想のノマドライフの提案。

- あなたのNFTは大丈夫?!某NFTが存在するのか確認してみました。

- 元米マイクロソフトのソフトウェアエンジニアが教える「エンジニアになりたいなら知っておいた方がいいコト!」

- 「フルオンチェーンでないNFTの怖さ」が現実に!〜フルオンチェーンNFTを可能にする技術

- 知らないと恐ろしい事に!AM/PM表記のなぞ?!

- DAOに対する「株式会社に代わる新しい仕組み」や「参加者全員が成功の果実を共有できる」という認識は間違いです。DAOの本質とは?

- スマートコントラクトが人々の行動を変え世界を変える!!

- フルブロックチェーンのスマートコントラクトは世の中に価値を提供し続ける!

- ビットコインこそ「究極のDAO」

- Pride Squiggle で画像をオンチェーンでダイナミックに生成するために使ったテクニック

- Netscapeからシェアを奪い取ったInternet Explorerが、終焉してしまった理由

- ソフトウェア・アーキテクチャの面からWeb2.0とWeb3の違いを分かり易く解説

- Web3の技術は素晴らしいがそれを生かすも殺すもエンジニア次第!

- AppleのWWDC22の基調講演で、最も私に刺さったのはCarPlay!!これが何を意味するのか?!

- Web3時代!NounsDAOの最大の発明はこれだ!

- 日本のシステムは最大のポンジースキームだった!?

- そして、すべてはソフトウェアになった

- パーソナル・ブランディング

- あなたの知らないWeb3/NFT/DAOの真実

- ハッカソン開会式のご挨拶「過去の戦争と比べて違うなと思うところ」

- NounsDAOをフォークした人にインタビューを受けました(翻訳)

- すでに解散したバンドのファンになった話

- 帝国化する企業と民主主義の末路

- 衰退していく日本のテレビ業界について語る

- Youtube のダークサイド

- 「理解できない」と言える強さ

- Oculus Go

- メタバース時代に掘り起こせそうな本屋さん

- 日本は少子高齢化・人口減少で新しい枠組みを作るのに良い実験場-<コモン>の領域を再建し人々の生活を安定させる

- Nintendo Switch とエクササイズ・バイク

- こんなダメな日本がかわるきっかけは「戦争か大災害しかない」噴火・地震・メタバースなど

- カルト・オンライン

- 中島聡×草場 壽一 「ソサエティを立ち上げた思い」

- 人工知能・機械学習の父

- 起業家と現実歪曲空間

- デマンド交通『おでかけ号』のタクシー予約/配車システムをDX化、高知・土佐清水で新登場

- 中島聡×SONY社内イベント

- メルカリ × 中島聡 ディスカッション イベントレポート

- 自動車業界の近未来

- 未来の社会のあり方

- SS推薦の動画

- 汎用人工知能・強いAIの開発にまつわる懸念点

- 未来のソフトウェアエンジニア教育を考える

- 財政出前講座 SIM2030

- Elon Musk の悩み

- Elon Musk のビジョン

- 自動運転社会のひとつの形

- Amazon Goに行ってみた

- 中島さん関連動画