Turing CTOが語る自動運転2.0 生成AIで実現する次世代自律運転

はじめに

日本でテスラを追い抜いて完全自動運転を目指すTuring社のCTO青木氏が自動運転2.0について解説されたので書き起こしをお届けします。

会場入りが遅かったので質疑応答からの参加でしたが、MIT Technology Reviewさんが動画をシェアして下さったので内容は動画で見ました。なので、レポートのソースは動画になります。

チューリングと自動運転の話をこのあと日比谷BASE Qでお話しします~(200人近く申込来てる!)

— Shunsuke Aoki| チューリングの創業者 (@aoshun7) April 24, 2024

自動運転2.0 ー生成AIで実現する次世代自律車両ーEmerging Technology Nite #28 (MITテクノロジーレビュー主催)https://t.co/PCkCTqxOKN pic.twitter.com/M3MfT6zfaW

自動運転2.0生成AIで実現する次世代自動自律車両

[以下青木CTO]

よろしくお願いします。

今ご紹介預かりましたチューリング株式会社の共同創業者取締役CTOを務めています青木と申します。

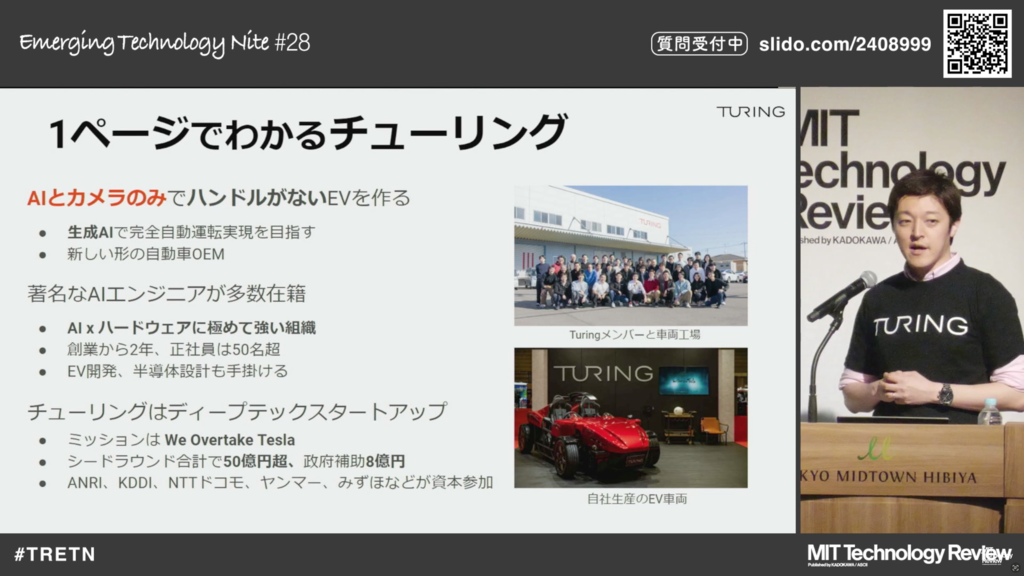

昨日発表されましたが、今回チューリング株式会社は創業して2年になりますが、NTTドコモさん、みずほさん、デジタルハーツさん、あとヤンマーさんとかから資金調達を行いまして、プレシリーズAというなかなか難しい表現ですが、プレシリーズA前半で30億円という、まぁこの後なんかがあるんだろうなぁという、こう含みのある持たせ方をしています。

今日は資金調達とかそういう話ではなくて、テック領域の話にフォーカスを当てて、自動運転2.0生成AIで実現する次世代自動自律車両というタイトルでトークをさせていただこうと思います。

まず、1本動画を見ていただきたいと思います。

- コンセプトカーの動画再生

- (注)これの短いバージョンを音無しで再生しながらの解説でした。

- (注)これの短いバージョンを音無しで再生しながらの解説でした。

いわゆる基盤モデルとか生成AIという単語を2021年ぐらいから単語としては使っていたんですが、なかなか理解されない状況下で、世界で初めて生成AIでデザインする車両ということで発表させていただき、こちら意外とアメリカとかイギリスからは反響があって、生成AIとかそういうもので自動車の領域ってもっと変わるんだという反応を得ることができたかなと思います。

まぁ完全自動転になるともちろんハンドル席もないし、外見えなくてもいいかもしれない、おそらく居住性の高い大きな車になるんだろうということで、こういう車を発表させていただきました。

1回、会社側の説明に入りますが、我々「生成AI」とか「AI一発で自動運転をさせましょう」ということで、「自動運転2.0」というタイトルをつけています。自動運転車ってもう10年ぐらい、多分皆さんメディアで見たり、もしかしたら乗ったこともある方もいるかもしれません。意外と公道に出てこないなぁと思っている人もいると思います。その辺の話も含めて、今日はお話しようと思います。私はもともと、自動運転車をアメリカで作っていた人間で、CEOの山本一成さんは「将棋AIPonanza」というものを作っていた人間です。本当にテックの人たちが創業し、メンバーも全員エンジニアというチームを作って、エンジニアリングに強い自動運転企業を作ろうということで、こういう会社を始めました。ミッションは「We Overtake Tesla」というふうに書いてますが、これを日本語に直すと「テスラを追い抜こう」ということで、“オーバーテイク” ってF1とかでよく使う言葉ですが、追いついて追い抜いていくぞということです。別にテスラがめちゃくちゃ気に入らないとかそういうわけじゃないし、トヨタさんとかホンダさんがめちゃくちゃ気に入らないというわけじゃなくて、テスラってすごい会社なんですよね。自動車会社ってもう変わらないって言われ続けていて、もう生まれないと言われていたのに2000年代に入ってここ10年〜15年ぐらいで、新しい自動車メーカーを作って普通に一般の人たちが、買って乗れる車を市場に出している。SNSを見ているといろんな叩かれ方しているけれども、それだけ注目度が高くて、かつ普通に買える車をゼロから立ち上げたというのは、すごくリスペクトするべきだと思いますし、そこに挑戦をしなきゃいけないということで掲げています。先ほどちょっとお話ししましたが、一番最初の調達の時にKDDIグループだったりとか、いくつか入っていただいて今回もドコモさんとかヤンマーさんとか、割といろんな会社に入っていただいて、金額面でいうと50億円超を全体で調達していて、政府補助金も10億円には届かない程度のお金を入れていただいています。

ちょっと個人の話をしますが、私は東大で修士まで出てアメリカのカーネギメロン大学で博士をやっていました。

この時に、真ん中に写ってますように、自動運転車を作ってたりですとか、これをフィラデルフィアとかワシントンDCとかピッツバーグとか、そういうところで自動運転車のデモンストレーションとして、いわゆるレベル4ですね、決められた道を決められたシナリオのもとで自動運転させるというプロジェクトに入って、自動運転車を作って、その間ゼネラルモーターズさんとかグーグルさんとかと一緒に研究したり、自動運転車を作ってたりとか、すごく幸せな20代を過ごせたかなと思います。

ちなみにチューリング株式会社というのを2021年8月に創業して、MITテクノロジーレビューさんからも、実はイノベーションアンダーサーティーファイブという賞をいただいていて、もし若い方で35歳以下で聞いている方がいればぜひチャレンジしていただければと思います。

その時に一緒に取った人たちも会社立ち上げたりとかアカデミアで活躍してたりして、意外と横のつながりがあっていいイベントだったかなと思います。

私自身はすごく幸せでグーグルさんとかゼネラルモーターズさんと一緒に自動運転車を作って、なんかアメリカでやってますみたいな。日本はちょっと遅れてるかなとアメリカで言っていた一方で、やっぱりこうふつふつとした思いもあって、なんかこの後日本って自動車業界すっごい強いけど、どうするんだろうと思っていた中で、

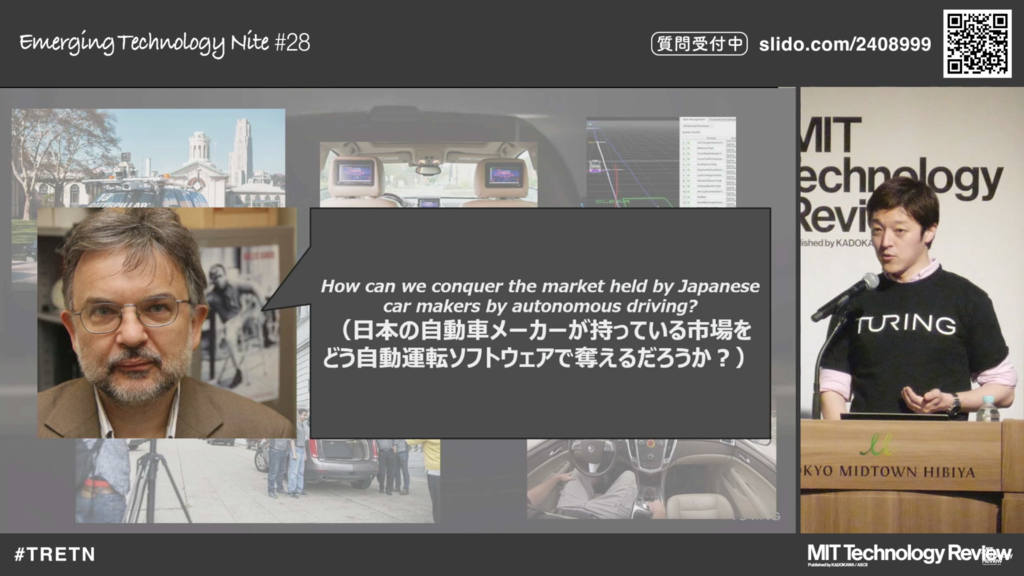

あるルーマニア系の教官、向こうでPhDやると教官が5〜6人について、彼らがPhDに値するかというのを査定してくれるんですが、その査定官の一人の教官にこんなことを言われました。

”How can we conquer the market held by Japanese car makers by autonomous driving?”

日本語に直すと「日本の自動車メーカーが持っている市場をこの後自動運転システムでどう奪っていけるか」という話をランチしてる時にパッと気軽に言われたんですね。

ある側面では彼は私のことをアメリカにいるアジア系の留学生として扱ってくれた一方で、日本人として見た時に、あぁなんか市場を奪われるかもしれないんだっていうショックを受けたわけですね。

これがなんでショックなのかを家に帰ってふつふつと考えてみたんですが、実は日本ってものづくりがすごい強い、まあ実はじゃないですね。すごい強い国なんですよね。製造業とものづくりで食べてきた。なんかこう町工場がよくテレビとかに出てきますが、パソコンの部品を作っているとか、iPhoneの部品を作っている、携帯電話の部品を作っているという話はよく聞くと思います。ただ一方で、ソフトウェアが入ってきて業界を変えますよって言った時に、その流れに置いてかれてくことが、ここ30年ぐらいすごく多かったんじゃないかと思います。一番大きな例が、Windows OSが出てきてなんかガワだけ作るのが日本で、日本のメーカーとか、韓国・台湾のメーカーが作っていて、ソフトウェアのところはWindowsが取っている。もしくはiOSが取っている。同じように、携帯電話も日本はすごく強かったはずなのにiPhoneが出てきて、ソフトウェアのところは、アメリカのAppleが取っている。なんかニュースとかSNS見てると、いやでも部品は日本のものが使われてますよって言っているんだけれども、本当に利益取っているのどこなんだっけ、一番取っているのはAppleですよね、Windowsマイクロソフトですよね。というのはすごい悔しいことだと私は個人的に思っています。

同じ変化が車業界で起こるんじゃないか、起こるんだったらすごく恐ろしいことが起きると思っています。実際今、テスラはめちゃくちゃそういうことを起こしています。ソフトウェアファースト、ソフトウェア中心の車を作っていて、もう鍵すらもない。乗り込んでそれをユーザーだと認識したらエンジンが、電源が入る。そういうソフトウェアを作る人が考えた車を作り始めている。車好きの人間からしたら、いや、そんな人間の安全とか命に関わるものをスタートアップで、テスラみたいな会社が作ってどうなんだ、という気持ちもある。

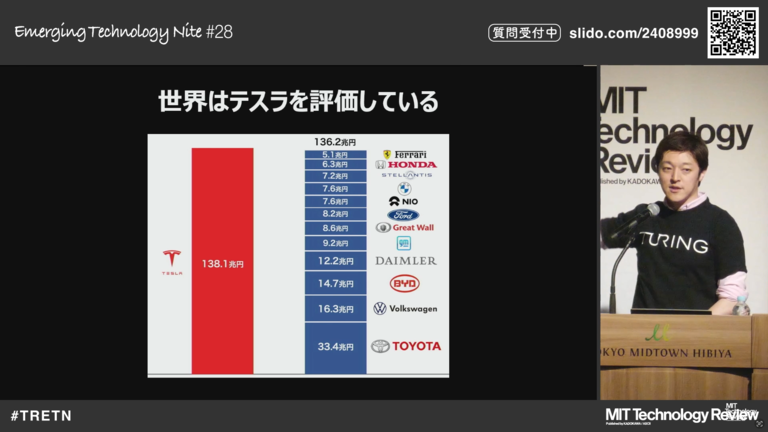

一方で、世界はテスラを評価しているわけです。これ左側にテスラの時価総額が書かれていて、右側に既存の自動車メーカーが書かれています。これは1〜2年ぐらい前の情報なので少し動いていますが、テスラの時価総額に対してトヨタさんやフォルクスワーゲンさん、ダイムラーやGMを積み上げていっても、これだけ差がある。これ別に時価総額がすべてと言うわけではありませんが、テスラを確実に皆さん評価しているんですよね。30年後に世界一になる自動車メーカーどこだって言ったときに、いや、トヨタじゃないんじゃない、ホンダじゃないんじゃない、って多分世界の人たちが思っている。テスラはあるかもしれない、そう思っている。これはすごい悔しいことだと、私は個人的に思っています。

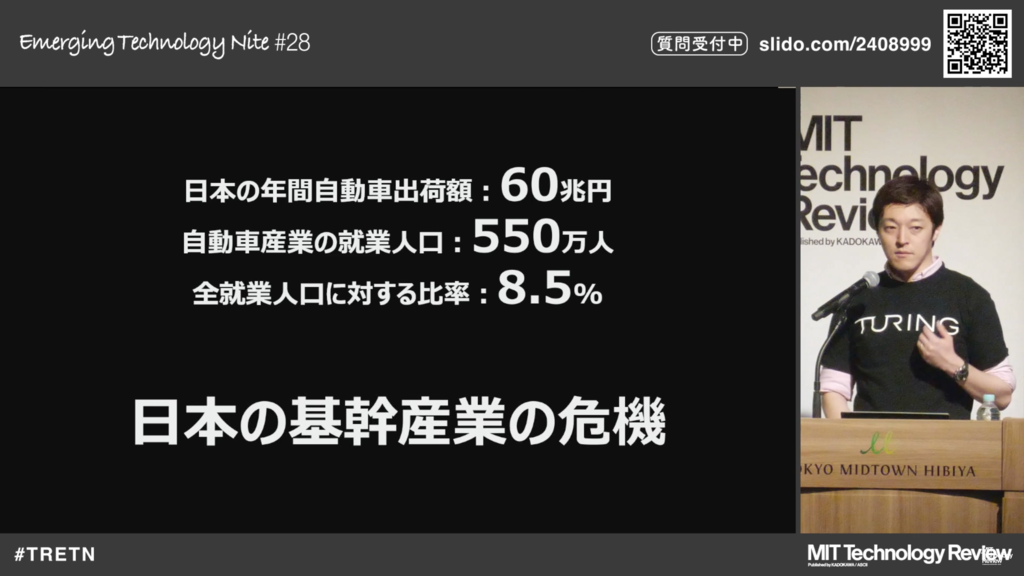

実際数字に出してみると、日本の年間での自動車の出荷額は60兆円を超えていて、全人口に対しても約10%ぐらいが自動車で生計を立てています。これをソフトウェアで荒らされるというのは、すごく怖いことであり、基幹産業の危機と軽く言えないほどです。我々が外貨を稼いでいる産業が一つ消えてしまうか、あるいは我々が今想像しているよりも小さくなってしまう可能性も考えられます。そこは本当に怖いことだなと思っています。

もう一つ良い表現をすると、情報のプラットフォーム化が進みます。データがたくさん取れるとか、ボタンが単純にディスプレイに置き換わったという話ではないんです。

iPhoneの変化と同じように、車もエンジン車がEV車になりました。

自動運転化が進みましたという話だけではなく、ソフトウェアによって業界がぐるっと変わっていくというのを考えると…

なんか経産省が最近よく言ってるデジタル工作人とかITの植民地という、かなり強い単語を使っていますが、なんかこうサービスを作れば作るほどアメリカだったりとか中国に払っていくお金がどんどん増えていって、これアプリ作ったことある方がいればわかると思うんですけど、なんかスマホアプリって学生の時私作ってて楽しかったんですよね。楽しいですしちょっと小遣い稼ぎになる。でも一方で3割ぐらいAmazonに払って、3割ぐらいiOSに払って、なんかすごい税金みたいだなと思うんですけど、これって江戸時代の五公五民とか、そういう感じなのか?結構悔しいなって思っていました。といった時に自動運転化とか車のソフトウェアっていうところは、

日本でやらなきゃいけないところだと思って、チューリングという会社を創業しています。

自動運転車って、なんかこう、来るぞ来るぞと言われつつもなかなか来ないんですよね。

最近、長野県で走っているレベル4の自動運転車です。別にこれを批判するわけじゃないですが、なんかセンサーをたくさんつけて、例えば誘導線を引くと安全に走行できますよとかですね。いろんなセンサーをつけて複合的にすれば安全性が高まりますと言っています。たぶん研究者とか一人のエンジニアとしてはいろんなセンサーを評価できて楽しいとかですね。このセンサーがなくてもこっち側が動いてすごく嬉しいとか、やっていくんだけれども、本当にユーザーが欲しいのはこれなんだっけ、というのは、やはり我々は常に問いかけなきゃいけなくて、技術の進化にこういうことをやらなきゃいけないのはそうなんだけれども、一方で今、中国を見るアメリカを見ると自動運転車が公道を走り始めているという事実は、ちゃんと見なきゃいけないかなと思っています。我々が「AI一発で」と言っているのは、こういう風にセンサーをたくさんつけるとかね、ルールをたくさん加えていくという話じゃなくて、おそらく今、我々が生きている2024年って、ChatGPTが出てきた2023年、文書が生成されます絵が生成されますという、いろいろなことがAIによって塗り替えられていく。一つ一つのタスクがAIにとられていくのを考えると、自動運転が社会の期待を背負い始めたのかなというふうに思います。

我々は、生成AIと自動車作りの両方で2つの大きなプロジェクトに取り組んできました。

一つ目は、世界初のコンセプトカーの発表であり、その初公開動画も制作しました。

そしてもう一つは、LLM(Large Language Model)を活用した世界初の自動運転システムの開発です。

これらのプロジェクトについて、少し詳しく紹介していきたいと思います。

生成AIやLLMとか、本当に自動運転車に必要なんですかと言われると、必要なんですよね。なんで必要かというと、LLMってある程度の常識もしくは、生きてきて獲得してきたような、なんかふわっとした情報を持っていて、この彼らというか生成AIやLLMって、なんか医療の情報、法律の情報、文化的な情報など、ある程度常識を獲得しているわけです。実は我々自動車の運転を確実にするためには、そういう社会的な常識、文化というのも理解しないといけないんです。

何かこう、自動運転車の研究とか情報を見ると、「Waymoさんが2万キロ走りました」とか「トヨタが5万キロ走りました」という、なんか走った距離によって評価が出されるかというと、意外とそうでもないんですね。なんでかというと、多分この中にも運転する方しない方いろいろいると思いますが、私たちって運転めっちゃするから運転上手なんですか?運転しないからできないというのはあるかもしれないけれど、なんか5万キロ走ったから運転上手なんだっけ?そうじゃないですよね。実は18年間生きてきて、いろんな常識を獲得しました。そこで教習所というものに通って交通ルールもしくは運転の文化を理解して、運転ができるようになる。実は人間ってこの自動車の中ではなくて、外で獲得した知識を運転に使っているわけです。というのを考えると、このいわゆるLLMみたいな常識を獲得している、社会的な文化を分かっているAIというものを自動車に使わなきゃいけない。それくらい運転というタスクは難しいタスクだと、我々は考えています。従来型の自動運転車ここ10年間ぐらいって、センサーをたくさんつけるとかライダーで何か情報を見るというのをやってきました。私もやってきました。ただ一方で、本当に完全自動運転車できるのかというと、なんか明らかに足りてない技術があったんですね。あったからこそなんかコーンを置いて道を決めてそこを走るとか、工場の敷地内だけ走るとか倉庫内だけ走る自動運転車が出てきても、なんか意外と公道に出てこない、そこが今の現在地かなというふうに思います。

我々ここ10年ぐらいでたくさんのことを見てきました。左側に書いているのは、縦軸が性能で横軸が時間軸で、ルールベースのものをコツコツ作っていって、なんとなく動くけど完全にはならないな、めちゃめちゃ強くはならないな、という感じでコツコツ積み立てていくんですね。これをルールベースと呼んでいます。ルールをたくさん作ってそれに合わせて、ロボットが動くとか、プログラムが動くのでマイルストーンだけ追ってます、という人からするとルールベースってすっごい安心するんですよ。

あちょっと動いてるみたい。半年後に行ったらまた動いてる。少し進展している。でもそこから大きいブレークスルーって起きてきましたか?ここ5〜10年間のブレークスルー、例えば、OpenAIがGPT-3.5やGPT-4を出しました。Stability AIが絵を書くAIを出しました。多分アレって1年前に誰かがチェックしに行っても何にもないんですよ。もうちょっとでできるから待っててという人がいて、本当にできるのかどうかをチェックする人がいて、ある日突然、汎用で強力なAIが打ち抜いていくという現象を、我々は目にしてきました。

OpenAI、Stability AIと同様に、我々のCEOが将棋AIのPonanzaというのを作っているんですが、Ponanzaもある日突然強くなって、名人に勝てるぐらいの強さになりました。もうそこの赤い線ですね。これがルールベースをぶち抜いた時には、もうルールベースは絶対に追いつくことができないわけです。将棋AIって今はもう、本当にディープラーニング一発でできるようになっている。ちょっと自慢すると、うちのCEOがPonanzaを作っていたんで、藤井聡太さんもうちのオフィスに遊びにきてたりするんですね。

実は10年ぐらい前、私が学生だった時覚えてるんですけど、東大とか筑波大にも、もしかしたら今も将棋AIを作っている人や囲碁AIを作っている人がいるかもしれませんが、昔はそれだけやる人たちや研究グループが東大とか筑波大とかにもあったんですよ。なんか王将の横に金があると5点、1個離れたら3点みたいな世界があって、それを全部点数づけしてやっていく世界ってのがありました。一方で「いやもう人間と同じように棋譜を読み込んで、AI同士戦わせればいいじゃん」という人たちがいて、まあそれの最先方がPonanzaなんですけども、そういうのをぶち抜いていく世界というのを、我々は見てきました。

同じように自動運転車も、おそらく今ルールベースと赤線と黒線が交差するちょっと手前だと思いますが、おそらくAI一発でというのがもう近い将来起こると思っています。なんでこれが必要かというとですね。

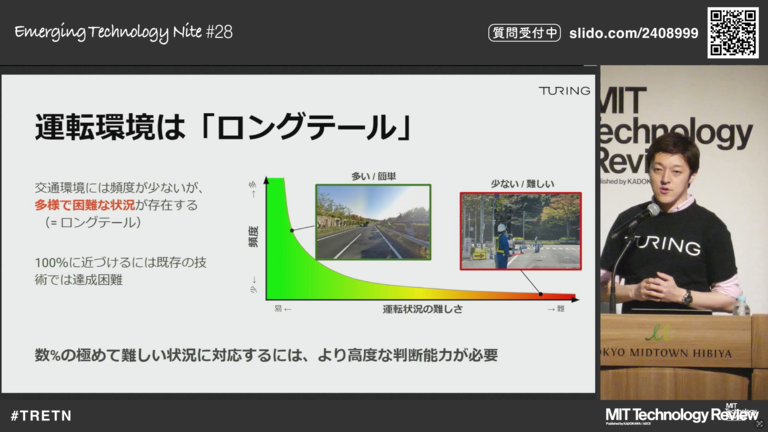

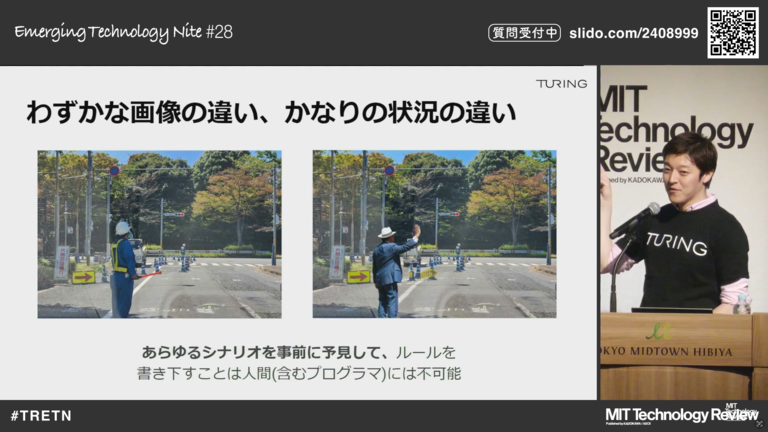

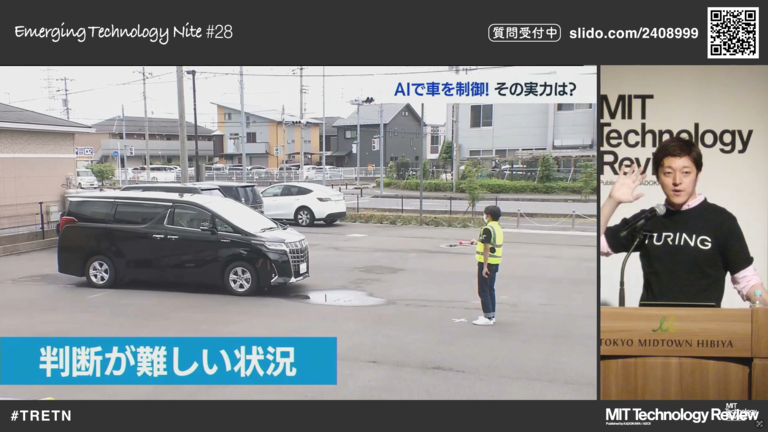

運転環境には非常にロングテールな事象が多いんですね。このロングテールとは英語でよく使う単語なんですが、縦軸が頻度よく起こるかどうかで、横軸が難しさです。例えば、左側の写真とかです。こういう普通によくある高速道は、頻度高く発生するし、簡単なんです。白線見て走ればいいだけです。一方で、右側の交通誘導員の写真を少し説明します。結構難しいんです。これ右側(下記写真)です。我々、運転者としてどうですか?行けそうですかね?多分行けるんですよね。

多分行けるんだけど、なんで行けるのか、ちゃんと見てあげるとですね、人間は、左側に黄色の矢印看板、工事現場があるなとか、交通誘導員が向こう向いちゃってるなとか、こっち見てくれないんだとか、でも赤い棒を持ってて、横に置いてるってことは、行っちゃいけないんだな、

奥にはカラーコーンがあるな、あれは避けた方がいいんだなとか、信号機は今赤だとか、いろんな具体的な情報を複合的に並べて考えるわけです。

左側の画像と右側の画像、どうですか? 左側はおそらく工事をしていて、この工事と交通誘導員は、おそらく独立ではない、なんか関連性がある。 右側の画像は、おじさんが手を挙げてるけど、このおじさん一見意味不明なんですよね。 タクシーを待っているのか、人を呼んでいるのか、多分工事とは独立しているかな、帽子かぶってるし、ちょっとおしゃれだし。 これ実はルールベースの自動運転車だと全然無理なんです。 人がいます・人を避けないといけません・奥に工事現場があります。 それくらいしか分からない。 それでは、自動運転車って公道に出てこれないんですよね。 だからこそ今私たちが外に出て、これから帰宅しますと言ったときに、タクシーに乗るか、もしくは電車に乗るかで、自動運転車に乗って帰ることはできないわけです。

それは、こういうロングテールな事情をうまくマネジメントする、世界を理解しているAIが今ここにないからです。

これを作らなければいけない。

我々チューリング株式会社は、AI一発でと言っていますが、すぐ自動運転AIがパッとできるわけではなくて、

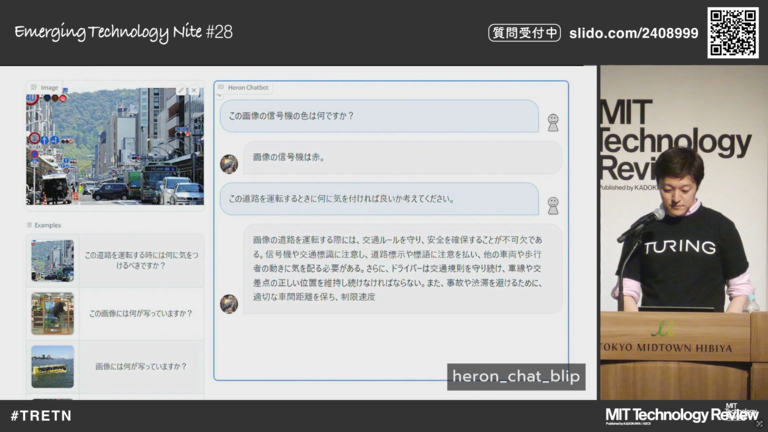

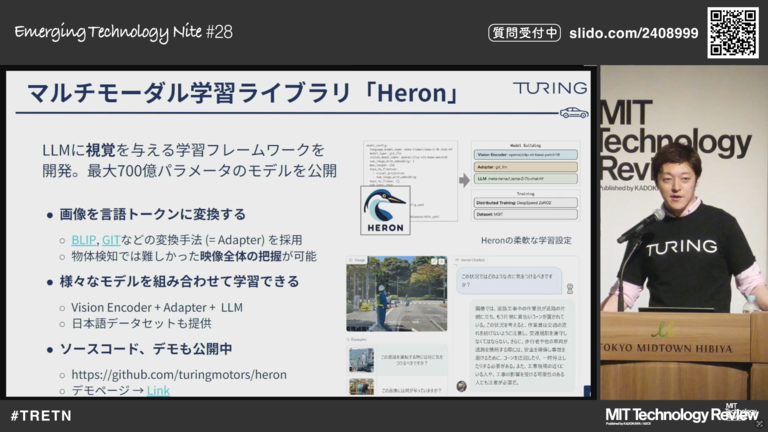

いわゆる生成AIをマルチモーダルAIというものにまず拡張をしました。

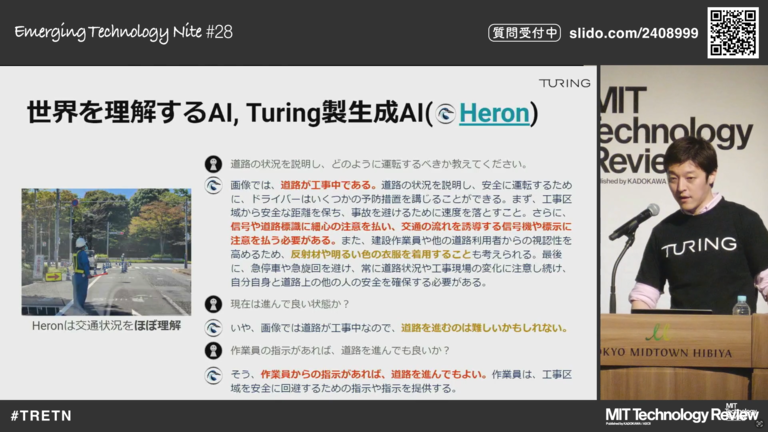

これは、何をやっているかというと、左側に画像を入れて、右側に文章を入れると何が起こっているかを教えてくれます。

この「Heron」というものを作ってですね、これ遊べるので後でチューリングHeronで検索してみてください。

自分で画像を入れて文章を入れると、猫の画像を入れて、この猫どうですか、何色ですかとか聞いたら教えてくれるし、この画像って面白いですか、面白いところ教えてくださいと聞くと出てきます。

話をもどすと、このスライド何しているかというと、「道路状況を教えてください」と打つとですね、この赤文字のところを拾って、「今工事中です。工事してて後ろに信号機があったり、交通誘導員もいるので、交通誘導員の指示に従いながら安全に行々しましょう」かつ「反射材を着ている人がいるので、彼の指示に従いましょう」と言ってくれます。

「今進んでいいですか」と聞くと、「進むのは難しいです。

なぜなら赤信号だし、作業着を着ている交通誘導員は向こうを向いていて、コミュニケーションできていないから」と答えてくれるわけですね。

これくらいの高度なコンテキストを理解できないと自動運転車は、実際に走れないんですよね。というか自動車を運転できないんです。

もう一つ大切なことは、我々のHeronを使って、重要な知識を自動運転車が獲得しつつある点です。

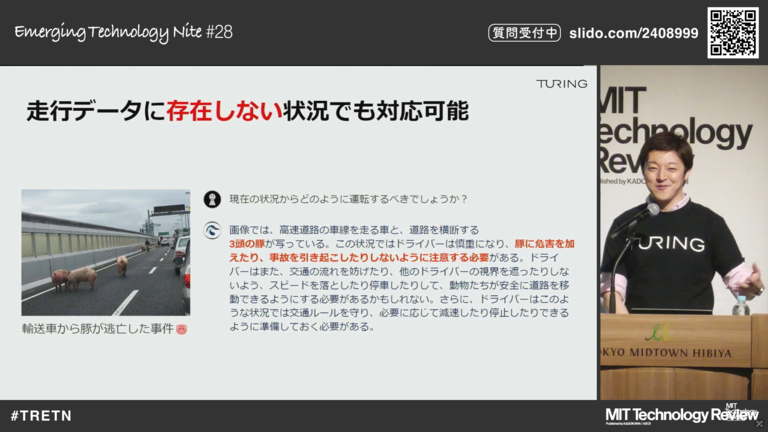

左側の画像は、豚が高速道路に逃げ出している。日本での状況です。

これ多分我々の中で、今ここにいる空間の中で、これ見たことある人はいないと思うんですよね。多分一人か二人いるとしても、これってどうですかね。豚がいます。高速道路です。

これルールベースでエンジニアが想像して書けますかね。書けないですよね。

データベースに豚の写真を入れておいて、豚と適合して豚をどう避けるか、ルールで書いていくんですか。多分書かないですよね。

でも人間ってこれ見て笑っちゃうかもしれないけれど、なんとかできるわけです。

Heronは、何を言っているかというと、この豚の画像を上げて、これどう運転すべきですかと入力すると、「3匹の豚がいます。彼らは逃げ出していますが、この豚に危害を加えないように、前の車両についてゆっくり徐行してくださいと」それくらい言ってくれるわけですね。

これくらいの知識を獲得している。すでにこの生成AIベースの自動運転車というのを獲得していて、こういうロングテールに発生する事象もマネジメントすることができています。

これ別に今までの自動運転車、いわゆる今回2.0というふうに言っていますが、1.0の人たちがアホやねんという話ではないです。

私自身も1.0やってましたから、そんなこと言えなくてですね…

これ実は2.0とぐちゃぐちゃになっちゃうんで、第3世代というふうに呼んでいます。

これですね、世界的にも自動運転って15年くらい皆さん研究してて、人類のたくさんのお金とたくさんの知識と、たくさんの人間が力を尽くして自動運転の実現を目指していますが、3つの大きな潮流があると言われています。

左側から年代ごとに直していくと、第1世代が2012年くらいからのCNN、いわゆるニューラルネットワークが出てきた時ですね。

なんかニューラルネットワークって最近の技術のように見えて、もう10年くらい前なんですね。

第1世代の時何ができたかというと、なんかバウンディングボックスというものが出てきて、これ信号機ですとか、人ですとか、猫ですと、いわゆるニューラルネットワーク、つまり人工知能によって認識できるようになりました。

なので「この認識機能を使えば自動運転ができるんじゃないの?」と言って、わーっと投資が集まったけれどもできない。

アメリカとか中国とかで、たくさんの自動運転スタートアップができて、たくさん潰れました。

それでもいくつかは残り、いくつかはすごく強く残っています。

残る企業はやはり強いと感じます。第2世代になるとですね、ここに構成マップ、いわゆる地図にたくさんの情報を詰め込んで、それで走れるんじゃないの?例えば、停止標識、信号機の情報、もしくは交通規制の標識、速度制限などいろんな情報を構成マップに落とし込めば、いけるんじゃないの?というのが2018〜19年くらいから、第2世代の自動運転車として登場しました。

この技術は、倉庫内などで非常に役立ちました。今アリババとか、アマゾンの倉庫って、もう人間が手を加えずに、自動ロボットが物を動かしたり、物体を運んだりしてくれています。

倉庫内では、このような地図に情報を集約し、それに基づいて航行することが可能です。

しかし、公道での運用は難しいのです。

なぜかというと、私は最近これを「人間の不可測性」と呼んでいます。

人間の行動をすべて予測するのは非常に難しいのです。AIならできるかもしれませんが。

それをエンジニアとか地図側で全部マネジメントするのは、全然できないんです。

だって今私がここで急に踊り始めるかもしれないし、おばあちゃんが道路上で転ぶかもしれない。それを全部地図上に入れていくというのは到底無理な話だし、

もしかしたら、交通誘導員のお兄さんとか、お姉さんとかが急にコーンを立てて、ここ入れませんとするかもしれない。

人間はここ入れませんと言われてコーンを置かれたらちゃんと避けて走ってくれるんだけれども、クラウド側をどういうふうに更新していきますか。

それは本当に真の情報かどうかを考えていくと、日本の公道の情報を高精度マップにすべて入れるのは難しいのです。

というところでちょっと下火になってきました。

一方で第3世代、いわゆるLLMや生成AIというのが2023年の年初に出てきて、ここで自動運転の研究そのものが大きく変わりました。

Heronもいくつか論文投稿や国際論文も発表してますが、この新しいアプローチでは、言語を介した応答と、AIそのものが何かを認識するとかですね、

何か一つのモジュールをAIが担うのではなくて、全部一括でAIが運転の行動の決定までしてくれるというシステムが、

この第3世代で現れてきた新しい自動運転システムです。

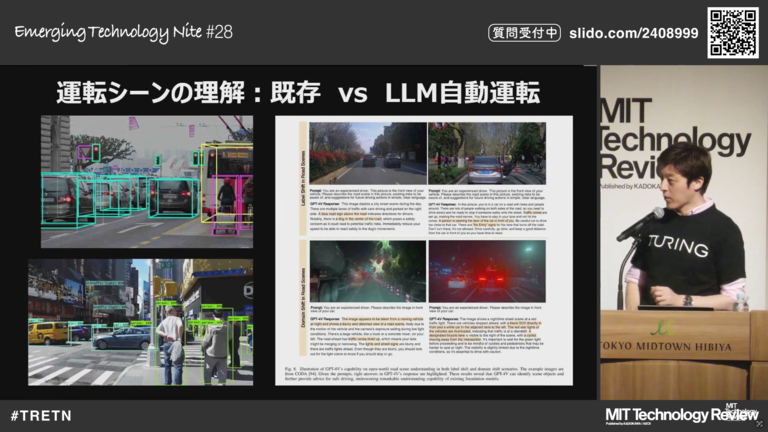

左側は、第1世代、第2世代の自動運転車のいわゆるよくあるデモ動画です。我々もなんか見たことあるかもしれません。人や車・信号機が見えていて、

「これは何パーセント猫です」「何パーセント犬です」という情報が表示されています。

数年前まで自動運転系の学会や研究会では、こういうのをたくさん発表していたんですけど、現在の論文を見ると、こんな感じになっています。

これ結構面白くて、上側に画像を張りつけて、キャプションのところに文章、我々の先程のクエリみたいなものを打つと、そのAIがどんな回答してくれましたかというのを、我々のチューリングだったらHeronを使い、テスラだったらこれを出します。

というのをやっていて、ここの戦いになっているのが今の状況です。

これが意外と使えてですね、例えば右下の画像をHeronに入れて、「あなたは自動運転者です。この画像どう思いますか」と尋ねると、「霧が出ています」とか「逆光になっています」とか「赤いコーンが並んでいるので、慎重に走ってください」などと答えてくれます。

こういう変化がLLMによって起きてきたのが、ここ2年くらいの自動運転業界です。

なので、左側のをやっている時は、いわゆるオペレーティングシステムとか組み込みシステムの人たちがめちゃくちゃいて、自動運転車の土台のところを作ってきた。しかし、今では、本当にラストワンピースのためにAI系の人たち、生成AI系とかGPUのクラスターを作る人たちとか、そういう人たちが自動運転業界にバツッと入ってきて、エンジニアリングをしているという状況になってきています。

自動車メーカーの方がいらっしゃるかもしれませんが、自動車業界は人の安全とすごく向き合ってきました。AIスタートアップとか自動運転スタートアップの人たちは、すごくリスペクトを置かなきゃいけない存在だと思っています。

多分人間の命にこれだけ向き合っていくプロダクトとかエンジニアリングは、今までなかったと思います。

車ってそれだけすごい製品だと思っています。

一方で、このLLMや生成AIが自動車の運転行動を決定するのは、非常に恐ろしいことなんです。

ただ、おそらく人間の性能を超えてくるのではないかと!

ここ2年ぐらいのAIの進展を見ていると、そう信じざるを得ないと思います。

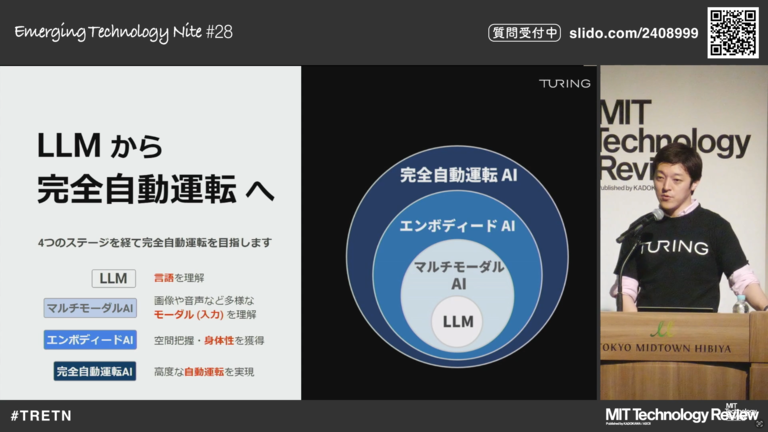

我々がLLMからどのように自動運転車まで持っていくかというと、2つのステップを踏む必要があると思っています。

まず、LLMから1つ大きく進化したのがマルチモーダルAIです。

LLMは、入力と出力が言語だったんですね。

皆さんもChatGPTとか使ったことあるかもしれませんが、言語で入れると言語で返ってくる。

一方でマルチモーダルAIというのは、入力が画像とか文章、音声などいろいろな入力に対して、適切な出力を出してくれるのがマルチモーダルAIです。

ここまでは我々もHeronを作ることで、達成することができました。

一方で、これからチャレンジしないとけないのはエンボディードAIと完全自動運転AIです。この2つかなと思っています。

エンボディードAIというと、まだ慣れ親しんでないかもしれませんが、実は身体性の獲得とか、物理空間をどう理解するかです。

AIは学習データのほとんどが画像や文章なんで、物理世界がどういうものなのか理解してないんですね。

例えば、ペットボトルは軽くて、車ってこれペットボトルが落ちてたら踏んだほうが安全なんですよ。ペットボトルとか枯葉が落ちてたら、避けるより踏んだほうが安全である。

一方でガラスとか鉄球が落ちてたら避けたほうがいい。

これって人間は、そういう知識を獲得しているんだけれども、AIってまだそういう知識を獲得できてないんですね。

ここを獲得しないといけないと思っています。

そこまでいけたら完全自動運転AIは、物理世界を理解することができたので、運転程度のタスクができるかなと思っています。

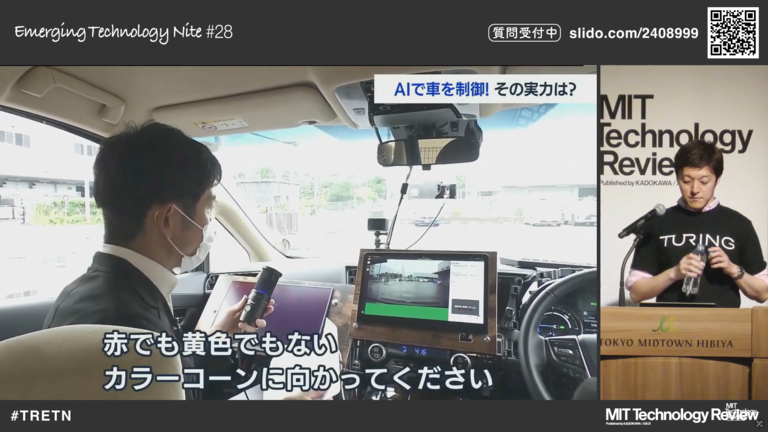

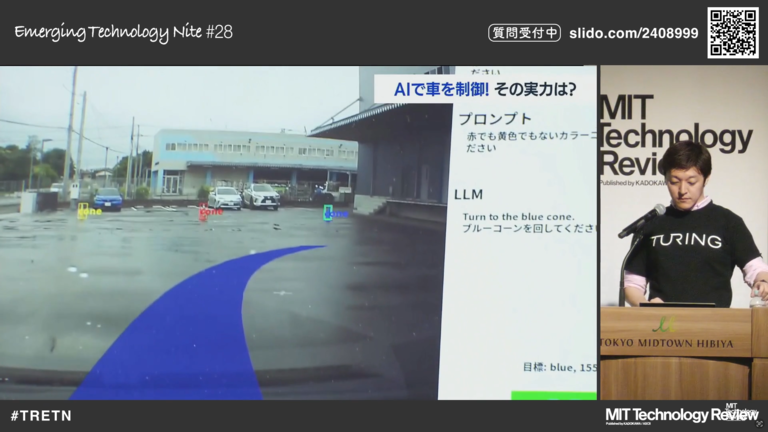

我々は、LLMで動く自動運転車を作っているので、会社の紹介を兼ねて見せたいと思います。

- 動画再生

(山本氏)

チューリングが作っている車には、GPUが入っています。

普通にPCで使われるGPUですね。

大規模な計算が可能なものです。

GPUは、この七色に光っている部分ですね。

(レポーター)

チューリングが、完全自動運転の実現のために開発しているのが、LLM、大規模言語モデルと呼ばれるAIです。対話型AI、ChatGPTにも使われている技術で、人間のように言葉を理解し、自然な会話ができるものです。

LLMと呼ばれるAIによる車の制御が、どんなものなのか、ちょっと敷地が狭かったので、3つのカラーコーンを置いて、そこに進むという、テストをしています。

カラーコーンは青、赤、黄色と並んでいるんですけれども、AIが通常の会話を認識するということで、ちょっとこんな指示を出してみます。

「赤でも黄色でもないカラーコンに向かってください。」

画面に青い矢印がちゃんと出ましたね、この青い矢印に向かって進んでいきます。

このように、人間の言葉をしっかり認識していることがよくわかります。

例えば、「交通誘導員に指示に従ってください」といった指示にも従います。AIがある程度の常識を獲得していれば、

このような、誘導員の指示に対応することができます。

(青木氏)

これですね、動画の中には答えが出てこないんですが、

こいつは、「人を殺すのは良くないので止まりましょう」といった答えを出してくれたりします。

なんか意外と人間っぽい回答をすることもあります。できていないこととしては、左側と右側が逆というのがわかっていないとか、前と後ろが逆というのがわかっていない。いわゆる身体性の話を先ほどしましたが、物理空間がどういうふうに動いているのか、今AIはわかっていません。

皆さんも赤ちゃんから成長して人間になり、人間として生まれて、人間として今育ち生きていると思います。

赤ちゃんって、いろいろなものを触ったり、口に入れたりとかして、物質の形状とか、これはなんか硬くて怖いんだなと、子供の時にいろいろなことを学んでいくわけです。

私たちもガラスは落としたら割れるとか、割れてそれを踏んじゃうとすごく痛いというのを、経験則によって獲得してきました。

多分大人になってガラスで手を切った人って、世の中にそんなにいないんじゃないですかね。成長していく中でそういうのを学んできた。

そういうところをしなきゃいけないかなというふうに思います。そして、この前と後ろが逆という話はですね、例えば、私から見て、右側に舞台がありますと、左側を見るとペットボトルがあります。

でもこれって実は対ではないんですよね。人間からしたら右と左で対なんだけれど、幾何学的に見たら全然対ではないんですよね。

私から見て左って本当は壁なんですが、左側にペットボトルがありますというのは真なわけです。

でも物理世界を理解していないAIからすると、これは偽なわけです。

これは結構難しいですが、これもチャレンジしていくポイントかなと思います。

- heronの動画再生

もう一つ、Vision LanguageのHeronというものを作っていて、

これ先ほど説明したのでカットしたいと思いますが、皆さんもデモとして使えるので遊んでみてください。

テキストによる入力・出力に対応していますが、Heronを使うことで画像の入力が可能となります。

学習済みの画像エンコーダと大規模言語モデルをつなぐアダプタを学習させることで、

単純な回答ではなく文脈を理解した自然な文章生成を実現しました。

世界で初めて最大約700億パラメータのモデル群と、最大規模の日本語の画像・テキスト・データセットを公開しました。

Heronは我々自身で作っていて700億パラメータです。これはめちゃくちゃすごそうに見えるのですが、とはいえ生成AIの世界では、億単位のパラメータは当たり前になってきていて、700億パラメータの中でどう勝負するか、もしくはさらに桁を上げて勝負するかという世界線になってきています。

ソースコードやデモ、テクニカルペーパーも公開していますので、もし興味がある方は見ていただけたらと思います。

これ結構、学習させるのも大変でですね、

AWSやGCPさんに、すごく支援をいただいているものの、普通に億単位の金が飛んでいきます。

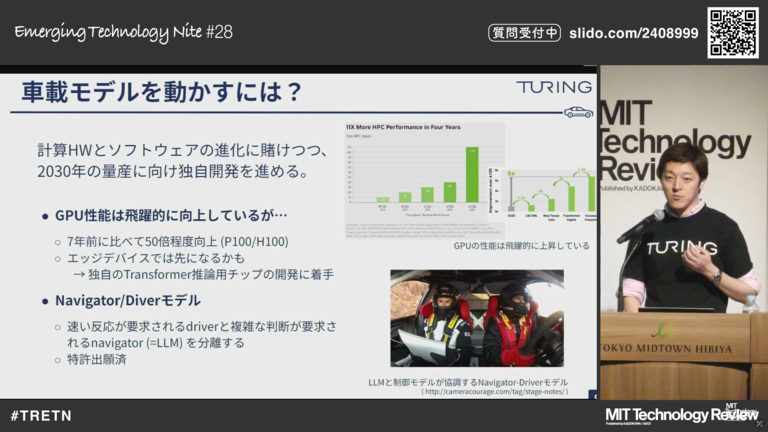

もう一つ難しいと思うところは、車載モデルにどう落とし込んでいくかという点です。

例えば、GPT-4や我々のHeronというのは、クラウドを使って動いているわけです。

学習のところにGPUがつかわれるのはもちろんのこと、推論を走らせるときにもすごくエネルギーと電源・計算基盤が必要です。

そこで、我々は2つの解を持っています。

結構難しいんですが、1つめの解は、車載に収まるようにちゃんと半導体まで作ることです。

もう1つの解が、「Navigator-Driverモデル」です。

ラリーカーを見たことがある人もいるかもしれませんが

ラリーカーでは、左側のナビゲーターが多くの情報を持っているんです。

他の車の位置、地図の詳細、自分たちのエネルギー残量、レースの残り時間、今アクセル踏むべきなのか踏まないべきなのか、どれくらいまで加速すべきなのかというのを頭を使っていろいろなことを考えているんです。

一方でドライバーは、今この瞬間目の前に起こっていることに対して、気づいて反射で対応していく。小石があるから避けるとかですね。左側に曲がると危ないから、右側に曲がっていくというのをやっていくわけです。

この中でナビゲーターというのは、自分で考えた後に言語でドライバーに情報を伝達します。

ドライバーは、目の前で起こっていることをプラスして、言語での入力に対してハンドル、アクセル、ブレーキの操作をしていく。

これはですね、実は自動運転業界でも活用することができます。例えば、ナビゲータ側をクラウド側に置き、ドライバー側は車の中に配置します。

これにより、安全の確保や目の前で起こっている事象を車内で完結して安全に航行することができる。

一方で、すごく複雑で難しいタスクが発生した時には、クラウド側で対応することができます。

私たちは、Navigator-Driverモデルの特許出願をしており、開発も進めています。この技術は、LLMや生成AIを自動車で活用する点で非常に画期的だと考えています。

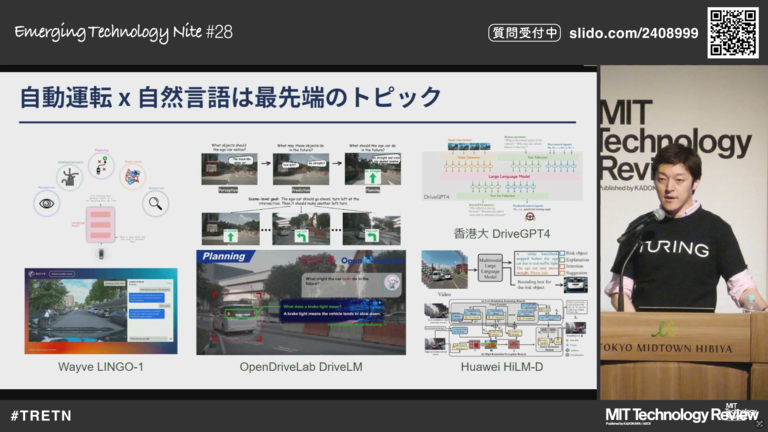

自然言語処理や生成AIは、自動運転の分野でも非常にホットな話題となっています。

我々チューリングもここに名乗りを挙げて、自動運転2.0の世界に飛び込んで戦っていますが、もちろんここのトッププレイヤーであるテスラが最も進んでいて、LLMの活用にもすごくオープンで動きが速いと感じています。

一方で、一番左側はウェイビー(Wayve)さんという、イギリスの会社です。

彼らも「AI一発で自動運転ができるぞ」というビジョンを掲げています。日本語の記事でも自動運転2.0ウェイビーと調べると情報が見つかります。マイクロソフトなどいくつかの企業からバックアップを受けて、自動運転2.0の領域にチャレンジをしています。

もう一つ恐ろしいというか、すごくいいのが、オープンドライブラボ(OpenDriveLab)です。中国の上海に拠点を構えていて、いろいろな会社から出資を受け、

アカデミアも巻き込んで、AI一発で自動運転システムを作ろうとしています。このように、中国からも大きな進展が見られます。

また、右側にあげた香港大とファーウェイ(HUAWEI)も中華系です。AI領域では、中華系のAI研究者、技術者が非常に多いです。私がアメリカにいたときも感じていました。

今、アメリカでトップを走っていた研究者が中国に戻り、オープンドライブラボやファーウェイ(HUAWEI)で活躍しています。「AI一発で作る自動運転車」を中国でも作っています。

一番最初の話に戻りますが、自動運転車が海外のものを使うしかないとなると、すごく恐ろしい世界だなと思います。だからこそ、我々も負けずに開発していきたいと思っています。

我々、学習戦略というふうに書いていますが、今最初にマルチモーダル学習というのを作って、Heronというのを作りました。

ここに対して、運転ドメインの知識とか情報を盛り込んでいくことによって、左側のほうにデータ源というふうに書いていますが、ここ自社でデータを取っています。

プラスして、実は最近S.RIDEのタクシーのほうにも、データキット取得キットを乗っけて、カメラとアクセルブレーキ値を取るデータ取得セットを乗っけて、データを取っています。

プラスして、オープンな文書とか画像とか動画とかっていうのも、他の生成AIと同じように学習のフレーバーとして加えていく。

最後に、実はこれ意外と受けるんですが、交通安全ガイドブックというのは、文章と絵が書いてあるガイドブックがあると思いますが、あれをそのままAIの学習に食わせてあげると、結構模範的な動きをしてくれるんですね。

人間も交通安全ガイドブックを読んで、それ通り従わないとかがあったりするので、実はAIのほうが安全なのではないか、私はちょっと思っていたりします。

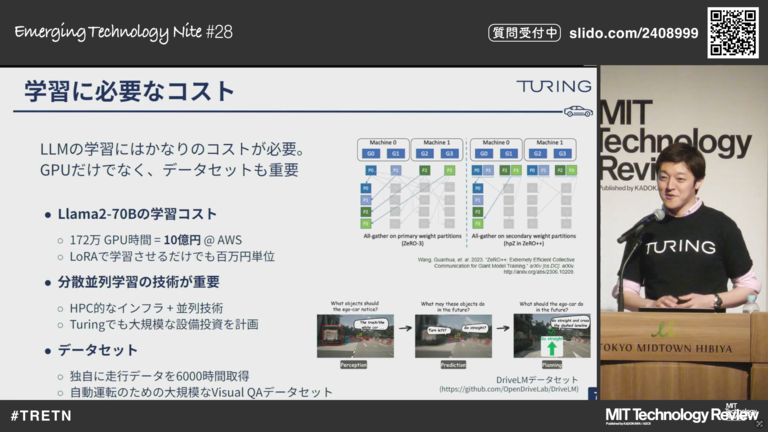

これもちろん、GPUめちゃくちゃ使います。

GPUといった生成AIのトレーニングとか、生成AIの作成、開発にものすごくGPUというものを使っていますので、

ここを実は経産省のGENIACプロジェクトに採択していただいて、支援を受けています。

このプロジェクトは、OpenAIのボスであるサム・アルトマン氏と岸田首相が会談し、「国産で生成AIを作らなければならない」ということでスタートしました。

ChatGPTが出てきて半年ぐらいでこの話が進み、公募が一年後ぐらいにすぐ出てくるという、かなりスピード感のあるプロジェクトです。真ん中に【東大の松尾先生】(https://weblab.t.u-tokyo.ac.jp/dt_team/matsuo/)・右側にプリファードネットワークスの岡野原さん、左側にチューリングを並べて、めちゃくちゃハロー効果を狙っています。

政府が選んだ生成AIを作れる7社の中に、チューリングも入ることができました。

ここでNVIDIAのH100を280機使わせていただいています。

また今回、資金調達も行いまた。主な用途として、自分たちでGPUクラスターを構築することに使っています。

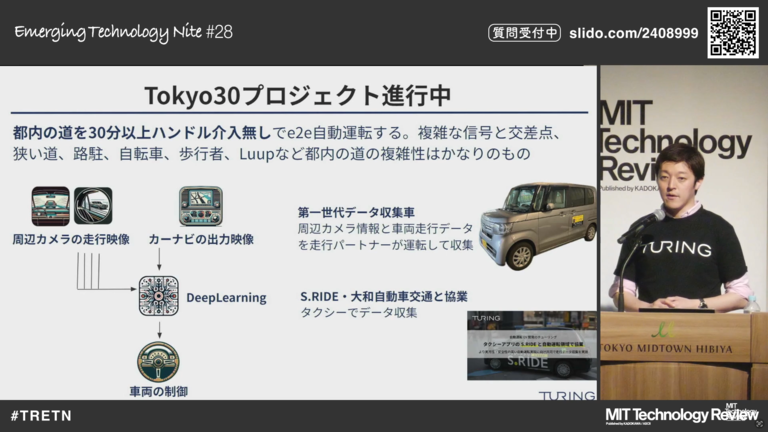

今プロジェクトとして、実証実験的に北海道、東京、千葉県で自動運転車を走らせました。

ただし、危険な時に人間の介入が必要でした。

危ない時に人間がオーバーライドして触るということをやってきました。

ただ、今回紹介したように、おそらく生成AIによって完全自動運転車は、ここから3年4年で勝負が決すると考えています。

そこで、なにかやらないといけないと考え、「Tokyo30」というプロジェクトをスタートさせて、都内の道を30分間、人間の介入なしで運転する自動運転システムを作っています。

このプロジェクトでは、信号機や交差点、狭い道、路駐している車、自転車、歩行車、LUUP(ループ)みたいな電動キックボードなどの安全を担保しながら、自動運転システムで走れることを示す必要があります。

これができるくらいの技術力が日本には眠っているはずで、それくらいのことをしないとテスラには敵わない。

彼らは非常に速く進んでいくので、このままでは置いていかれる可能性があり、このようなプロジェクトを立ち上げて進めています。

スポンサー企業も少しずつ増えてきていますので、もしご興味がある方はお声がけいただければと思います。

具体的に何をやっているかというと、カメラとカーナビの出力画像、つまり2つの画像を用いてディープラーニングによるAIの出力がそのまま車両を制御するということをやっています。このために、データ収集の車両を都内で走らせたり、S.RIDEさんと提携してデータを収集したりしています。

これについて、自動車メーカーや伝統的な企業の方からは、「都内で30分自動運転なんて恐ろしいことをよくやるな」と思われるかもしれませんが、スタートアップは、基本的にリスクを取らなきゃいけないのです。

もう一つ隠された事実、みんなが口に出さない事実として、ToyotaやHondaって潰しちゃダメなんですよ。めちゃくちゃ食ってる人がいて、めちゃくちゃそれで生きてる人がいる。潰しちゃダメなんです。

スタートアップはたくさんの挑戦を行い、失敗するリスクを覚悟しなければなりません。成功するためには、失敗のリスクも追わなければならないのです。そうした中でチューリングは、いわゆる長崎の出島で新しい政策や海外との協議を試していた江戸時代の江戸幕府のように、出島的な役割を果たせる場として使っていただきたいと思っています。我々は自動運転車で業界をガツッと破壊するつもりはありません。この先、業界が変わっても日本車が海外で売れるようにするためのソフトウェアを作っています。もし興味がある方は、チューリングと一緒に取り組みましょう。また、そろそろゴールデンウィークで転職先を探している方がいれば、お声掛けいただければと思います。

これは経産省の資料を元に作っています。左側が今ある自動車メーカー、OEMがあり、T1サプライヤーがあり、部品を作る会社さんがあり、その部品の部品を作る会社さんがある。自動車は、すごく巨大な産業構造を持つ業界でした。

一方で今、ファーウェイやテスラ、グーグルのアンドロイドオートのようなソフトウェア企業が急速に現れ、自動車産業に大きな変革をもたらしています。

このような状況の中で、我々も日本においてこうした武器を持っておかなければならないと考えています。

たぶん業界が変わると思っています。

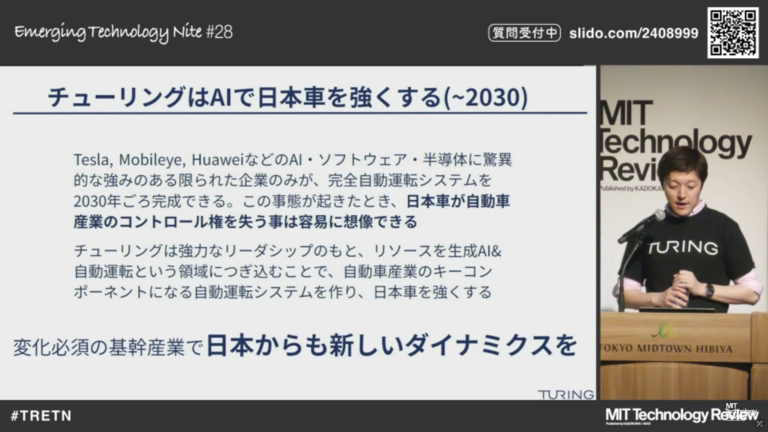

海外では、テスラやモービルアイ、ファーウェイなどがソフトウェア分野で強みを持っていますが、我々はパソコンやiPhoneで起きたことをもう一度繰り返したいわけではありません。

日本はハードウェアに強い国であり、外貨も稼ぐことができます。そこで、技術力と製造力を活かしながら、ソフトウェアでパワーアップしていくことが、我々の目指す未来だと考えています。

我々は自動車とソフトウェアの分野で戦っていきます。もし今回の話に興味がある方がいれば、ぜひお声掛けいただきたいと思います。自動運転システムを作ることは非常に魅力的なキャリアだと思いますので、興味のある方はぜひご連絡ください。

最後にまとめですが、今日は生成AIやLLMが自動運転にいかに必要であり、これがないと自動運転システムが最後のゴール地点まで行けないことを紹介しました。

「自動運転2.0」というタイトルを付けていますが、実際に自動運転2.0が始まったのは2023年とか22年です。

生成AIが出てきて、用意ドンで走り始め、業界がガラッと変わりはじめています。面白いポイントだと思います。

また、左側に記載しているチューリングのテックブログでは、車をどのように改造して自動運転化したかや、生成AIをどのように作ったかについても紹介しています。

なぜかというと、生成AIを日本で作ったことある人はほとんどいないんです。

OpenAIやテスラなどがアメリカで作っているため、内部情報があまり流れてこない中で、我々はGENIACに採択され、東大の松尾研やABEJAさんと共にコミュニティを形成し、その情報をテックブログで発信しています。興味がある方はぜひご覧ください。

今回、プレシリーズで資金調達をしていますが、まだまだ序盤です。今後も来月、再来月とニュースが出てくる予定です

ぜひ、我々チューリング、完全自動運転に向けて開発を進める企業を応援していただければと思います。

ちょっと短いですが、短くないな。今日は約50分間お話させていただきました。

ありがとうございました。

質疑応答

- 司会

続いては質疑応答の時間です。事前にいただいた質問、会場からの質問、そしてスライドからの質問にお答えいたします。オンラインでご参加の方は、画面のQRコードから質問を投稿できますので、ぜひご参加ください。

では、最初の質問に移ります。マイクをお持ちします。そちらの女性の方、お願いいたします。。

Q1

- Q1

生成AIがイラスト生成やキャッチコピー作成など、エンターテイメントに使われている例はよく見ていましたが、人の命を預かるような領域でも活用されるという点にまず衝撃を受け、面白いと思いました。

一点質問があります。学習データに交通安全ガイドブックを使われたという話ですが、交通安全ガイドブックが常に正しいわけではありません。例えば、法定速度を守ることが書かれていますが、実際には40キロの道を周りが50キロで走っているときに50キロで走った方が事故を起こしにくいなど、周りの状況を読むことが重要な場合があります。生成AIはそのような「空気を読む」ということも常識力で実現できると考えられていますか?

- A1

ありがとうございます。

基本的には、一番最初のエンターテイメントの話からすると、コンピューターや計算機は人間のタスクを全て代行するために作られてきました。最初はNASAの宇宙軌道やロケット軌道の計算から始まり、会計ソフトやアプリケーションも、人間が「これをやるの?」というようなタスクを全て代行してくれるようになっています。

実は運転のタスクも代行してもらった方が絶対に良いはずです。多くの人が運転していますが、人間が悪意なく他人を傷つける可能性のある工業製品は非常に危険です。例えば、21世紀の2024年に車がない世界があり、皆が歩いて移動しているとします。その時に「車は年間数千人を死なせるが使うか?」と問われたら、社会的合意は微妙でしょう。「これ、本当に使うの?」と思うはずです。

現在の車は歴史的な経緯で使われていますが、人間が運転するよりもAIが運転する方が事故が少なくなるのであれば、そのタスクをAIに任せる方が公正だと思います。例えば、80歳や90歳、さらには100歳を超える人がタクシーを運転するのは、やはり少し怖いと感じます。

安全性の問題だけでなく、納得感をどう醸成するかも課題だと思います。10年前にはAIに仕事を奪われることを心配していましたが、現在ではGPT-4やGeminiが登場し、法律や医療の知識において私たちよりも賢いですし、アイデアを出す際にも自分より優れたアイデアを提示してくれることがあります。部分的には既にAIに負けており、新しい技術に対して人間は意外と対応できていると感じます。

質問に戻りますが、エンターテイメントは単純に入りやすい分野であり、車の運転だけでなく医療や政治的判断などにもAIが進出する可能性は十分にあります。

もう一つの質問に関して、ガイドブックを学習データとして使うと官僚の人々は納得しますが、人間にはグレーな判断が必要な場面があります。例えば、右折禁止だけれど右折しないと駐車場に入れない場合や、田舎道で車を避ける状況などです。人間が運転したデータは重要であり、AIを強化するためには、きれいで多様性があり、大規模なデータセットが必要です。

テスラの例では、データセットがきれいに見えても、実際にはストップサインを無視するケースが多く、それが問題を引き起こしています。きれいなデータセットを用意することが非常に重要です。

少し話が長くなりましたが、以上です。

-

(Q1続き)

ありがとうございますきれいなデータセットをどう用意するかってなったときにデータセットを全部人間がチェックして分けるっていう方法しかないないとすると大変だなって。 -

(A1続き)

データクレンジングとかもちろんやる一方である程度汚いデータを弾くとかっていうこともプログラムでやっていったりします。

ちょっと前は例えば信号機のラベリングをしますって言ったときにカチカチ人がやってくっていうのがあったのが、最近はオートラベリングっていう技術だとラベリングもしくはアノテーションを全部自動化してくれますよ。っていうのも出てきていたりするのでそういう周辺技術も意外と出てきたりしてますね。 -

司会

ありがとうございますご質問ありがとうございます次はWebの方に行ってみましょうか。 -

(青木CTO)

一旦一番上行ってみますか。

Q2

-

Q2

生成AIをどのように制御して活用しているのでしょうかということなんですけど。 -

A2

基本的にはでっかいAIニューラルネットワークを作ってそれで自動運転するのが我々の基本思想ですなんで、生成AIを活用するというよりも生成AIの延長線上に自動運転AIがあってそれをどう作っていくか。

でも生成AIっていう名前がついたのはすごくよくて、人間がやってることって外の動画とか音声とかの情報をインプットして、頭で考えてアクセル踏むかブレーキ踏むかハンドル回すかなんですよね。

この三つのアウトプットをどう出していくかなんで、ここを行動生成AIとかっていうと何かちょっとそんな単語作ってるんであれなんですけど、落とし込んでいくと生成AIを活用して制御してというよりも生成AIの延長線上にあるものを、自分たちで作っていくという方が正しい回答かなというふうに思います。 -

(司会)

ありがとうございます。

行動生成AIかっこいいですね。 -

(A2続き)

そうですねただAIが絵を生成できてゲームのプレイも生成できて文章も生成できる。

多分行動もできると思います。 -

(司会)

ありがとうございます。

じゃあここでまた会場に戻って白いシャツの方お願いいたします。

Q3

-

Q3

本当にありがとうございました。

この3、4年で勝負が決するんじゃないかとおっしゃってたと思うんですけど、勝負が決するという時のクライエテリアというかそういうものを教えていただきたいのと、

その時に御社がどのように今エンボディードAIを目指されていて

、その後完全自動運転AIを目指されていると思うんですけど、そこまで勝負が決するのは完全自動AIなのかそこまでの課題とかも教えていただけたらと思います。 -

A3

ありがとうございます。

これなんでそう言ってるかというとAIが出てきて、ニューラルネットワークとかトランスフォーマーが出てきたのはやっぱり大きい流れだったんですよね。

2012年とかにニューラルネットワークが出てきてそれまでって

画像では例えばエッジ検出とか熊のぬいぐるみを認識するのも結構難しい。

そういうのをやってたのが、言ってしまうとディープでポン、ディープラーニングでポンと出てきましたとかというのが始まってきて、それが2012年ぐらい囲碁とか将棋でうちのCEOのPonanzaとか囲碁だとイ・セドルさんをGoogleのディープマインドが倒したというのが2016年。

あの時も何か囲碁とか将棋でもう勝てるんだって思ったら、あっという間にゲームをできましたとかEスポーツの、例えばF1のレーシングとかももう人間よりAIが強いですってなってきて、今年、去年、おととしくらいから文章、絵、明らかに人間よりも優れたものが出てきている。

なんかこの創発とかって呼んだりするんですがこの創発のタイミングとか、ぶち抜かれる時間軸のギャップがどんどん短くなってるんですね。

なんかSoraっていう動画生成AIも今年の1月か2月に出てきたと思います。

あれも実はGPT-4出てきた時にはいや、なんか動画はできないよってみんな言ってたんですよ。

でもそれをいわゆる創発というかなんか思ったより短い期間でバツッと抜けていくっていうのが起きていて、ここ2年間の社会変革を観察してこれから2年間とかって見ていくともっと短いスパンでなんかこう新しいものが出てくるっていう未来は確実にあるんじゃないかなと思っています。

一方でネックになるというか我々に対して逆風になり得ることとしては、いや意外と生成AI面白いけど金にならんなって思い始める可能性が1つある。

なんかGPTもそうだし絵を描くAIもそうだしなんか面白くて可能性がありそうなんだけど、実際なんか産業になるかとかなんか価値をどうバリューとして出していくかっていうと、なんか面白いだけで終わって数年間経っちゃうっていう可能性はあると思います。

あともう一つは今回車とかっていう話をしてますが基本的には生成AIとかってクラウドでバッツリ計算量計算資源持って動かしていくわけで、これをいわゆるエッジ側、まあ車だったりとか飛行機だったりとかモバイル端末だったりそっち側で動かした時にどれだけ性能を出せるかっていうところはすごく大きな勝負になるかなと思ってます。

なんかサチるとしたらもう計算基盤がめちゃくちゃでかくないとどうにもならないとか、電力量足りませんよってなってくるとかっていうのはあると思います。

ってところが技術的にかつ社会的に厳しいものがありそうポイントですかね。 -

司会

ありがとうございました。 -

司会

また会場で聞きたい方手上がったんであちらの方お願いいたします。

Q4

-

Q4

本日は貴重なお話をありがとうございました近くの会社でセキュリティ関係の仕事をしています。

お伺いしたい点が2点ありまして一つ目が飛行機とか車に置くには、容量とか計算機資源がという話があったんですが、日本の労働力の不足が特に大きいのは海運業界だという話があり、船ならば電源もあるし通信手段も設置できれば、実はこの技術って船にも使えるのではなかろうかと思うんですがそのあたりお気持ちを伺えればというのと、

もう一つ日本でも交通ルールとか標識が大幅に変わる時期っていうのがあって、例えば横断歩道って今と昔では乗り方が違っていたりですとか沖縄での占領化で右側通行だったものが、左側通行に一晩で変わったということがありAIの学習内容の修正ってなかなか手間がかかるんですけど、そういったルールの変化にうまく対応していくにはどういう工夫をされているかこの2点をお伺いできればと思います。 -

A4

ありがとうございます。

海運は普通に面白いと思いますよ。

私は結構海も空も好きなので自動運転を自分のテーマとして選べたというか、面白いなと思ったのはめちゃくちゃ車が好きなわけじゃ実はなくてですね。

皆さん多分研究とか技術をやっていた時にモチベーションって大事だと思うんですよね。

言い方あれですけど誰がこれで幸せになるって議論しなくてもこれで幸せな人めちゃくちゃいっぱいいるし、これで幸せにならないって思う人逆にいるのって思ったのはテーマ選定というかすごい幸せな出会いだったかなと思います。

なんで車にこだわっているわけでは全然なくて、ただ一方で人の命とか生活っていうのを考えると車って工業製品の中でもすごく人との生活に密接に関わっててここは面白いなと思っているポイントです。

海とか船に関しては機会があってかつ我々の技術がちゃんと使えるんであれば、もちろん進出したいとは思っていますし面白いポイントじゃないかなと思っています。

ちょっと私はあんまり詳しくないですが多分人間の不覚実性とか

他の物体に関しての外的な要因とのインタラクションという点では、車より簡単かなと思う反面、波はめちゃくちゃむずそうだなとかは思っています。

それが1個目ですねなので機会があればすごく海にも挑戦したいなと思っています。

2個目の交通ルールだったり道路環境の変化ですね。ここは新しくデータは取らなきゃダメだと思います。

なぜかというと人間でも結構難しいですよね。

我々も車例えば日本で乗っています。

上手ですって言った人が急にインド行きますとかアメリカ行きますとか中国行きますって言って、パッと空港で借りれるかというとちょっと不安じゃないですか。

なんでかというと例えば車間の詰め方がちょっと違うとか交通ルール自体は一緒なんだけど、文化が違うとかここ曲がるんだったらみんなそうしてるんだとかっていうのが結構あったりして心配なんですよね。

純粋に私は結構海外生活が長くて思ってたんですけど、アメリカのほうが明らかに運転が簡単でだからこそテスラってすごくいいなと思っています。

日本だと運転むずいんだよなとか思ってたりします。

話を戻すと本当に横断歩道がガツッと変わりますとか道路仕様が変わりますって言うんであれば、ある程度追加の学習データは必要だと思います。

チューリングが日本で自動運転システムを作る意義という話をしていますが、アメリカで自動運転ができたからそれをそのまま持ってきて日本でできますっていうとそうでもなくて、iPhoneってそのまま持ってきちゃえばできるんですけど車の運転ってちょっと違うので。

そこをちゃんとデータを取らなきゃいけないし日本の交通文化に合わせたものは作らなきゃいけないかなというふうに思います。 -

(Q4続き)

わかりましたありがとうございます。 -

司会

ありがとうございました。

一旦こちら行きましょうか。

これ2つ目ちょっと行ってみましょうか。せっかくいいねがいっぱいついてるので。

Q5

-

Q5

TESLAのFSDと、TURINGが使っている(もしくは作ろうとしている)完全自動運転システムの違いを教えて欲しいです。

TESLAのFSDが大量データを気合いで学習したシンプルなシンプルな大規模言語モデルにすると、

TURINGの完全自動運転システムはdriver/navigatorモデルみたいな感じですか? -

A5

これよく言われるんですよテスラより優れてるとこあるんですかって言われるんですけどこれはないですよ。

普通に考えたら、だってすごいもん普通に会社として、忘れちゃいけないのはなんか自分たちがグーグルみたいなシステムを作りたいとか、アップルみたいな会社を作りたいと言ったときにいやアップルよりわれわれはすごいですよっていうのは、私はそれは嘘だと思うんですよ。

私たちがテスラに勝ってるっていうのは明らかに嘘だと思います。

だって車もめちゃくちゃ売ってるしむちゃくちゃ批判されてるけど、彼らはただ一方でちゃんと作ってちゃんと売って事故は起こしてるかもしれないけど。

売っているで自動運転システムに関しても明らかに世界一のクオリティを出してる。

なんかテスラよりすごいですよっていうのはなんかちょっと良くないなと思っています。

ただ一方で生成AIっていうものが出てきたのが2023年とかで用意ドンで始まりました。

ここで戦う意味はあると思うし全然負けてますっていうわけではない。

なんでそれを言えるかというと、自動車って結構国のバックグラウンドとかとすごくひもづきがあって、国防とかにも関係あるからかも知れないんですが国防とかと感情ですね。

なんかアメリカ行ってすごく感じたのが韓国人は韓国車乗るんですよね。日本人は日本車めっちゃ安全だし安いし乗るぜって言って絶対乗るんですけど。中国人も頑張って中国車に乗ろうと言ってるんですね。インド系はインド系でインド系の車はないんでアジア系の車に乗るとかってのがあって、意外と感情とひもづいてるとこがあって日本も外車って、実は3%とか4%しかなくて、一方でじゃあ韓国に旅行に行くと日本車結構見ないんですよね。

って言ったときに車が独占的寡占的な状態になるっていうのはほとんどないと思ってます。

トヨタも実は世界でいうと20%とか25%ぐらいのシェアで世界一の台数出してるので。

というところはディフというか差分というか戦って生きていく道かなというふうに思っています。

後半のほうの[TESLAのFSDが大量データを気合いで学習したシンプルなシンプルな大規模言語モデルにすると…]

まだ大規模言語モデル入れてないと思いますね。入れてないけど入れてくると思いますっていう感じですかね。

Q6

-

Q6

安全性や、品質を担保する方法や手段はどのように考えていますでしょうか? -

(青木CTO)

3つ目の安全性や品質を担保する方法や手段はどのように考えていますか。

安全性は。これはどっちの安全だろうシステムの安全性。 -

(司会)

どっちでしょうねこれだと両方捉えられますね。

どちらで答えましょう。 -

A6

多分自動車業界っぽい質問なので(車の安全性として)話しておくと。

安全性とか品質の話ってこれは普通に自動車業界ってここ2年間入ってみて、チューリングは日本でしかできない挑戦だったかなと思います。

なぜかというと品質とか安全性に関して、めちゃくちゃ考えているエンジニアがいるかつ自動車業界がそこにあるんですよ。

この会社このチャレンジってマレーシアとかスペインじゃ全然できなかったんですよね。

車作って自動運転車やりますって言った時に、いやいやお前らって言いながら手伝ってくる人たちがたくさんいて。

それはすごく日本のいい立ち位置で戦えたかなと思っています。

安全とか品質って実は考えてくれる人というか考えられる人は日本には実は人材たくさんいるので。

ここは実は日本の強みなのではというふうにすら思っています。

確かにだから考えてくれる人たちで組んでいけばその安全面というのは、担保というかあともう一つ期待値調整っていうのは必要かなと思っていて。

人間って安全だけ考え始めると安全とか、例えば100%ゼロ事故になりますかとかっていう議論を何もない状態ですると議論って全然収まらないんですよ。

だって飛行機だって電車だってエレベーターだって事故起こしていて、想定外の話を机上の空論でし始めたら全然意味ないんですよね。

日本もそれは悪いとこでもあり80くらい悪いとこ20くらいいいとこかなと思っていて、一方でアメリカの悪いとこっていうのは自動運転っぽいのができたからやってみようぜ。 実装してみてうわーうわー事故ったわーって言ってデータ見てみたら、モニターする人がポテトチップスくって映画見ててみたいな、全然やってくれてなかったみたいな。

私その時ちょうどアメリカ行って事故の検証の電話とかかかってきて、自動運転の人間としてどう思いますかとか、話をしてたんですけどアメリカってすごい速いなって思う反面、日本人がちゃんと自動運転車を受け入れて使えるっていう状態は、多分世界よりはちょっと遅いぐらいじゃないかなと思います。 -

司会

ありがとうございます一旦会場に戻ってみましょうか会場で質問がある方いらっしゃいますか。

ではそちらの4列目のお願いいたします。

Q7

-

Q7

お話ありがとうございました。

僕はエンジニアをしててちょっとそういう生成AI関連の話を聞ければなと思っているんですけども、率直にお伺いしたいんですけども、実際にハンドルだったりドライバーがいないような車まで作れることは可能でしょうか。

なぜ僕がこう思ったかっていうとどうしても生成AIだったりシステムっていうのはインプットと、最終的に出てくるアウトプットがあってそこに生まれる少しの時間がどうしても発生するものかなと思っています。

その速度っていうのはどんどん技術が上がっていって変わっていくとは思うんですけども、例えば自動運転ってなった時に例えば100キロ出してた時に急にちっちゃい女の子が出てきたという時に判断するまでの時間って、人間でも難しいのにどこまでAIで安全性みたいなところが担保できるのかなっていうのを、含めて今後どこまでいけるのかなっていうのを、どうお考えしているかっていうのをお伺いしたいなと思いました。 -

A7

一旦チューリングができるかどうかというのを私ができるかというのを置いておいて、人類はできると思います。

なぜかというと100年後200年後にまだ人類が運転してるって未来あるんですかね。だっていや結構やばいですよ。結構やばいですっていうのはそこにリスクとって運転したいですかっていう考えると。

普通に100年後絶対できるんじゃないって思っていますし、ちょっと外れちゃうんですけど、割と人間って実現したい技術があってそこまでの要素技術とか、なんとなく見えてくるものってたぶん作れると私は思っていて、逆に作れないのはタイムマシンみたいな要素何もわからんみたいなものは、全然無理だと思うんですけど自動運転ってもう結構要素見えてきてると思うんですよね。

あとはたぶん必要な今言ってた話で言うとちゃんとその安全性が担保できるのかどうか、それと担保させるシステムを作るかっていうところと、あとは納得感をどう作るかっていうとこまで

もう落とし込めてきているわけでここはそこまで見えてるんだったら200年かけてできないっていうことは絶対ないと思います。

もう一つこれ自動運転に関して大切な話としては女の子が飛び出してきてっていう話って、それ人間にできるんですかっていうところは非常に気にしなきゃいけないと思っていて、

人間にできないことを、これねたぶん最初のところはAIとか自動運転がパッと出てきた時に人間にできないことを、AIが失敗した時にたぶんちょっと批判が出ると思うんですよね。

意外と人間ができないミスに対して人間に対してのミスより人間のミスよりAIのミスの方に対して人間って結構きつい反応するんだなと思っています。

ただ一方で人間がめちゃくちゃ意味不明なミスをしている中で

AIの方がいいですよっていうのがデータとして出てきた時にそれは人間は普通にいろんなことを言いながら使うんじゃないかなと思っていて、これはね議論が分かれるところなんですけど、これ私の観察とエスパーと妄想だと思ってください。

別に私生成AIとか絵を作るとかお小遣い稼ぎは全然したことないんですね。

一方で生成AIが出てきました。モデルさんとか絵の仕事がちょっと減ってきた時に、人間って左手では著作権の話とモデルの話をするんですよモデルの仕事がないとか、著作権の問題があるとかって話をうわーっとしながら、実は右手では小遣い稼ぎのことを考えてるんですよ。

これ結構なんか人間小ざかしいというか面白いなと思っていて、左手ではいやこれ技術はこうだぞっていうことを言いながら、変わってきたんだから自分はこういうふうに稼ぐべきだとか、資本主義の中でどう立ち振れまうかっていうのを結構考えるんですね。

自動運転車も実は同じようになんかこう安全性の話とか安全側に振る話っていうのをしながらも、でも自動運転社会になった時にそれに乗り遅れないためにっていうのを、多分それくらいの解像度がある人たちは考えるはずで、もう一つちょっと歴史を振り返って思うんですが、自動車って自動車ができてそれが社会をなんか単体で出てきたわけじゃないんですね。

実は自動車ができましたっていった時に自動車保険が出てきたりとか、自動車の安全技術っていうのを開発しなきゃいけないねってそういう会社が出てくるとか産業を起こすっていうのは、自動車を作るだけじゃないんですよ保険を作るとか保険制度を設計するとか法制度を作るとかっていうところも対になって出てくるものであって、そういうことをやってくることができた人類が、自動運転に対して対応できないとは思えないかなと思います。

ちなみになんか最近なんかの本で読んだんですけど、自動車出てきた時に、なんか時速がめちゃくちゃ速いんですよ。

自動車って馬車に比べて健康に悪いっていうビラが出てきて、なぜかというと人間はそもそも時速30キロで走れる体ではないから

めちゃくちゃ危ないっていうのがなんか出てるんですよ。

それをちゃんと医療系の人たちが証明して大丈夫そうですって言って、使ってるんですよね。多分今の我々から見たらいや時速30キロで健康は害されないよははとかって思うんですけど。

多分当時の人から見たらそれちょっと懸念だよなとかって思うはずで、我々が今言ってた懸念ポイントもしくは懸念ポイントってたくさんあるし、ある一方で100年後の未来から見た時に当時の人間運転してたらしいよっていうのは、そっちの方が確からしい未来なんじゃないかなと思っています。 -

司会

ありがとうございます時間の方が迫ってきているので、せっかく会場に来ていただいたんで最後一人じゃあすぐ手が上がったんでちょっと短的になっちゃうかもしれないんですけど一問だけよろしくお願いします。

Q8

-

Q8

非常に興味深いありがとうございました楽しく聞かせていただきました。

もともと注目しててぜひと思ってお伺いしました。

自動車業界で長年働いています質問は全然関係なくて、今回日本語を言語でAIとして初めて英語も対応していると。

言語の特質として例えば処理速度を上げていくのにこっちの言語の方が良さそうとか、そういう感触があれば多分アメリカにいらっしゃった経験とかも踏まえて、もしそういう知見があれば話ていただきたいと。 -

A8

自然言語処理は実は英語の方が圧倒的に有利です。

なぜかというとデータソースが全然違うんですね。

データソース量学習データって一番でかいのはやっぱWikipediaなんですよ。次が記事とかなんですよ。

Wikipediaは英語の記事はめちゃくちゃいっぱいあるんですよね。

自然言語処理これ私もちょこっと触ってた事があって、ちょっとこれは言いづらい話なんですけどアダルトの話アニメの話アイドルの話は、この三つの情報はめちゃくちゃ詳しいんですよ。日本のWikipediaって。

アイドルとアニメの話はめちゃくちゃ使いやすくてそういう単語には詳しいんだけども、テックとか企業の話とかそういうWikipediaがすごく弱いので、実は英語めちゃくちゃ強いですね。

一方で一つ気にしなきゃいけないポイントとしては、少し前ってDeepLという皆さん使ったことがあるかもしれない英訳とか文章の訳を全部AIがやってくれますっていうのが流行ってたんですけど、最近ユーザー数がめちゃくちゃ減っています。なぜかというと翻訳っていうタスクをAIでやってたんですけど、一方でみんなGPTに投げてるんですね。

GPTとかジェミニの方にこの文章訳してくださいっていうと、翻訳のニューラーネットとかに比べると、生成AIっていうのはでっかいんですよ。

でっかいAIの方に翻訳タスクとして投げてくださいっていうと

やってくれるんですよね。こっちの方が性能がいいんです。

てこれは私は結構びっくりしてて翻訳は翻訳で進歩していくものだと思ったら、もう生成AIとかああいうでっかい言語モデルLLMのサブタスク1個のタスクになってしまったっていうのはすごく面白いなと思っていて、この翻訳タスクだけ作ってる人からすると巨人が現れて踏みつぶされちゃったみたいな。

同じようにネットワークをでっかくしてパラメータ数を増やしていくっていうのは、すごく大事なタスクなんじゃないかなとかってここからそういうことを考えてたりします。

話最後おまけをつけちゃいました。 -

(Q8続き)

ありがとうございます -

司会

ありがとうございました

お時間になりましたが最後何か言い残したこととかがもしあれば

まとめ

-

青木CTO

自動運転は非常に楽しい課題だと思います。

100年後絶対できますよとかって言ってできなかったらごめんなさいって、お墓の中で思いますが私は絶対できると思っています。

これはチューリングがやるかやらないか置いておいて人間がやってきた。コンピュータに対して行ってきた進歩の過程と歴史を踏まえたら、自動車の自動運転程度のタスクはAIができるはず。

そして多分我々はすごくいい時代に生きてると私は思ってて、このAIが私たちの仕事をどんどん食っていってそこに対して、一人の人間として対峙していって適用していく。

これ多分100年後の人間とか100年前の人間は考えることができなかった。

すごいいい特異点にいる時代だと思っていて、この変化は恐れずに楽しんでほしいなと思いますし、皆さんの中でもし自動運転とか興味あるとかチューリング興味あるよ。お金もあるよっていう人がいたらもしいたらお声掛けいただけたらと思いますし、非常に面白い課題ですのでチューリング一回置いておいても、見ていただけたらなというふうに思っています。

本日は長い時間でしたがありがとうございました。 -

司会

ありがとうございました今一度の大きな拍手をお願いいたします。

感想

創業者取締役CTOが自ら技術的な方向性を語る会社というのは魅力しかない。

完全自動運転を実現させるための方法論として説得力がある内容でした。

かなり広い範囲の話だったのでしかたがないと思いますが、HeronのマルチモーダルLLMの動きなどもう少し詳しく聞けたら良かったと思います。

LLMを自動運転にどう使うかではなく、LLMを脳と捉え、応用として自動運転させようと考えているのはチューリングだけのような気がしました。

また、日本の危機については大いに同意します。

関連ページ

- Compound Startup構想

- シンギュラリティ・ソサエティ BootCamp#2 Demo Day 対談

- GraphAIハッカソンを開催しました!

- マルチエージェントの「自律的に行動する」とは何か?

- GraphAI Contribution Fes 2025 開催のお知らせ

- async / awaitについて、再確認(超初心者向け)

- 私の寿命、あと何年?

- HtmlRAG: HTML is Better Than Plain Text for Modeling Retrieved Knowledge in RAG Systemsの紹介

- Magentic-One: A Generalist Multi-Agent System for Solving Complex Tasksの紹介

- 書評:LangChainとLangGraphによるRAG・AIエージェント[実践]入門 (エンジニア選書)

- SS推薦の図書

- Singularity Societyに入るには?

- 話題のネコ型ロボット「ミーア」!パワーアップします!

- 「世界モデルを持たないLLM」にとって難しい質問のリスト

- Raycastの機能拡張をカスタマイズ(テンプレート解説)

- RaycastJapan Meetup 第0回 イベントレポート

- Raycastのイベント発表資料

- Macの生産性を10倍上げるRaycastのイベント開催!!

- 「蔦屋家電+」ミーアの展示期間を延長しました!

- 安野たかひろ × 中島聡 緊急対談 書き起こし

- 蔦屋家電+でミーアたちに合う

- 安野たかひろ × 中島聡 緊急対談

- 蔦屋家電+とTi B SHOPでおしゃべり型ロボット「ミーア」に会いに行こう🐾

- W&Bミートアップ#13in東京 Stability AIとTuringからモデルサービングの最新手法を学ぶMeetup

- Turing CTOが語る自動運転2.0 生成AIで実現する次世代自律運転

- サンノゼで開かれたVisionProハッカソンに参加しました!

- おしゃべり猫型ロボット「ミーア」を開発

- コストコを超えるイノベーション!高品質・サプライズ価格なECの立ち上げ

- 空間ジェスチャーアプリを作る

- Turing Semiconductor/AI Day潜入レポ

- アーバンデータチャレンジ2023にてW受賞しました

- visionOSアプリ、Teegardenの開発物語

- エンジニア未経験のPMがChatGPTを使って簡単なプログラミングだけでプロダクトを作った話

- 新しい挑戦を躊躇する心理:優先順位の真実

- 時を超える知の投資:良書と大学教育の意義

- 動画生成AI SORAの革新とサム・アルトマンのビジョン

- イノベーションを起こしやすい組織について

- サッカー選手になりたいが、サッカーボールを蹴ったことがない人の話

- 2024年、国産クラウドに期待

- 仕事と焼肉、意外な共通点とは?

- 業界に激震!!Llama2オープン化がいかにすごいかを解説。

- OpenAIによる今回のアップデートがなぜ私たち開発者たちの間で「神アップデート」と呼ばれているか解説!!

- 統計的自然言語処理によりおぼろげながら浮かんできた思考の仕組みと教育の未来

- アプリ開発の常識を覆す? GPT-4の凄さに魅了された体験談

- あなたの NFT がゴミになるかもよ?

- GPT3の本質を理解し、ChatGPTを使いこなす為に知っておきたい事!!

- 今世紀のベストペーパー

- 「Web3がもたらす未来を考える」中島聡×塚田学対談

- これが未来の生活スタイル。遊牧民のように旅をしながら暮らす理想のノマドライフの提案。

- あなたのNFTは大丈夫?!某NFTが存在するのか確認してみました。

- 元米マイクロソフトのソフトウェアエンジニアが教える「エンジニアになりたいなら知っておいた方がいいコト!」

- 「フルオンチェーンでないNFTの怖さ」が現実に!〜フルオンチェーンNFTを可能にする技術

- 知らないと恐ろしい事に!AM/PM表記のなぞ?!

- DAOに対する「株式会社に代わる新しい仕組み」や「参加者全員が成功の果実を共有できる」という認識は間違いです。DAOの本質とは?

- スマートコントラクトが人々の行動を変え世界を変える!!

- フルブロックチェーンのスマートコントラクトは世の中に価値を提供し続ける!

- ビットコインこそ「究極のDAO」

- Pride Squiggle で画像をオンチェーンでダイナミックに生成するために使ったテクニック

- Netscapeからシェアを奪い取ったInternet Explorerが、終焉してしまった理由

- ソフトウェア・アーキテクチャの面からWeb2.0とWeb3の違いを分かり易く解説

- Web3の技術は素晴らしいがそれを生かすも殺すもエンジニア次第!

- AppleのWWDC22の基調講演で、最も私に刺さったのはCarPlay!!これが何を意味するのか?!

- Web3時代!NounsDAOの最大の発明はこれだ!

- 日本のシステムは最大のポンジースキームだった!?

- そして、すべてはソフトウェアになった

- パーソナル・ブランディング

- あなたの知らないWeb3/NFT/DAOの真実

- ハッカソン開会式のご挨拶「過去の戦争と比べて違うなと思うところ」

- NounsDAOをフォークした人にインタビューを受けました(翻訳)

- すでに解散したバンドのファンになった話

- 帝国化する企業と民主主義の末路

- 衰退していく日本のテレビ業界について語る

- Youtube のダークサイド

- 「理解できない」と言える強さ

- Oculus Go

- メタバース時代に掘り起こせそうな本屋さん

- 日本は少子高齢化・人口減少で新しい枠組みを作るのに良い実験場-<コモン>の領域を再建し人々の生活を安定させる

- Nintendo Switch とエクササイズ・バイク

- こんなダメな日本がかわるきっかけは「戦争か大災害しかない」噴火・地震・メタバースなど

- カルト・オンライン

- 中島聡×草場 壽一 「ソサエティを立ち上げた思い」

- 人工知能・機械学習の父

- 起業家と現実歪曲空間

- デマンド交通『おでかけ号』のタクシー予約/配車システムをDX化、高知・土佐清水で新登場

- 中島聡×SONY社内イベント

- メルカリ × 中島聡 ディスカッション イベントレポート

- 自動車業界の近未来

- 未来の社会のあり方

- SS推薦の動画

- 汎用人工知能・強いAIの開発にまつわる懸念点

- 未来のソフトウェアエンジニア教育を考える

- 財政出前講座 SIM2030

- Elon Musk の悩み

- Elon Musk のビジョン

- 自動運転社会のひとつの形

- Amazon Goに行ってみた

- 中島さん関連動画